Hoofdstuk 5 Statistische besluitvorming

Alle kennisclips die in dit hoofdstuk zijn verwerkt kan je in deze youtube playlist vinden:

Link naar webpage/script die wordt gebruik in de kennisclips:

5.1 Inleiding

In dit hoofdstuk zullen we werken rond de Captopril dataset. Captopril is een medicijn dat wordt voorgeschreven bij hypertensie en chronisch hartfalen. Het behoort tot de klasse van ACE remmers die activiteit van het renine-angiotensine-aldosteronsysteem onderdrukken. Dat systeem zet het hormoon angiotensineI om in angiotensine II, die een krachtige vaatvernauwende werking heeft. ACE remmers verminderen de omzetting van angiotensine I naar angiotensine II waardoor de vaatvernauwing wordt onderdrukt. Tijdens de ontwikkeling van het medicijn werd een eerste kleine studie opgezet om na te gaan of captopril een bloeddrukverlagend effect heeft bij patiënten met hypertensie.

Observaties bij een klein aantal subjecten mogen een onderzoeker er dan al van overtuigen iets nieuws te hebben ontdekt, maar om anderen te overtuigen zijn objectieve, wetenschappelijke argumenten nodig. Vooreerst moeten de resultaten voldoende representatief zijn, d.w.z. veralgemeenbaar naar een ruime biologische populatie (bvb. naar de volledige populatie van patiënten met hypertensie). Ten tweede moet er rekening mee gehouden worden dat de resultaten variabel zijn, d.w.z. dat men door toeval doorgaans andere resultaten zou vinden indien men een andere, vergelijkbare groep subjecten zou analyseren. Om die reden is het belangrijk om uit te drukken in welke mate de resultaten (bvb. de geschatte bloeddrukdaling) zouden variëren van steekproef tot steekproef en of men op basis van de steekproef kan aantonen dat er een effect is van een behandeling (b.v. dat het middel captopril bloeddrukverlagend werkt in de populatie). Dit vormt het doel van dit hoofdstuk.

Om een representatieve groep subjecten te waarborgen, vertrekt een goede onderzoeksopzet vanuit een belangrijke, precies geformuleerde vraagstelling omtrent een duidelijk omschreven populatie.

Zoals eerder in de cursus aangegeven, zal men in de praktijk om financiële en logistieke redenen bijna nooit een

volledige populatie kunnen bestuderen.

Populatieparameters kunnen daarom meestal

niet exact bepaald worden. Enkel een deel van de populatie kan onderzocht

worden, wat men een steekproef noemt. Volgens een

gestructureerd design worden daartoe lukraak subjecten uit de doelpopulatie

getrokken en geobserveerd. De onbekende parameters worden vervolgens geschat

o.b.v. die steekproef en noemt men schattingen. In de praktijk hoopt men uiteraard dat de schattingen die men bekomt op basis van de steekproef vergelijkbaar zijn met de overeenkomstige populatieparameters die men voor de volledige populatie zou bekomen.

Typisch kan de onderzoeksvraag worden vertaald naar een populatieparameter.

Ze kan bijvoorbeeld worden uitgedrukt in termen van een populatiegemiddelde, bijvoorbeeld de gemiddelde bloeddrukverandering na de inname van captopril bij patiënten met hypertensie.

5.2 Captopril voorbeeld

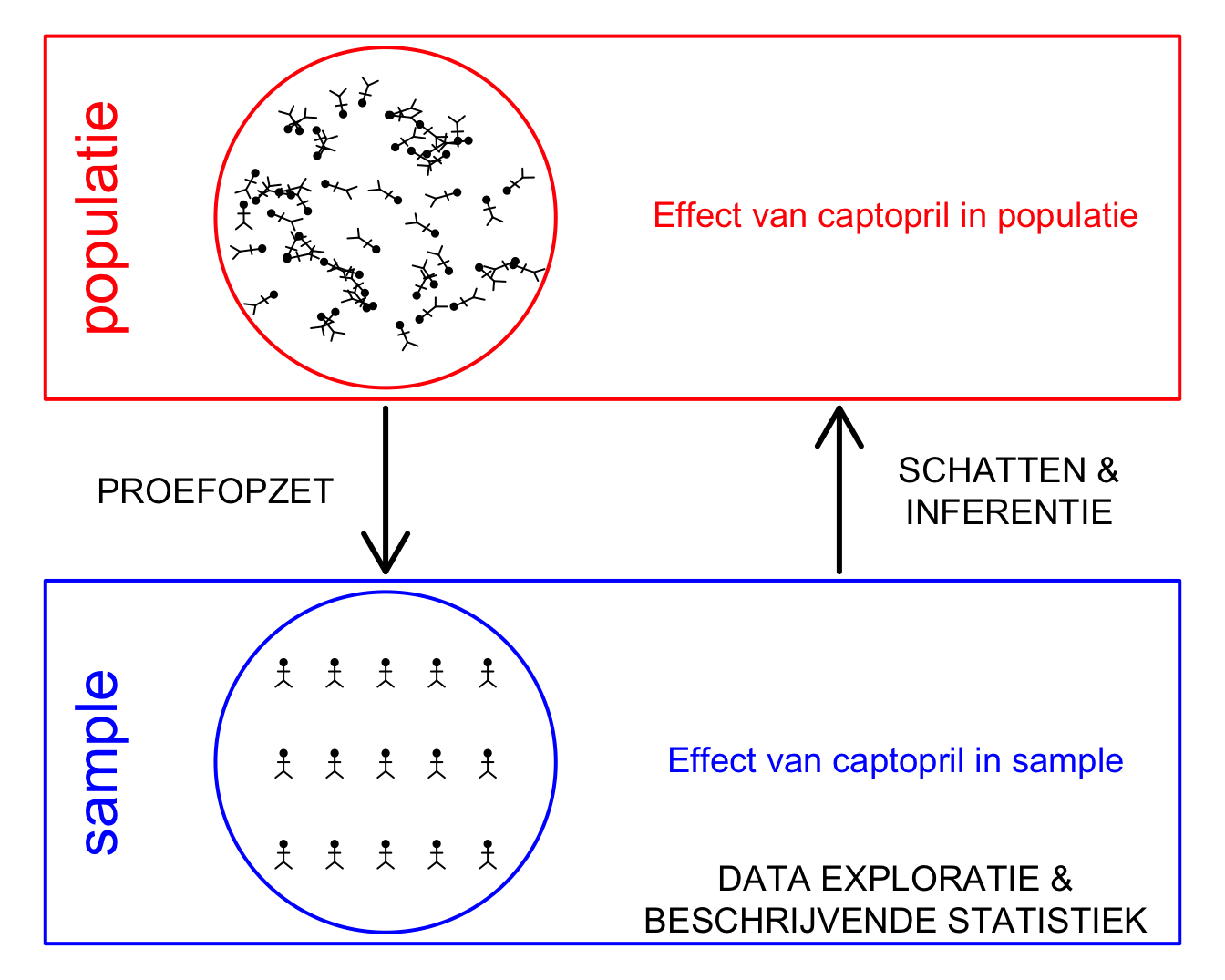

Onderzoekers wensen na te gaan of het medicijn Captopril een bloeddruk verlagend effect heeft. De onderzoekers wensen uitspraken te kunnen doen over het effect van captopril op de systolische bloeddruk van huidige en toekomstige patiënten met hypertensie, m.a.w. ze wensen uitspraken te doen over het effect van captopril op het niveau van de Populatie. Ze zullen hiervoor een experiment opzetten om het effect van captopril bestuderen (Proefopzet) waarbij een steekproef (sample) van de patiënten met hypertensie is getrokken uit de populatie. Vervolgens zullen ze de data exploreren en het effect van captopril besturen in de steekproef (Data Exploratie & Beschrijvende Statistiek). Op basis van de steekproef zullen ze dan het effect van captopril Schatten in de populatie en zullen ze a.d.h.v. methoden uit Statistische besluitvorming23 nagaan in hoeverre de geobserveerde effecten in de steekproef veralgemeend kunnen worden naar de algemene populatie toe.

Deze verschillende stappen worden geïllustreerd in Figuur 5.1.

Figuur 5.1: Verschillende stappen in de captopril studie.

5.2.1 Proefopzet

Bij proefopzet zullen we een gestructureerd design voorstellen om lukraak subjecten uit de doelpopulatie te selecteren, toe te wijzen aan een behandeling en te observeren. We zullen hierbij een response variabele meten, een karakteristiek van interesse. In het captopril voorbeeld is dit de systolische bloeddruk.

In de captopril studie hebben de onderzoekers gebruik gemaakt van een een pre-test/post-test design. De patiënten werden at random gekozen uit de populatie. Van elke patiënt in de studie werd de systolische en diasystolische bloeddruk gemeten voor en na het toedienen van captopril. Het pre-test/post-test design heeft als voordeel dat we het effect van het toedienen van captopril op de bloeddruk kunnen meten voor elke patiënt. Een nadeel daarentegen is dat er geen controle behandeling is waardoor we een mogelijkse bloeddrukverlaging niet noodzakelijkerwijs kunnen toeschrijven aan de werking van captopril. Er zou immers ook een placebo-effect kunnen optreden waardoor de bloeddruk van de patiënt daalt omdat men weet dat men een medicijn kreeg tegen een hoge bloeddruk.

5.2.2 Data Exploratie & Beschrijvende Statistiek

Eens de data zijn geobserveerd, is het belangrijk om deze te exploreren om inzicht te krijgen in hun verdeling en karakteristieken.

Vervolgens zullen we de gegevens samenvatten zodat we het effect van interesse kunnen kwantificeren in de steekproef.

In deze studie is de systolische bloeddruk en de diasystolische bloeddruk gemeten voor elke patiënt voor en na het toedienen van captopril.

De data is beschikbaar in een tekstbestand met naam captopril.txt op de github pagina https://raw.githubusercontent.com/statOmics/sbc/master/data/captopril.txt.

We zullen eerst exploreren welke figuren nuttig zijn in onze context.

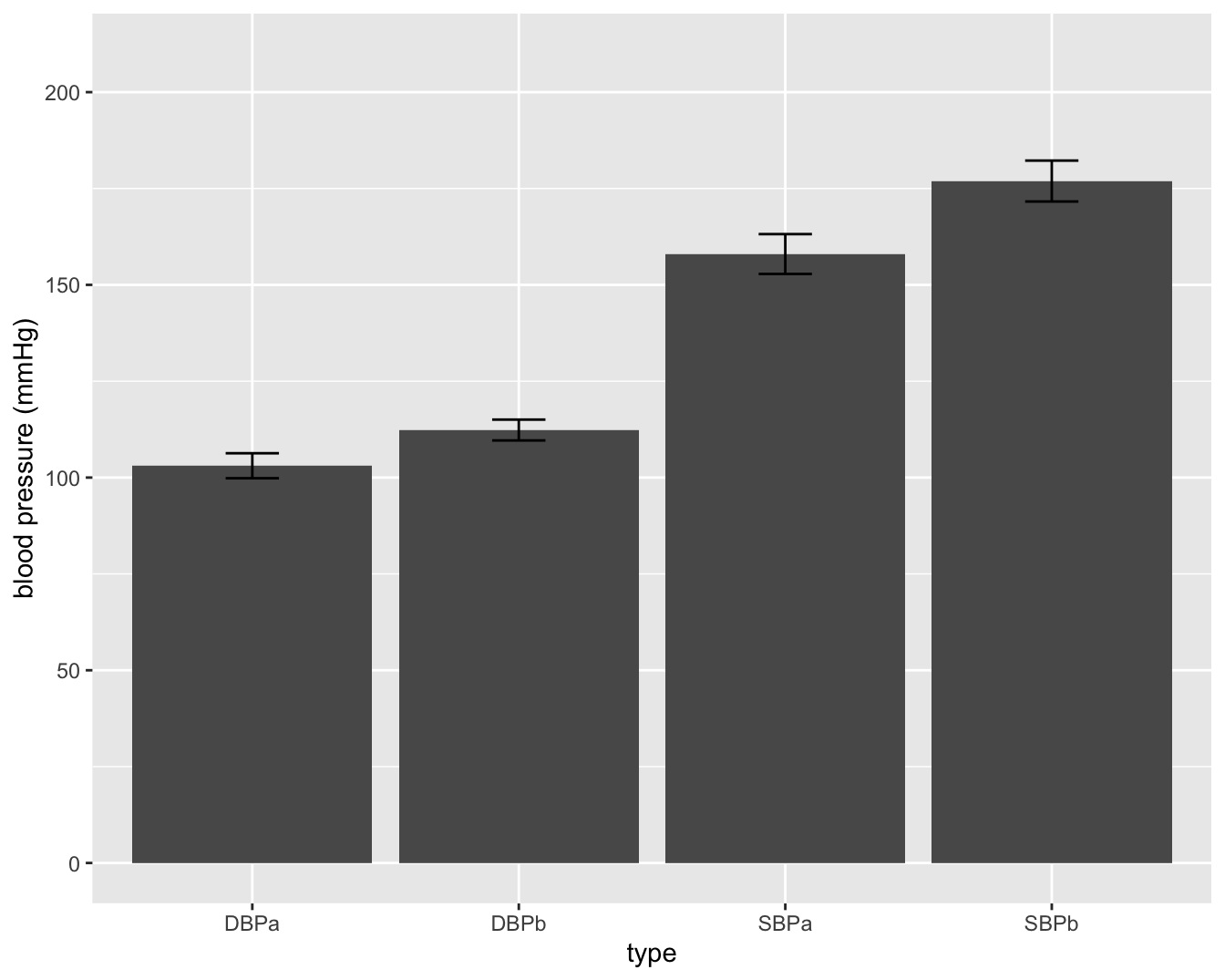

In wetenschappelijke artikels worden vaak figuren gemaakt van het gemiddelde en de standaardafwijking (zie Figuur 5.2).

#Eerst lezen we de data in.

#Deze bevindt zich in de subdirectory dataset

#Het is een tekstbestand waarbij de kolommen van elkaar gescheiden zijn d.m.v kommas.

#sep=","

#De eerste rij bevat de namen van de variabelen

captopril <- read.table("https://raw.githubusercontent.com/statOmics/sbc/master/data/captopril.txt",header=TRUE,sep=",")

head(captopril)## id SBPb DBPb SBPa DBPa

## 1 1 210 130 201 125

## 2 2 169 122 165 121

## 3 3 187 124 166 121

## 4 4 160 104 157 106

## 5 5 167 112 147 101

## 6 6 176 101 145 85captoprilTidy <- captopril %>% gather(type,bp,-id)

captoprilTidy %>%

group_by(type) %>%

summarize_at("bp",list(mean=~mean(.,na.rm=TRUE),

sd=~sd(.,na.rm=TRUE),

n=function(x) x%>%is.na%>%`!`%>%sum)) %>%

mutate(se=sd/sqrt(n))## # A tibble: 4 × 5

## type mean sd n se

## <chr> <dbl> <dbl> <int> <dbl>

## 1 DBPa 103. 12.6 15 3.24

## 2 DBPb 112. 10.5 15 2.70

## 3 SBPa 158 20.0 15 5.16

## 4 SBPb 177. 20.6 15 5.31captoprilTidy %>%

group_by(type) %>%

summarize_at("bp",list(mean=~mean(.,na.rm=TRUE),

sd=~sd(.,na.rm=TRUE),

n=function(x) x%>%is.na%>%`!`%>%sum)) %>%

mutate(se=sd/sqrt(n)) %>%

ggplot(aes(x=type,y=mean)) +

geom_bar(stat="identity") +

geom_errorbar(aes(ymin=mean-se, ymax=mean+se),width=.2) +

ylim(0,210) +

ylab("blood pressure (mmHg)")

Figuur 5.2: Barplot van de gemiddelde bloeddruk in de captopril studie. De foutenvlag is 2x de standaard deviatie op de metingen (SBPb: systolic BloodPressure before, DBPb: Diasystolic BloodPressure before, SBPa: systolic BloodPressure after, DBPa: Diasystolic BloodPressure after).

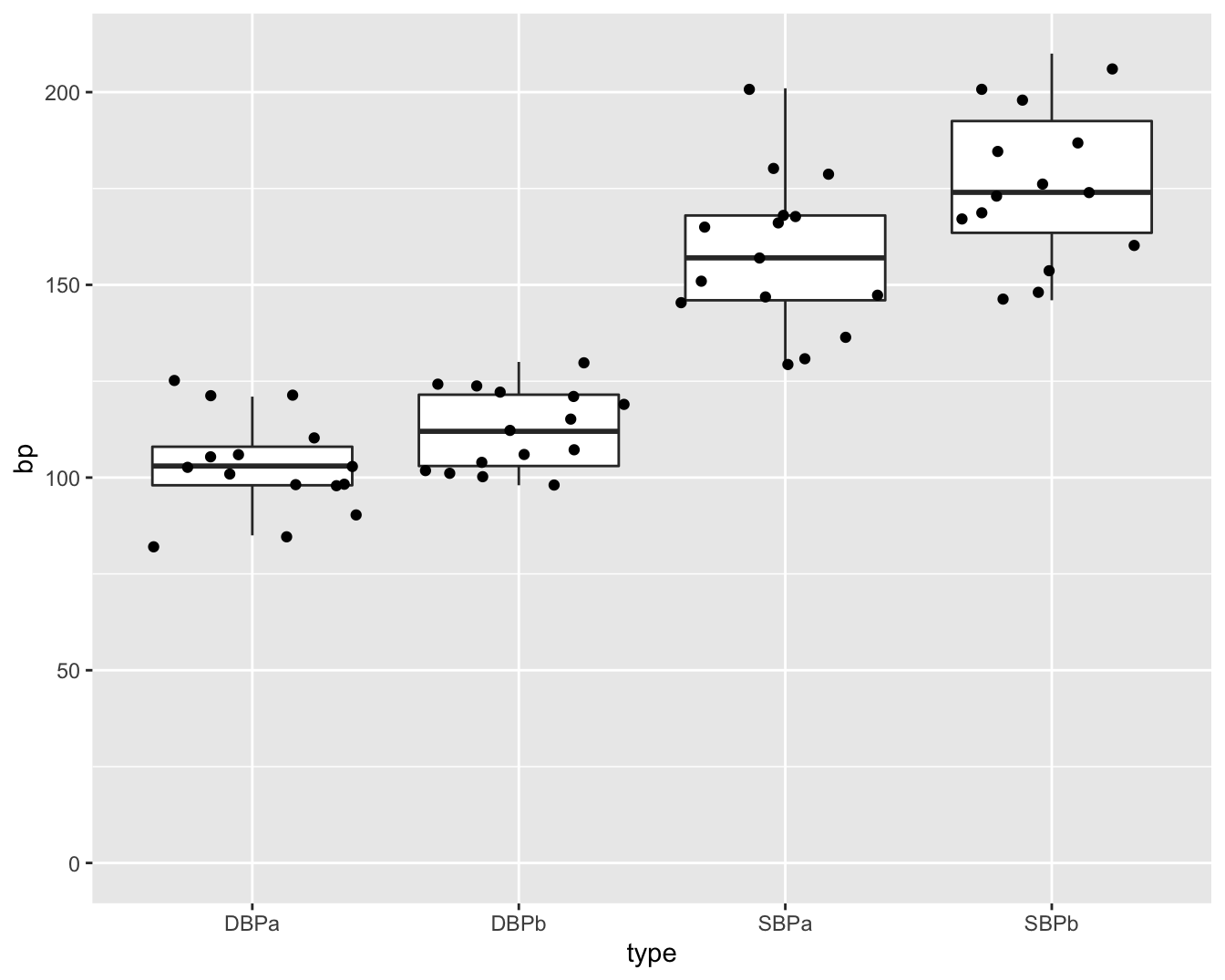

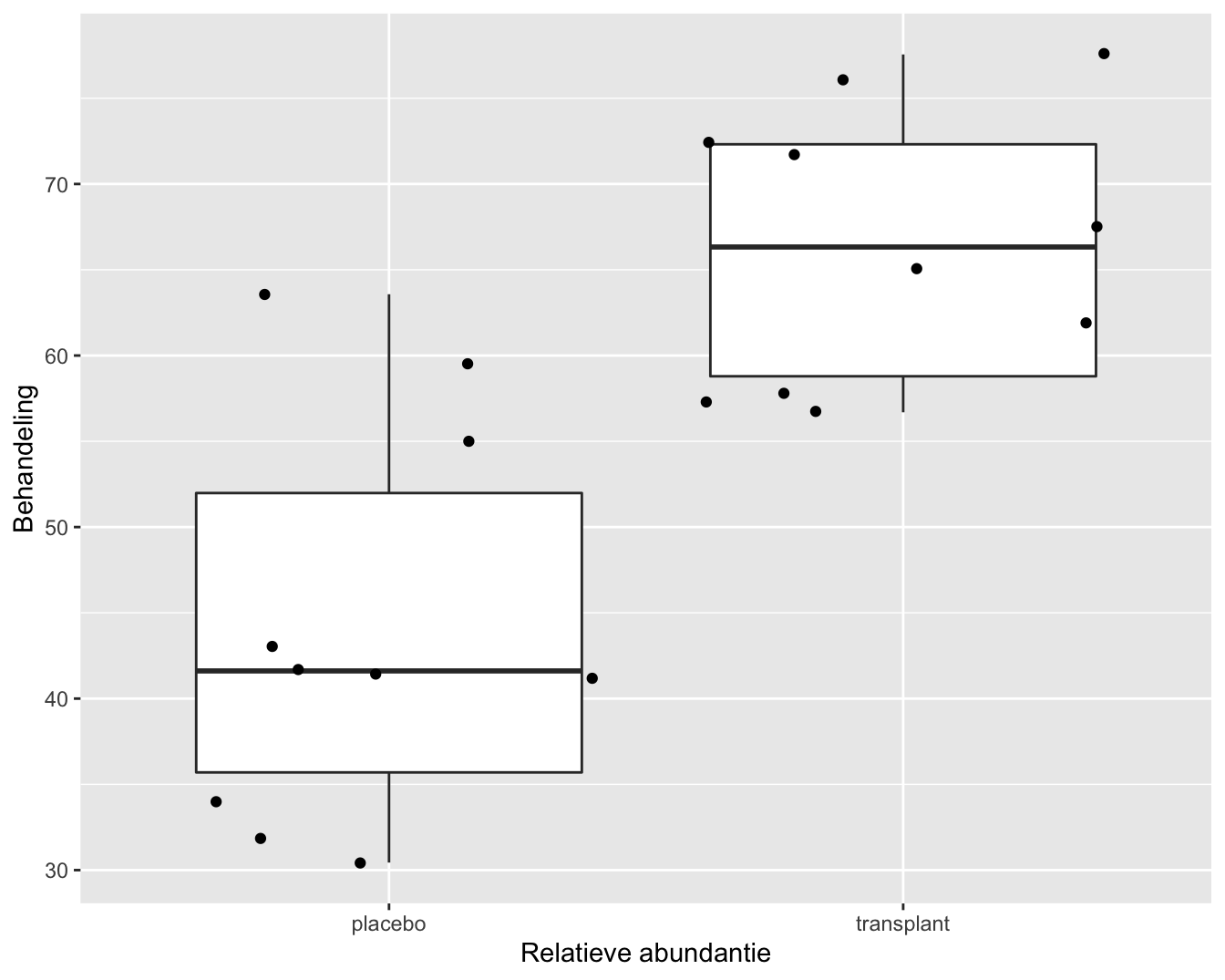

De figuur is echter niet informatief. De hoogte van de balken zegt enkel iets over het gemiddelde. We kunnen onmogelijk weten wat het bereik van de ruwe gegevens is bijvoorbeeld. Daarom is het beter om de gegevens zo ruw mogelijk weer te geven in een plot. We kunnen hiervoor bijvoorbeeld gebruik maken van boxplots (Figuur 5.3). Aangezien we maar over 15 patiënten beschikken kunnen we ook de ruwe datapunten toevoegen. In de figuur zien we dat de systolische bloeddruk in de steekproef gemiddeld lager ligt na de behandeling met captopril. We krijgen ook een duidelijk beeld op het bereik van de data.

#toevoegen van originele datapunten op de plot

#jitter zal de punten random verspreiden

captoprilTidy %>%

ggplot(aes(x=type,y=bp)) +

geom_boxplot(outlier.shape=NA) +

geom_point(position="jitter") +

ylim(0,210)

Figuur 5.3: Boxplot en ruwe data van de bloeddruk in de captopril studie (SBPb: systolic BloodPressure before, DBPb: Diasystolic BloodPressure before, SBPa: systolic BloodPressure after, DBPa: Diasystolic BloodPressure after).

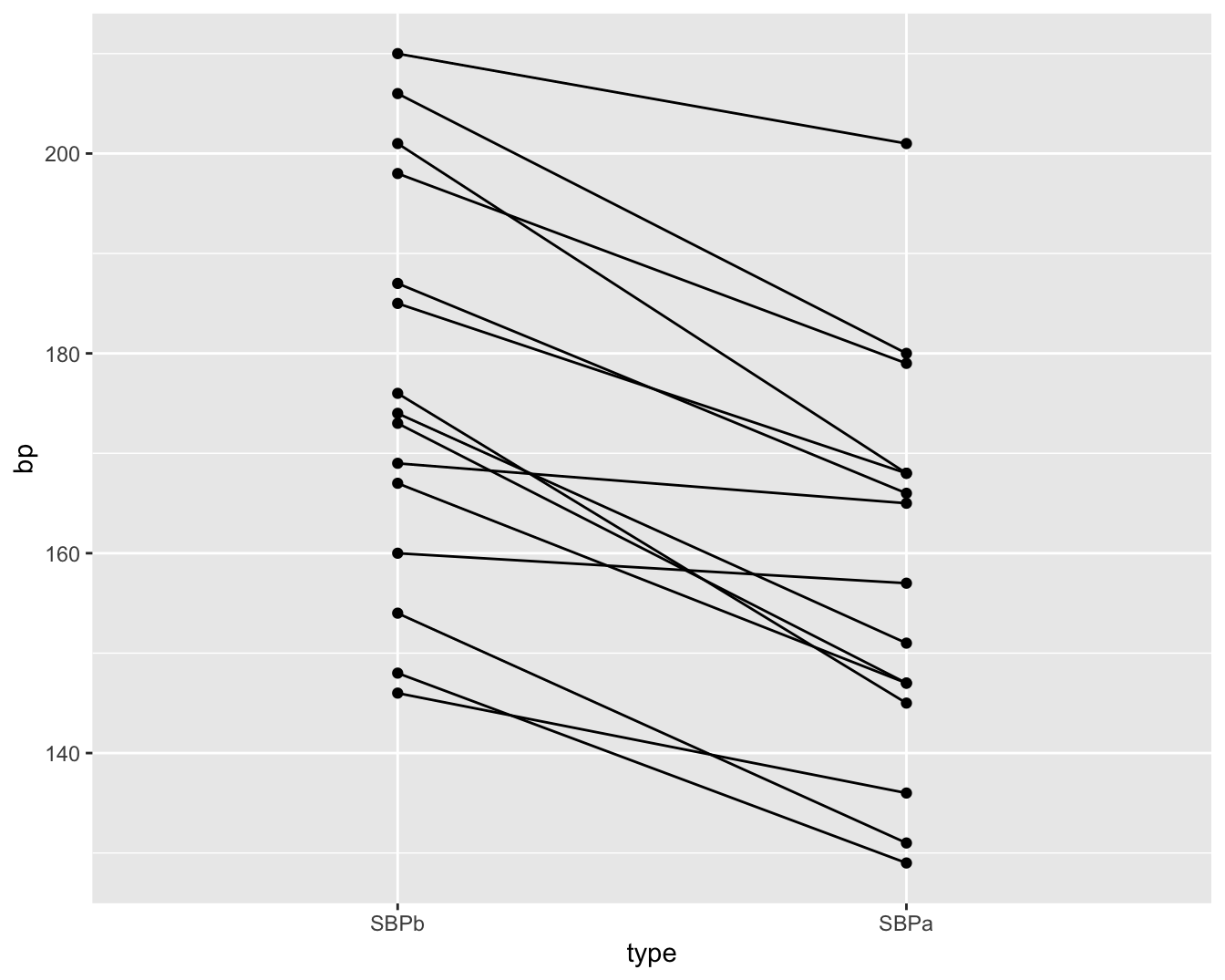

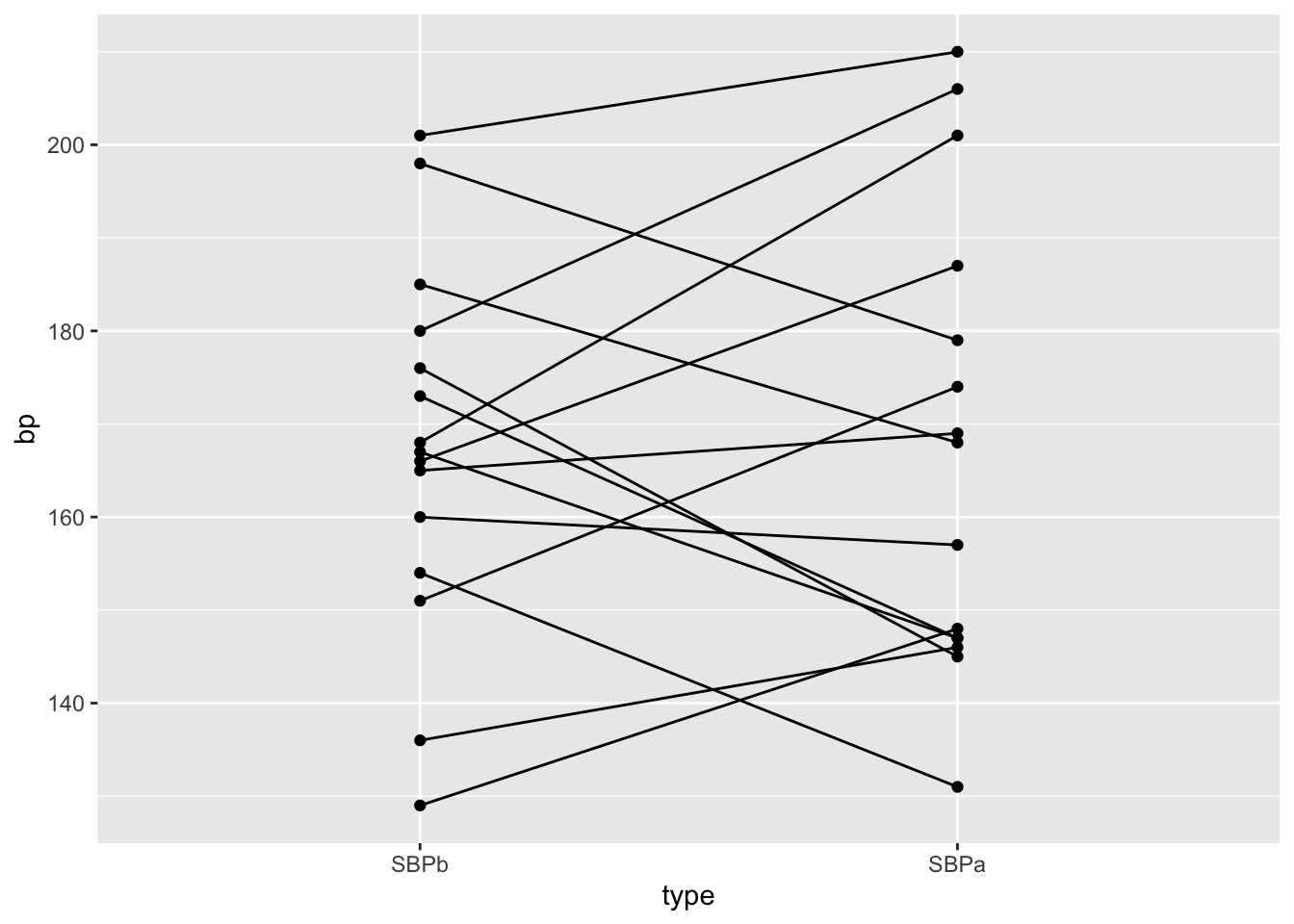

Als alle bloeddrukmetingen onafhankelijk zouden zijn dan is Figuur 5.3 een goede figuur om de data te exploreren. We weten echter dat de metingen voor en na het toedienen van captopril afkomstig zijn van dezelfde patiënt. We kunnen die informatie toevoegen in een dotplot zoals we illustreren voor de systolische bloeddruk in Figuur 5.4. In deze figuur zijn de twee bloeddrukmetingen voor dezelfde persoon verbonden met een lijn. Deze figuur geeft duidelijk weer dat de bloeddruk daalt voor elke patiënt wat een sterke aanwijzing is dat er een effect is van het toedienen van captopril op de systolische bloeddruk.

#De geom_line layer laat ons de bloeddrukmetingen voor dezelfde personen verbinden met een lijn

captoprilTidy %>%

filter(type%in%c("SBPa","SBPb")) %>%

mutate(type=factor(type,levels=c("SBPb","SBPa"))) %>%

ggplot(aes(x=type,y=bp)) +

geom_line(aes(group = id)) +

geom_point()

Figuur 5.4: Dotplot van de systolische bloeddruk in de captopril studie voor en na het toedienen van captopril.

Aangezien we slechts twee bloeddrukmetingen hebben per patiënt kunnen we het effect van captopril ook berekenen per patiënt door het verschil in de systolische bloeddruk na en voor de toediening van captopril te berekenen. Dat is één van de voordelen van een pre-test/post-test design.

#we selecteren de bloeddruk na en voor toedienen

#uit de dataset via naam van variabele d.m.v. $-teken

#en berekenen het verschil

delta <- captopril$SBPa-captopril$SBPb

captopril$deltaSBP <- delta

captopril %>%

ggplot(aes(x="Systolic blood pressure",y=deltaSBP)) +

geom_boxplot(outlier.shape=NA) +

geom_point(position="jitter")+

ylab("Difference (mm mercury)") +

xlab("")

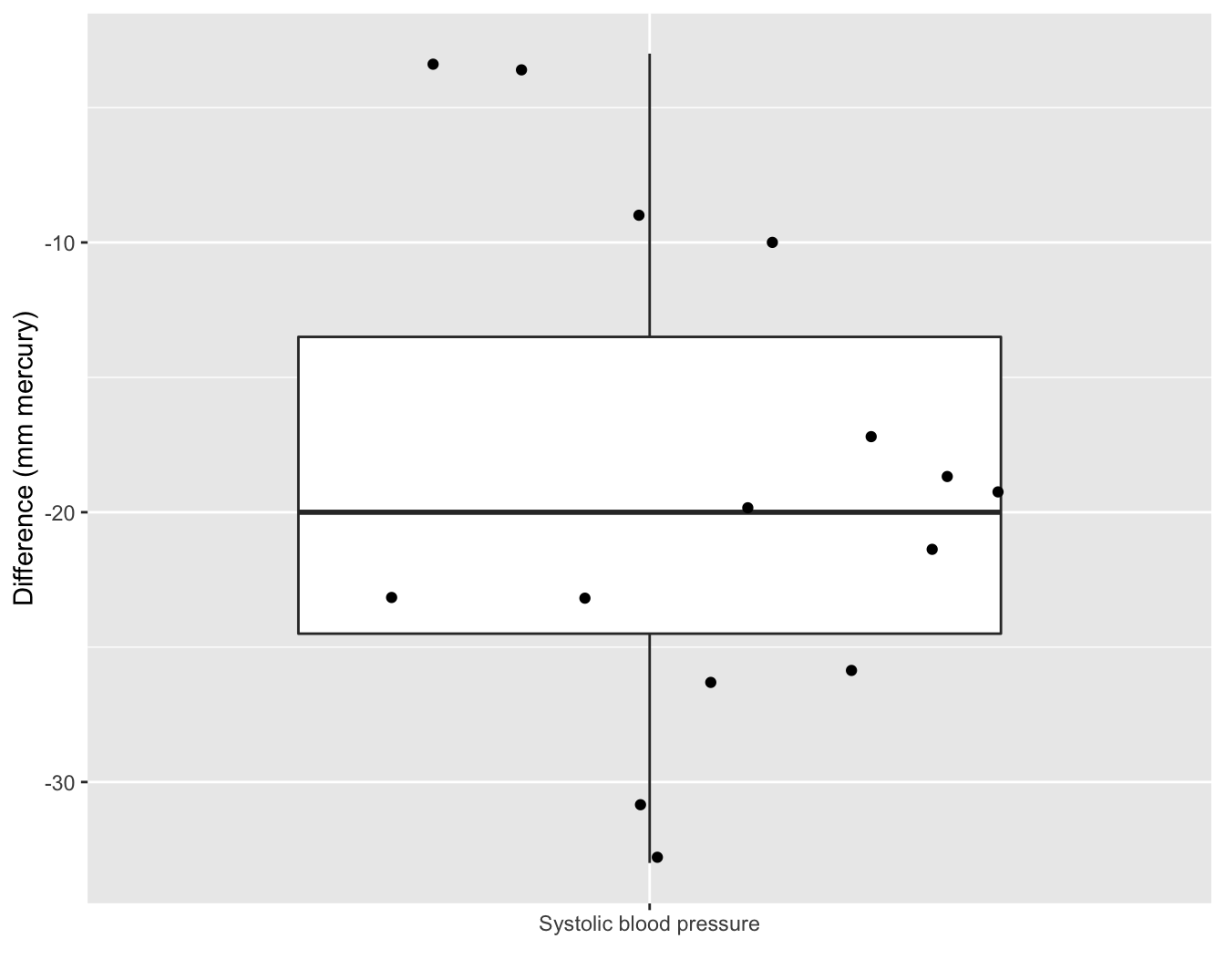

Figuur 5.5: Boxplot van het verschil in systolische bloeddruk voor en na het toedienen van captopril.

We observeren in Figuur 5.5 een bloeddrukdaling voor elke patiënt in de steekproef wat opnieuw een heel sterke indicatie is voor een gunstig effect van het toedienen van captopril op de bloeddruk. De verschillen in systolische bloeddruk zijn een goede maat om het effect van captopril te bepalen. We kunnen de data als volgt samenvatten.

captopril %>%

summarize_at("deltaSBP",list(mean=~mean(.,na.rm=TRUE),

sd=~sd(.,na.rm=TRUE),

n=function(x) x%>%is.na%>%`!`%>%sum)) %>%

mutate(se=sd/sqrt(n))## mean sd n se

## 1 -18.93333 9.027471 15 2.330883We observeren gemiddeld een systolische bloeddrukdaling van 18.93 mmHg en een standaard deviatie van 9.03 mmHg.

5.2.3 Schatten

Pre-test/post-test design: Het effect van captopril in de steekproef kan worden bestudeerd door het verschil te bepalen in systolische bloeddruk na en voor de behandeling (\(X=\Delta_\text{na-voor}\))! Hoe kunnen we de bloeddrukverschillen modelleren en het effect van het toedienen van captopril schatten?

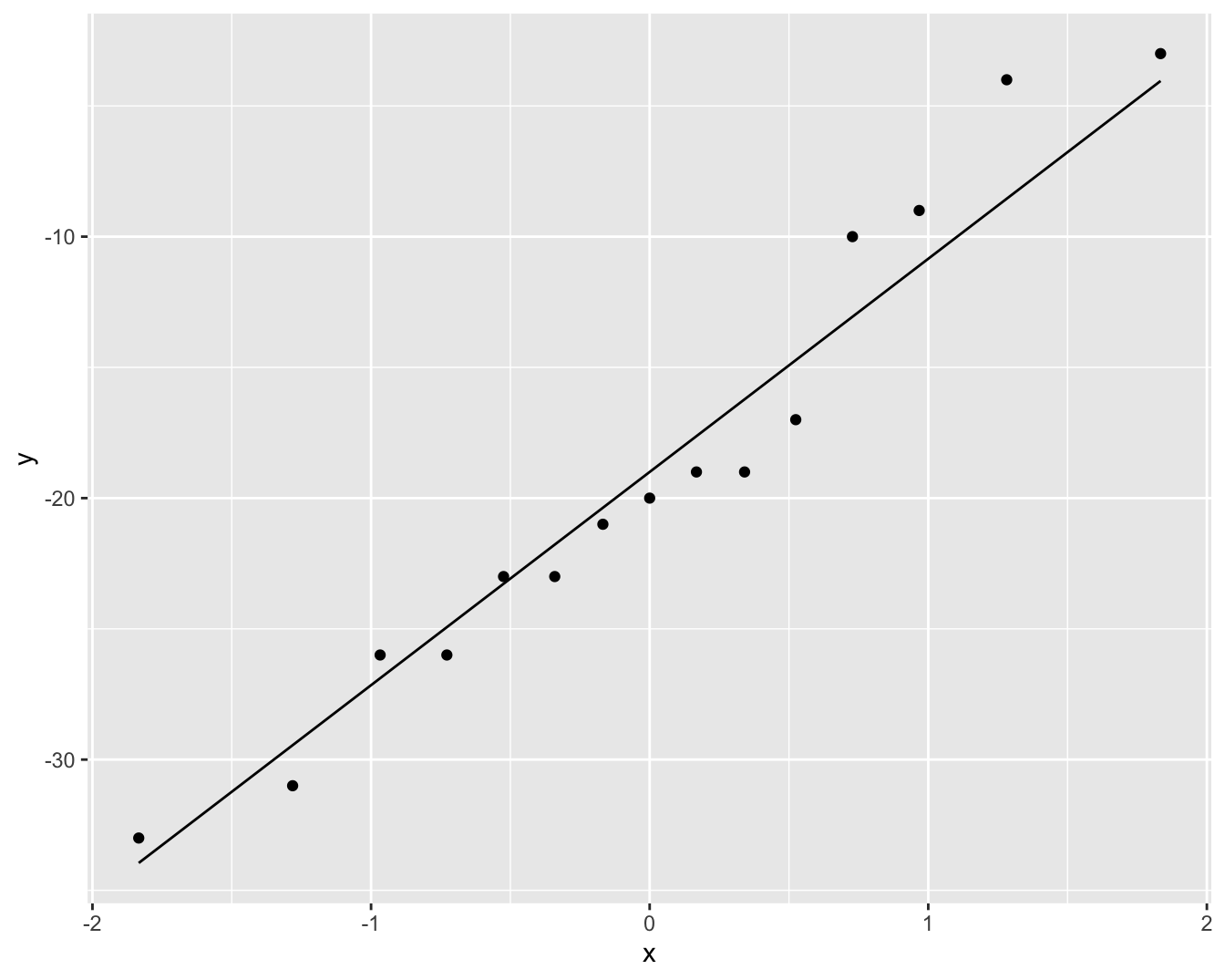

Figuur 5.6: QQ-plot voor het verschil in systolische bloeddruk voor en na het toedienen van captopril.

We zien geen grote afwijkingen van Normaliteit in Figuur 5.6. We kunnen de bloeddrukverschillen dus modelleren aan de hand van een Normale verdeling en kunnen het effect van captopril in de populatie beschrijven a.d.h.v. de gemiddelde bloeddrukverschil \(\mu\). Het bloeddrukverschil \(\mu\) in de populatie kan worden geschat a.d.h.v. het steekproefgemiddelde \(\bar x\)=-18.93 en de standaard afwijking \(\sigma\) a.d.h.v. de steekproefstandaarddeviatie \(\text{SD}\)=9.03.

We vragen ons nu af of het effect dat we observeren in de steekproef groot genoeg is om te kunnen spreken van een effect van captopril in de populatie. We weten immers dat onze statistiek voor de schatting van het effect van captopril in de populatie berekend wordt op basis van de gegevens uit de steekproef en daarom zal variëren van steekproef tot steekproef. Het is daarom belangrijk om een inzicht te krijgen in hoe het steekproefgemiddelde zal variëren van steekproef tot steekproef.

5.3 Puntschatters: het steekproefgemiddelde

Zij \(X\) een lukrake trekking uit de populatie van de bestudeerde karakteristiek en onderstel dat haar theoretische verdeling (bvb. de Normale verdeling) een gemiddelde \(\mu\) en variatie \(\sigma^2\) heeft. Onderstel bovendien dat we geïnteresseerd zijn in het gemiddelde \(\mu\) van die karakteristiek in de studiepopulatie. Dan kunnen we \(\mu\) schatten op basis van een eenvoudige lukrake steekproef, \(X_1,...,X_n\), als het (rekenkundig) gemiddelde

\[\begin{equation*} \bar X = \frac{X_1+ X_2+ ... + X_n}{n} = \frac{\sum_{i=1}^{n} X_i}{n} \end{equation*}\]

van de toevalsveranderlijken \(X_1,X_2, ..., X_n\). Dit wordt het steekproefgemiddelde genoemd. Het is belangrijk om te begrijpen dat het steekproefgemiddelde opnieuw een toevalsveranderlijke24 is, d.w.z. dat haar waarde zal variëren van steekproef tot steekproef. Hoewel er slechts 1 populatie is, zijn er heel wat verschillende steekproeven die men daaruit kan trekken. Dat heeft tot gevolg dat verschillende onderzoekers (die verschillende steekproeven uit dezelfde populatie analyseren) verschillende waarden zullen vinden voor het steekproefgemiddelde. Om die reden heeft het steekproefgemiddelde zelf een verdeling. Men zou die theoretisch kunnen bekomen door een oneindig aantal keer een steekproef van \(n\) experimentele eenheden uit de populatie te trekken, telkens het steekproefgemiddelde te berekenen en al deze steekproefgemiddelden vervolgens uit te zetten in een histogram.

We zullen in deze sectie de theoretische verdeling van het steekproefgemiddelde bestuderen. Dat is belangrijk (a) omdat ze ons inzicht geeft in welke mate het resultaat van de studie zou variëren indien men een nieuwe, gelijkaardige studie zou opzetten; en (b) omdat ze ons leert hoe ver \(\bar X\) van het gezochte populatiegemiddelde \(\mu\) kan afwijken. Omdat we slechts over 1 steekproef beschikken (en dus slechts over 1 observatie voor \(\bar X\)), is het niet evident25 hoe we inzicht kunnen ontwikkelen in de verdeling van het steekproefgemiddelde. In het vervolg van deze sectie tonen we hoe dit toch mogelijk is op basis van de beschikbare steekproef wanneer we bepaalde aannames doen over de gegevens.

5.3.1 Overzicht

- Het steekproefgemiddelde is onvertekend

- Precisie van steekproefgemiddelde

- Distributie van steekproefgemiddelde

5.3.2 Het steekproefgemiddelde is onvertekend

In de praktijk hoopt men uiteraard dat de schattingen die men bekomt op basis van de steekproef vergelijkbaar zijn met de overeenkomstige populatieparameters die men voor de volledige populatie zou bekomen.

Of dat zo is, hangt er in eerste instantie vanaf of de steekproef representatief is voor de studiepopulatie en bijgevolg of men al dan niet lukraak individuen uit de populatie gekozen heeft ter observatie (m.a.w. het hangt af van het design van de studie).

Omwille hiervan is het design van een studie van primair belang om lukrake en representatieve steekproeven te garanderen (zie Sectie 3.2). Zoals u doorheen deze cursus zult vaststellen, zullen de meeste wetenschappelijke rapporten daarom een gedetailleerde beschrijving geven van de manier waarop de data bekomen werden. Dit moet de lezer toelaten om de validiteit van de studie te beoordelen.

Algemeen zullen we met \(E(X)\), \(\text{Var}(X)\) en \(\text{Cor}(X,Y)\) respectievelijk het gemiddelde, de variantie en de correlatie noteren van 2 toevalsveranderlijken \(X\) en \(Y\) in de populatie. Deze worden respectievelijk de theoretische verwachtingswaarde van \(X\), theoretische variantie van \(X\) en theoretische correlatie van \(X\) en \(Y\) genoemd. Men zou ze bekomen door voor alle individuen in de populatie de karakteristieken \(X\) en \(Y\) op te meten en vervolgens respectievelijk het rekenkundig gemiddelde, de variantie en de Pearson correlatie te berekenen. Om die reden blijven de rekenregels voor gemiddelden en varianties geldig26 voor populatiegemiddelden en -varianties.

In de onderstelling dat we over een eenvoudige lukrake steekproef beschikken van metingen \(X_1,...,X_n\) voor een karakteristiek \(X\), volgen \(X_1,...,X_n\) allen dezelfde verdeling. In het bijzonder hebben ze allen gemiddelde \(\mu\) en variantie \(\sigma^2\); d.i. \(E(X_1)=...=E(X_n)=\mu\) en \(\text{Var}(X_1)=...=\text{Var}(X_n)=\sigma^2\). Het feit dat we subjecten 1 tot \(n\) lukraak uit de populatie getrokken hebben, staat er m.a.w. garant voor dat verdeling van de karakteristiek in deze steekproef representatief is voor de theoretische verdeling in de doelpopulatie. Gebruik makend van de rekenregels voor gemiddelden, vinden we bijgevolg dat:

\[\begin{eqnarray*} E(\bar X) &=& E \left(\frac{X_1+ X_2+ ... + X_n}{n}\right) \\ &= & \frac{E(X_1)+ E(X_2)+ ... + E(X_n)}{n} \\ &=& \frac{\mu + \mu + ... +\mu}{n} \\ &= & \mu \end{eqnarray*}\]

Dit geeft aan dat het verwachte steekproefgemiddelde in een eenvoudige lukrake steekproef gelijk is aan het beoogde populatiegemiddelde \(\mu\). Men zegt dan dat \(\bar X\) een onvertekende schatter is voor \(\mu\). We kunnen in dat geval verwachten dat de waarde \(\bar x\) die we schatten voor \(\mu\) op basis van de steekproef, niet systematisch hoger of lager dan de gezochte waarde \(\mu\) zal zijn. Het spreekt voor zich dat dit een zeer wenselijke eigenschap is.

{.definition, name="Onvertekende schatter"}

Een statistiek of schatter \(S\) voor een

parameter \(\theta\) wordt onvertekend genoemd als haar theoretische

verwachtingswaarde gelijk is aan die parameter, d.w.z. \(E(S)= \theta\).

Einde definitie

5.3.3 Imprecisie/standard error

Het feit dat het steekproefgemiddelde (over een groot aantal vergelijkbare studies) gemiddeld gezien niet afwijkt van de gezochte waarde \(\mu\), impliceert niet dat ze niet rond die waarde varieert. Om inzicht te krijgen hoe dicht we het steekproefgemiddelde bij \(\mu\) mogen verwachten, wensen we bijgevolg ook haar variabiliteit te kennen.

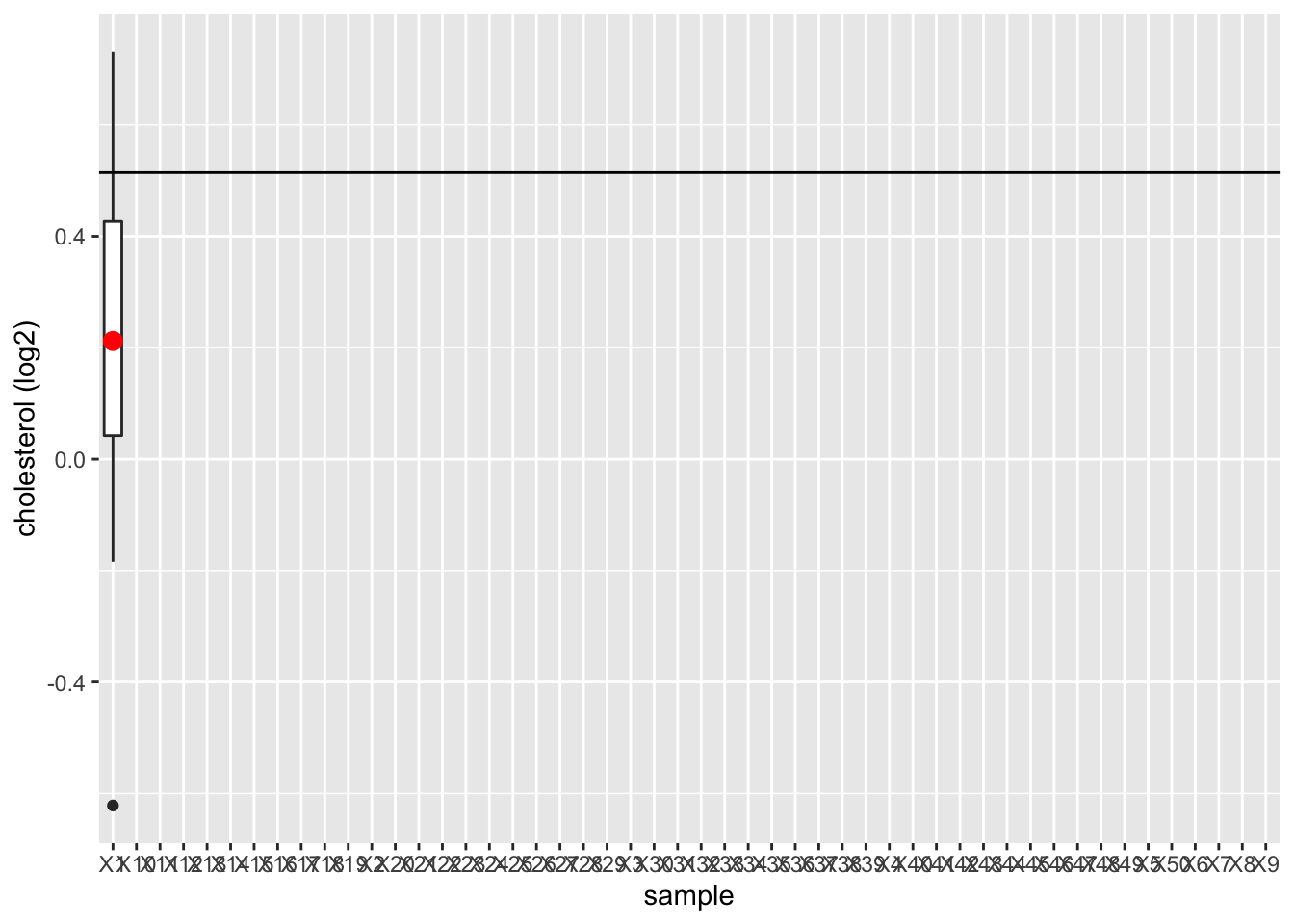

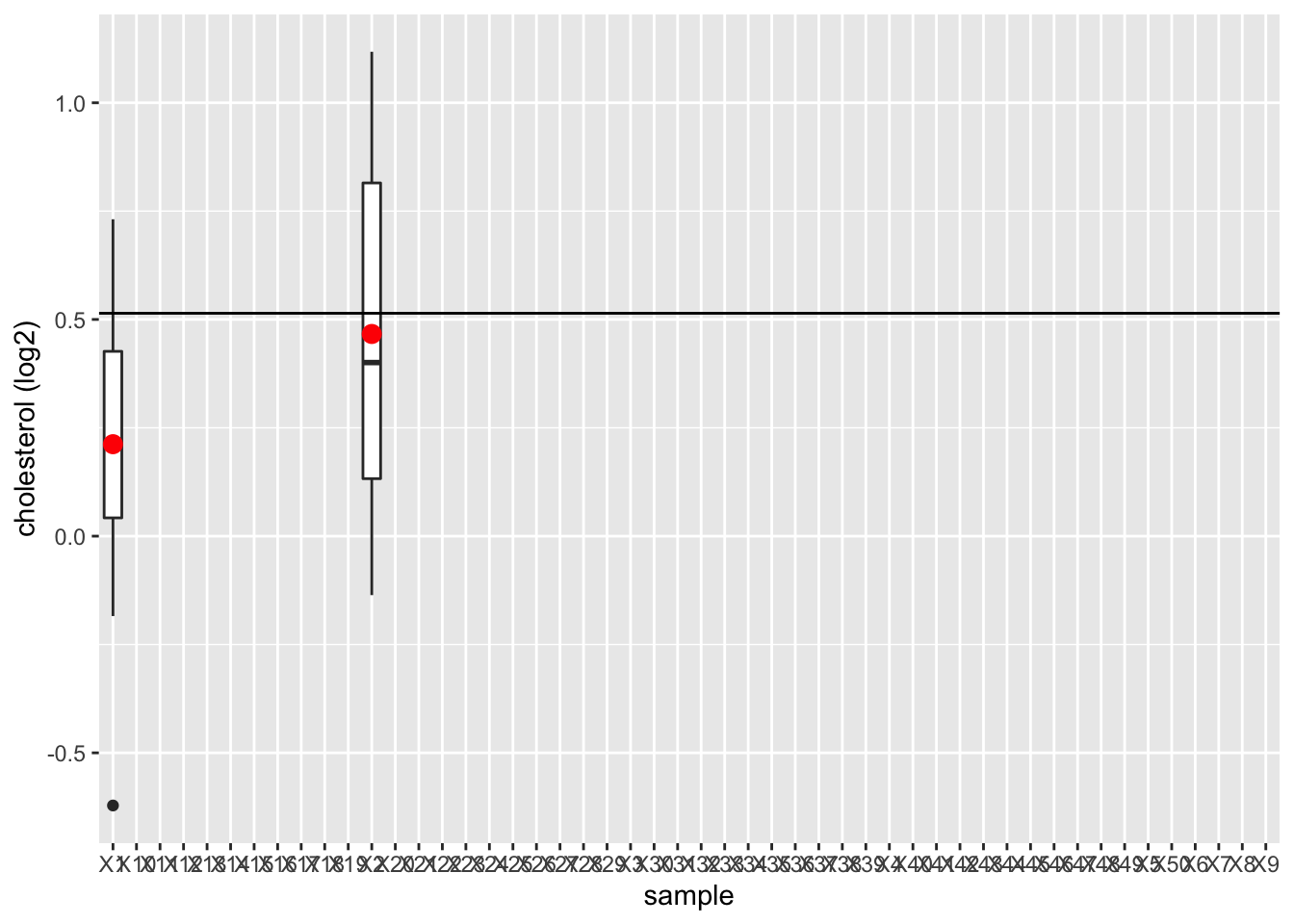

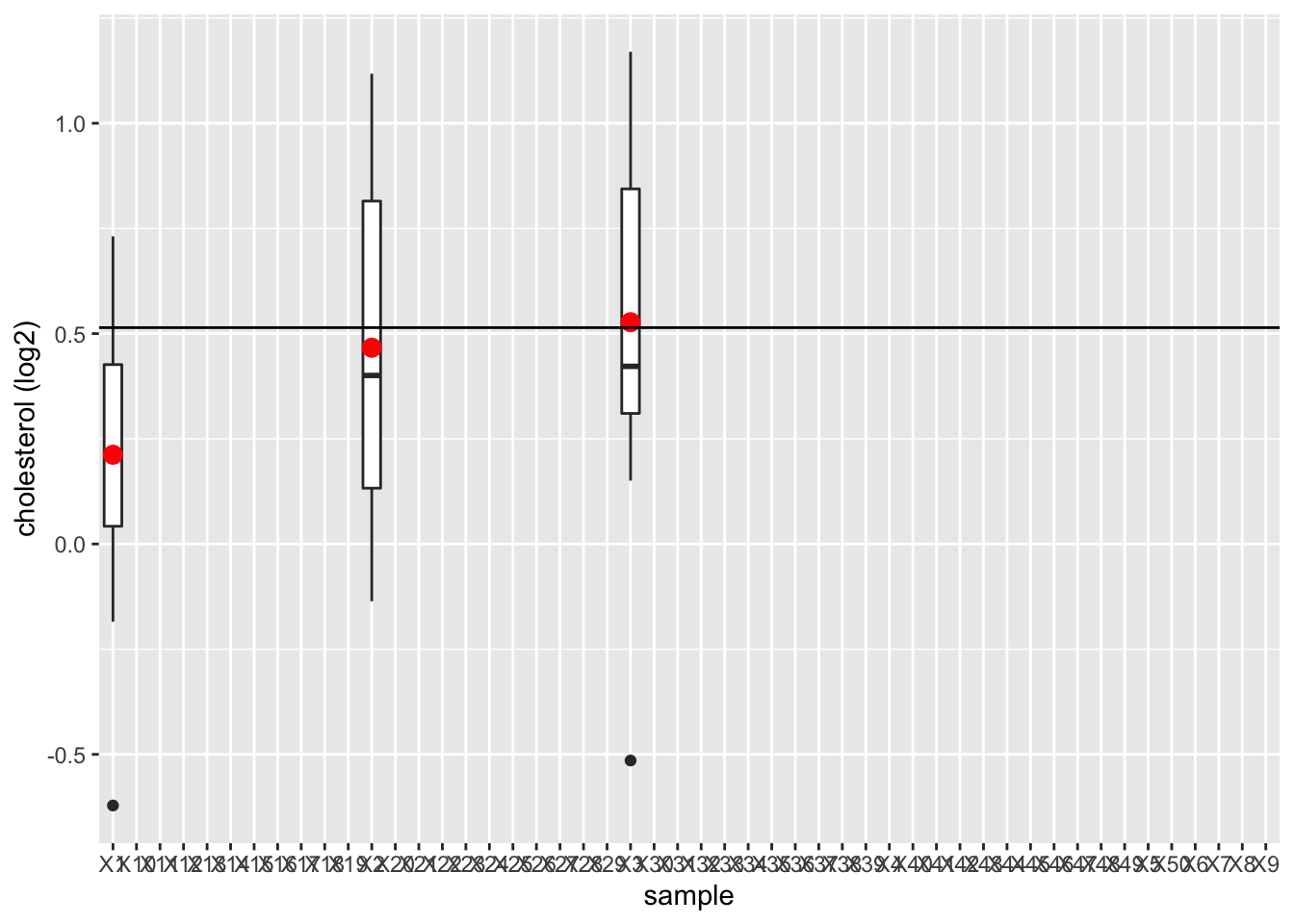

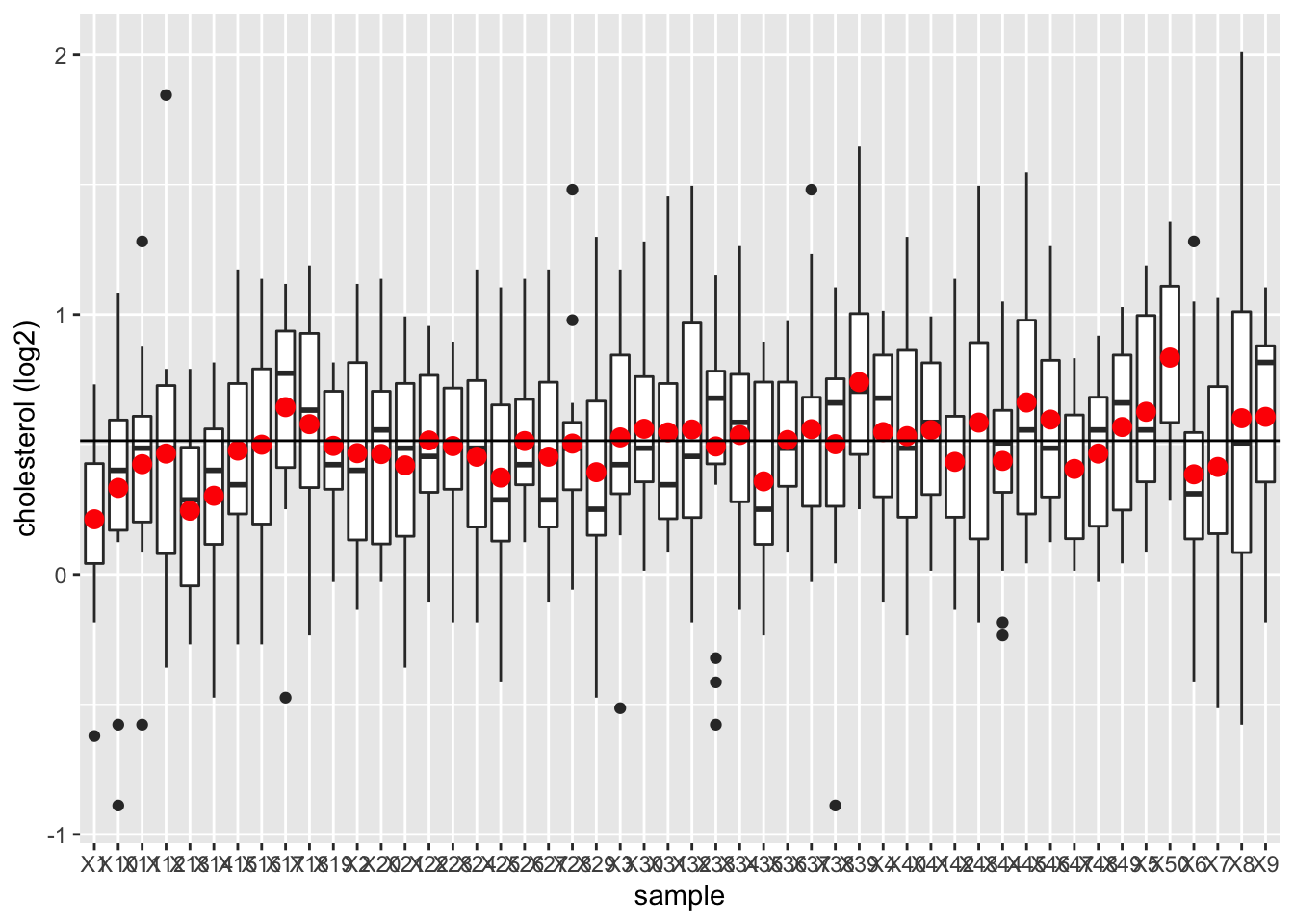

We illustreren dit met de NHANES studie

- We zullen 15 vrouwen willekeurig selecteren uit de NHANES studie en zullen hun lengte registreren.

- We herhalen dit 50 keer om de variatie van steekproef tot steekproef te beoordelen

- We plotten de boxplot voor iedere steekproef en duiden het gemiddelde aan.

set.seed(2105)

library(NHANES)

fem <- NHANES %>%

filter(Gender=="female" & !is.na(DirectChol)) %>%

select("DirectChol")

n <- 15 # number of subjects per sample

nSim <- 50 # number of simulations

femSamp <- matrix(nrow=n,ncol=nSim)

for (j in 1:nSim)

{

femSamp[,j] <- sample(fem$DirectChol,15)

if (j<4) {

p <- femSamp %>%

log2 %>%

data.frame %>%

gather("sample","log2cholesterol") %>%

ggplot(aes(x=sample,y=log2cholesterol)) +

geom_boxplot() +

stat_summary(

fun.y=mean,

geom="point",

shape=19,

size=3,

color="red",

fill="red") +

geom_hline(yintercept = mean(fem$DirectChol %>% log2)) +

ylab("cholesterol (log2)")

print(p)

}

}

femSamp %>%

log2 %>%

data.frame %>%

gather("sample","log2cholesterol") %>%

ggplot(aes(x=sample,y=log2cholesterol)) +

geom_boxplot() +

stat_summary(fun.y=mean, geom="point", shape=19, size=3, color="red", fill="red") +

geom_hline(yintercept = mean(fem$DirectChol %>% log2)) +

ylab("cholesterol (log2)")

We observeren dat het steekproefgemiddelde fluctueert rond het gemiddelde van de populatie.

Opdracht:

- Kopieer de code

- Vergroot de steekproefgrootte tot 100 proefpersonen

- Wat observeer je?

Hoe doen we dit op basis van een enkele steekproef?

Om inzicht te krijgen in de variabiliteit op \(\bar X\) op basis van een enkele steekproef zullen we assumpties moeten maken:

We zullen ervan uitgaan dat de metingen \(X_1, X_2, ..., X_n\) werden gemaakt bij \(n\) onafhankelijke observationele eenheden. In woorden betekent onafhankelijkheid dat elk subject een volledig nieuw stukje informatie bijdraagt tot het geheel. Een voorbeeld van afhankelijkheid tussen studie-objecten komt klassiek uit de studie van kankerverwekkende stoffen. Bij testen op zwangere ratten, worden metingen gedaan op hun levende foetussen of boorlingen. Foetussen van eenzelfde moeder delen dezelfde genetische achtergrond en zijn daarom waarschijnlijk meer aan elkaar gelijk dan foetussen van verschillende moeders. Zelfs al zijn de moeders die opgenomen worden in zo’n studie onafhankelijk van elkaar gekozen, de verschillende kleine ratjes leveren niet langer onafhankelijke stukjes informatie: via de gedeelde moeders is een afhankelijkheid ingebouwd.

Afhankelijke gegevens worden ondermeer ook verzameld in pre-test/post-test designs en cross-over studies.

Voor de Captopril studie bijvoorbeeld hebben we afhankelijke observaties

- Bloeddrukmetingen voor (\(Y_{i,before}\)) en na (\(Y_{i,after}\)) toediening van captopril aan dezelfde patiënt \(i=1,\ldots,n\).

- We hebben ze omgezet in n onafhankelijke metingen door het verschil \(Y_{i,na}-Y_{i,voor}\) te nemen.

De volgende eigenschap illustreert de noodzaak om over onafhankelijke gegevens te beschikken, wil men gemakkelijk de variabiliteit van het steekproefgemiddelde kunnen bepalen.

Eigenschap

Als \(X\) en \(Y\) onafhankelijke toevalsveranderlijken zijn, dan geldt27:

\[\begin{equation*} \text{Var}(X+Y) = \text{Var}(X) + \text{Var}(Y) \end{equation*}\]

Algemeen (d.i. voor mogelijks afhankelijke toevalsveranderlijken \(X\) en \(Y\)) geldt voor constanten \(a\) en \(b\):

\[\begin{eqnarray*} \text{Var}(aX+bY) &=& a^2 \text{Var}(X) + b^2 \text{Var}(Y) + 2 ab {% \text{Cor}}(X,Y)\sqrt{\text{Var}(X)}\sqrt{\text{Var}(Y)} \end{eqnarray*}\]

Einde Eigenschap

Een veelgemaakte fout is dat men beweert dat \(\text{Var}(X-Y)=\text{Var}(X)-\text{Var}(Y)\). Niets is minder waar! Stel bijvoorbeeld dat de lengte \(X\) van moeders en de lengte \(Y\) van vaders evenveel variëren zodat \(\text{Var}(X)=\text{Var}(Y)\). Dan impliceert dat nog niet dat als je het verschil \(X-Y\) neemt tussen de lengte van een moeder en haar partner, dat dit verschil variantie nul heeft; d.w.z. dat het niet varieert en bijgevolg voor alle moeder-vader paren exact dezelfde waarde aanneemt! Bovenstaande formules geven inderdaad integendeel aan dat:

\[\begin{equation*} \text{Var}(X-Y) = \text{Var}(X) + \text{Var}(Y) -2{\text{Cor}}(X,Y)\sqrt{\text{Var}(X)}\sqrt{\text{Var}(Y)}. \end{equation*}\]

5.3.3.1 Variantie schatter voor \(\bar X\)

Gebruik makend van deze rekenregels en steunend op de onafhankelijkheid van de observaties (waarvan we gebruik maken in de derde overgang, *) kunnen we nu verder berekenen dat:

\[\begin{eqnarray*} \text{Var}(\bar X)&=&\text{Var} \left(\frac{X_1+ X_2+ ... + X_n}{n}\right) \\ &= & \frac{\text{Var} (X_1+ X_2+ ... + X_n)}{n^2} \\ &\overset{*}{=} & \frac{\text{Var}(X_1)+ \text{Var}(X_2)+ ... + \text{Var}(X_n)}{n^2} \\ &=& \frac{\sigma^2 + \sigma^2 + ... \sigma^2}{n^2} \\ &= & \frac{\sigma^2}{n}. \end{eqnarray*}\]

Het steekproefgemiddelde heeft dus een spreiding (standaarddeviatie) rond haar gemiddelde \(\mu\) die \(\sqrt{n}\) keer kleiner is dan de deviatie op de oorspronkelijke observaties. Vandaar dat we meer over \(\mu\) kunnen leren door het steekproefgemiddelde \(\bar X\) te observeren dan door een individuele waarde \(X\) te observeren.

{.definition, name="Standaard error"}

De standaarddeviatie van \(\bar{X}\) is \(\sigma/\sqrt{n}\) en krijgt in de literatuur de speciale naam {standard error} van

het gemiddelde. Algemeen noemt men de standaarddeviatie van een schatter

voor een bepaalde parameter \(\theta\), de standard error van die

schatter. Men noteert dit als \(SE\).

Einde definitie

{.example, name="Gemiddelde bloeddrukverandering"}

Stel dat we \(n = 15\) systolische bloeddrukobservaties zullen meten en dat de standaarddeviatie van de bloeddrukverschillen in de populatie \(\sigma = 9.0\) mmHg bedraagt, dan is standard error (SE) van de systolische bloeddrukveranderingen \(\bar X\):

\[ SE= \frac{9.0}{\sqrt{15}}=2.32\text{mmHg.} \]

Meestal is \(\sigma\), en bijgevolg de standard error van het steekproefgemiddelde, ongekend. Men moet dan de standard error schatten. Een voor de hand liggende schatter met goede eigenschappen is \(S/\sqrt{n},\) waarbij \(S^2\) de steekproefvariantie van de reeks observaties \(X_1,...,X_n\) is en \(S\) de steekproef standaarddeviatie wordt genoemd.

Voor het captopril voorbeeld kunnen we de standard error op het steekproefgemiddelde van de bloeddrukveranderingen schatten in R als

n <- length(delta)

se <- sd(delta)/sqrt(n)

se## [1] 2.3308835.3.3.2 Standaarddeviatie vs standard error

We illustreren dit opnieuw a.d.h.v. herhaalde steekproeven:

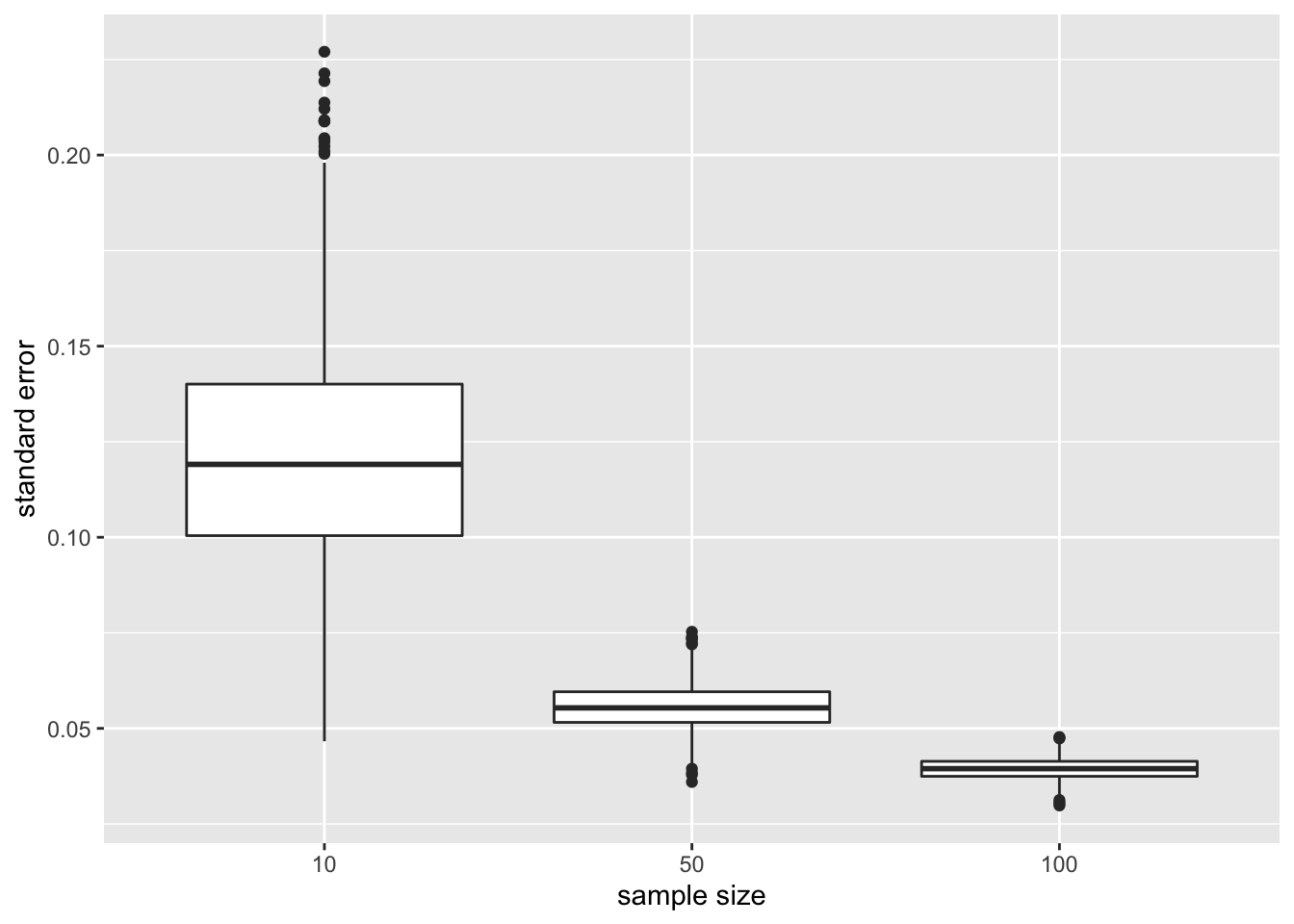

Verschillende steekproef groottes: 10, 50, 100

Neem 1000 steekproeven per steekproef grootte van de NHANES studie, voor iedere steekproef berekenen we:

- Het gemiddelde

- De steekproefstandaarddeviatie

- de standaard error

We maken een boxplot van de steekproefstandaardevaties en de standaard errors voor de verschillende steekproefgroottes

In plaats van een for loop te gebruiken zullen we de sapply functie gebruiken die efficiënter is. Het neemt een vector of lijst als invoer en past de functie toe op ieder element van de vector of lijst.

set.seed(24)

femSamp10 <- sapply(

1:1000,

function(j,x,size) sample(x,size),

size=10,

x=fem$DirectChol)

femSamp50 <- sapply(

1:1000,

function(j,x,size) sample(x,size),

size=50,

x=fem$DirectChol)

femSamp100 <- sapply(

1:1000,

function(j,x,size) sample(x,size),

size=100,

x=fem$DirectChol)

res<-rbind(

femSamp10 %>%

log2%>%

as.data.frame %>%

gather(sample,log2Chol) %>%

group_by(sample)%>%

summarize_at("log2Chol",

list(median=~median(.,na.rm=TRUE),

mean=~mean(.,na.rm=TRUE),

sd=~sd(.,na.rm=TRUE),

n=function(x) x%>%is.na%>%`!`%>%sum)) %>%

mutate(se=sd/sqrt(n)) ,

femSamp50 %>%

log2 %>%

as.data.frame %>%

gather(sample,log2Chol) %>%

group_by(sample)%>%

summarize_at("log2Chol",

list(median=~median(.,na.rm=TRUE),

mean=~mean(.,na.rm=TRUE),

sd=~sd(.,na.rm=TRUE),

n=function(x) x%>%is.na%>%`!`%>%sum)) %>%

mutate(se=sd/sqrt(n)),

femSamp100 %>%

log2 %>%

as.data.frame %>%

gather(sample,log2Chol) %>%

group_by(sample)%>%

summarize_at("log2Chol",

list(median=~median(.,na.rm=TRUE),

mean=~mean(.,na.rm=TRUE),

sd=~sd(.,na.rm=TRUE),

n=function(x) x%>%is.na%>%`!`%>%sum)) %>%

mutate(se=sd/sqrt(n))

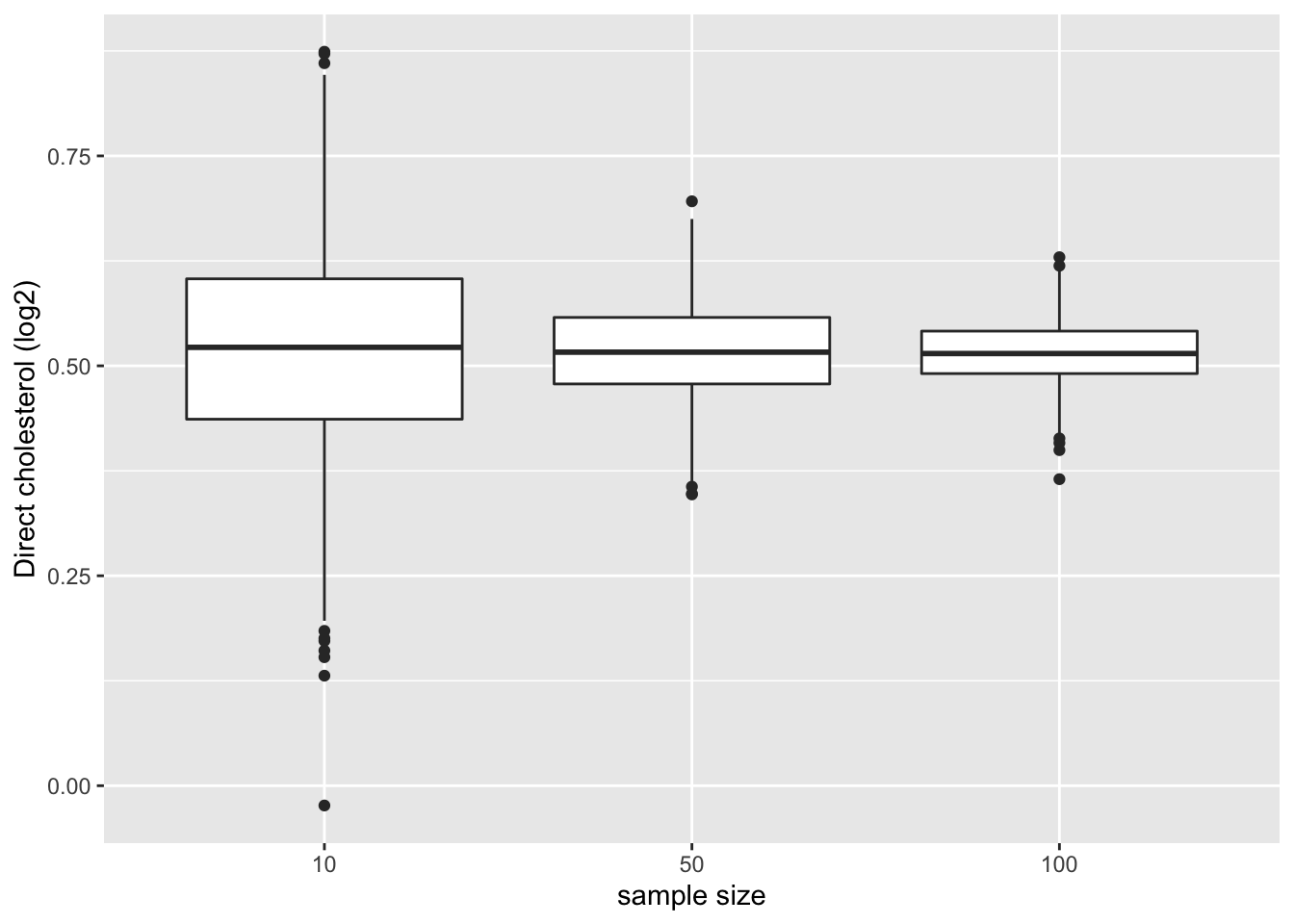

)Gemiddelden

We illustreren de impact van steekproefgrootte op de distributie van de gemiddeldes van verschillende steekproeven

res %>%

ggplot(aes(x= n %>% as.factor,y = mean)) +

geom_boxplot() +

ylab("Direct cholesterol (log2)") +

xlab("sample size")

- Merk op dat de variatie van de steekproefgemiddelden inderdaad afneemt naarmate de steekproefgrootte toeneemt. De schatting wordt dus nauwkeuriger naarmate de steekproefgrootte toeneemt.

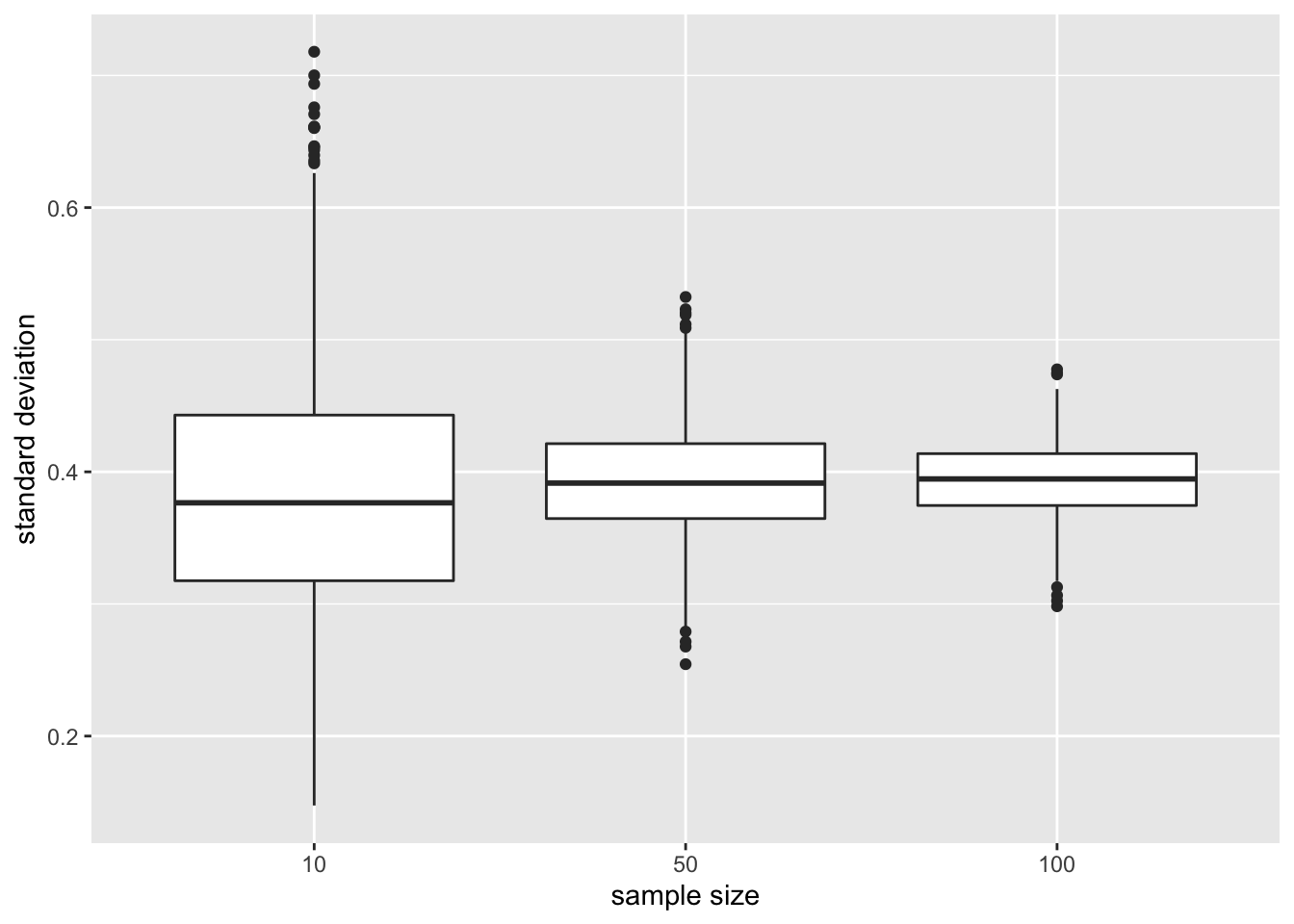

Standard deviatie

We illustreren nu de impact van de steekproefgrootte op de verdeling van de standaarddeviatie van de verschillende steekproeven

res %>%

ggplot(aes(x=n%>%as.factor,y=sd)) +

geom_boxplot() +

ylab("standard deviation") +

xlab("sample size")

De standaarddeviatie blijft vergelijkbaar voor de steekproefgroottes. Het is gecentreerd rond dezelfde waarde: de standaarddeviatie in de populatie. Het vergroten van de steekproefgrootte heeft inderdaad geen invloed op de variabiliteit in de populatie!

Opnieuw zien we dat de variabiliteit van de standaarddeviatie afneemt naarmate de steekproefgrootte toeneemt. De standaarddeviatie kan dus ook nauwkeuriger worden geschat naarmate de steekproefgrootte toeneemt.

Standaard error van het gemiddelde

Ten slotte illustreren we de impact van de steekproefgrootte op de verdeling van de standaarddeviatie van het gemiddelde van de verschillende steekproeven, de standaard error.

res %>%

ggplot(aes(x=n%>%as.factor,y=se)) +

geom_boxplot() +

ylab("standard error") +

xlab("sample size")

- De standaard error (de schatter voor de nauwkeurigheid van het steekproefgemiddelde) vermindert aanzienlijk naarmate de steekproefgrootte toeneemt, wat opnieuw bevestigt dat de schatting van het steekproefgemiddelde nauwkeuriger wordt.

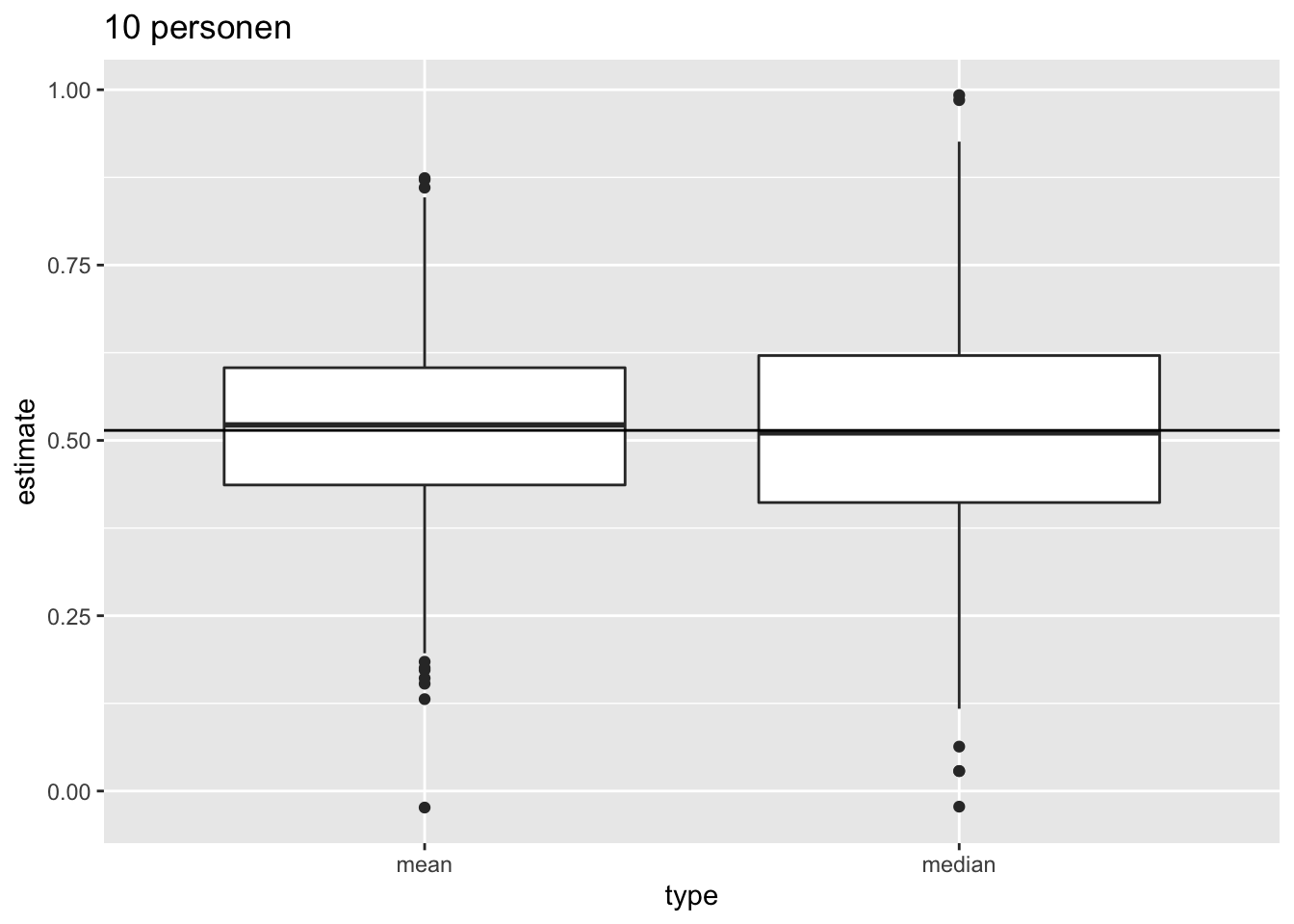

5.3.3.3 Normaal verdeelde gegevens

Als de gegevens Normaal verdeeld zijn, dan zijn er meerdere onvertekende schatters voor het populatiegemiddelde \(\mu\), bvb. het steekproefgemiddelde en de mediaan. Men kan echter aantonen dat in dat geval het steekproefgemiddelde \(\bar{X}\) de onvertekende schatter is voor \(\mu\) met de kleinste standard error. Dat betekent dat ze gemiddeld minder afwijkt van de echte parameterwaarde dan de mediaan, die veel meer varieert van steekproef tot steekproef. Het steekproefgemiddelde is bijgevolg een schatter die accuraat is (want onvertekend) en meest precies (kleinste standaarddeviatie).

- We illustreren dit voor herhaalde steekproeven met steekproefgrootte 10

res %>%

filter(n == 10) %>%

select(mean,median) %>%

gather(type,estimate) %>%

ggplot(aes(x = type,y = estimate)) +

geom_boxplot() +

geom_hline(yintercept = fem$DirectChol %>%

log2 %>%

mean) +

ggtitle("10 personen")

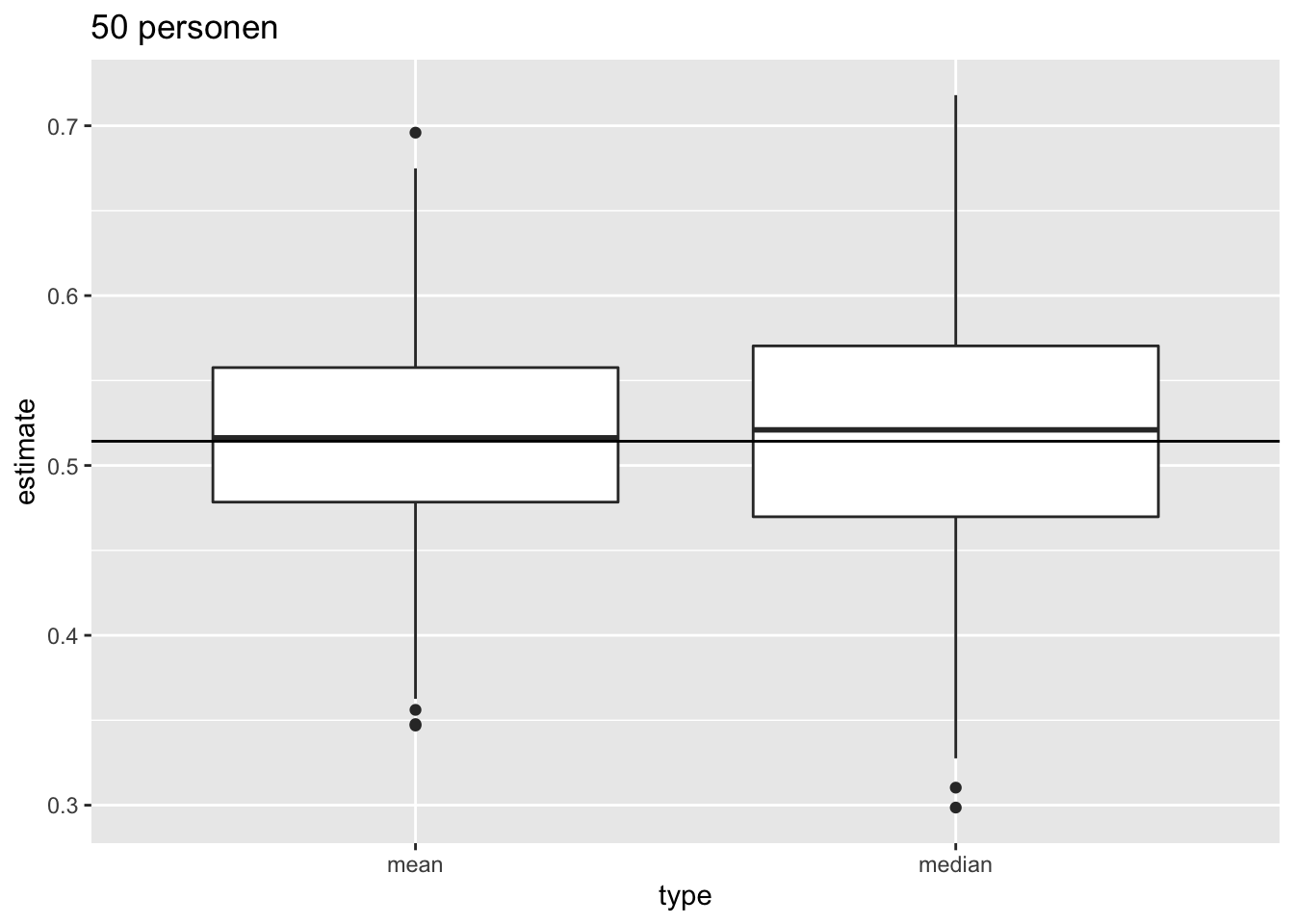

Vervolgens vergelijken we de verdeling van het gemiddelde en de mediaan in herhaalde steekproeven van steekproefgrootte 50.

res %>%

filter(n == 50) %>%

select(mean, median) %>%

gather(type, estimate) %>%

ggplot(aes(x = type,y = estimate)) +

geom_boxplot()+

geom_hline(yintercept = fem$DirectChol %>%

log2 %>%

mean) +

ggtitle("50 personen")

5.3.4 Verdeling van het steekproefgemiddelde

Om ondermeer goed de betekenis van de standard error te kunnen vatten, moeten we van \(\bar X\) niet alleen het gemiddelde en de standaarddeviatie, maar ook de exacte verdeling kennen. De standard error is immers een standaardeviatie (bvb. van het steekproefgemiddelde), waarvan de betekenis het meest duidelijk is wanneer de metingen (in dit geval, het steekproefgemiddelde) Normaal verdeeld zijn. In het bijzonder geval dat de individuele observaties \(X_i\) een Normale verdeling hebben met gemiddelde \(\mu\) en variantie \(\sigma^2\), kan men aantonen dat ook \(\bar X\) Normaal verdeeld is met gemiddelde \(\mu\) en variantie \(\sigma^2/n.\)

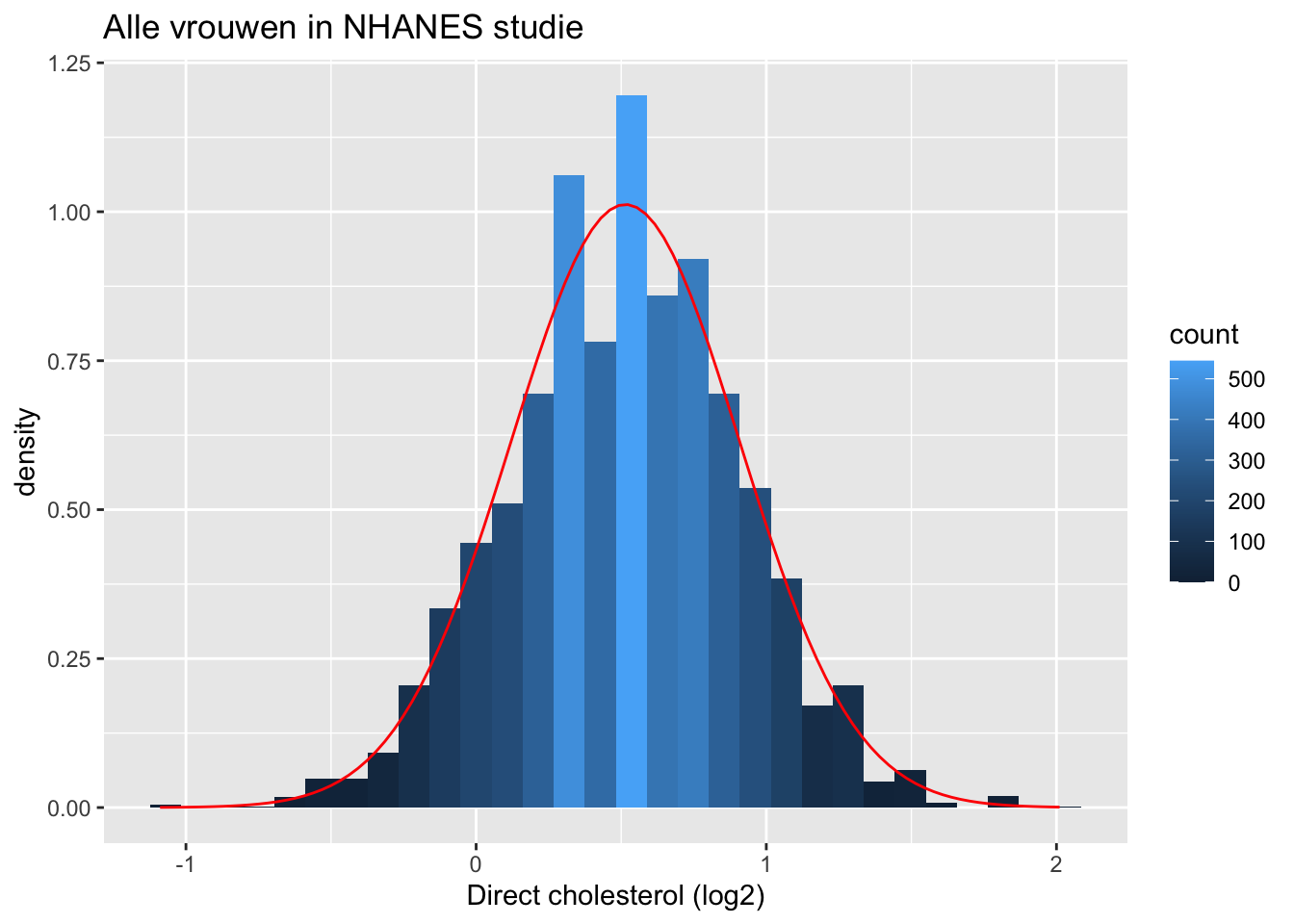

5.3.4.1 NHANES: cholesterol

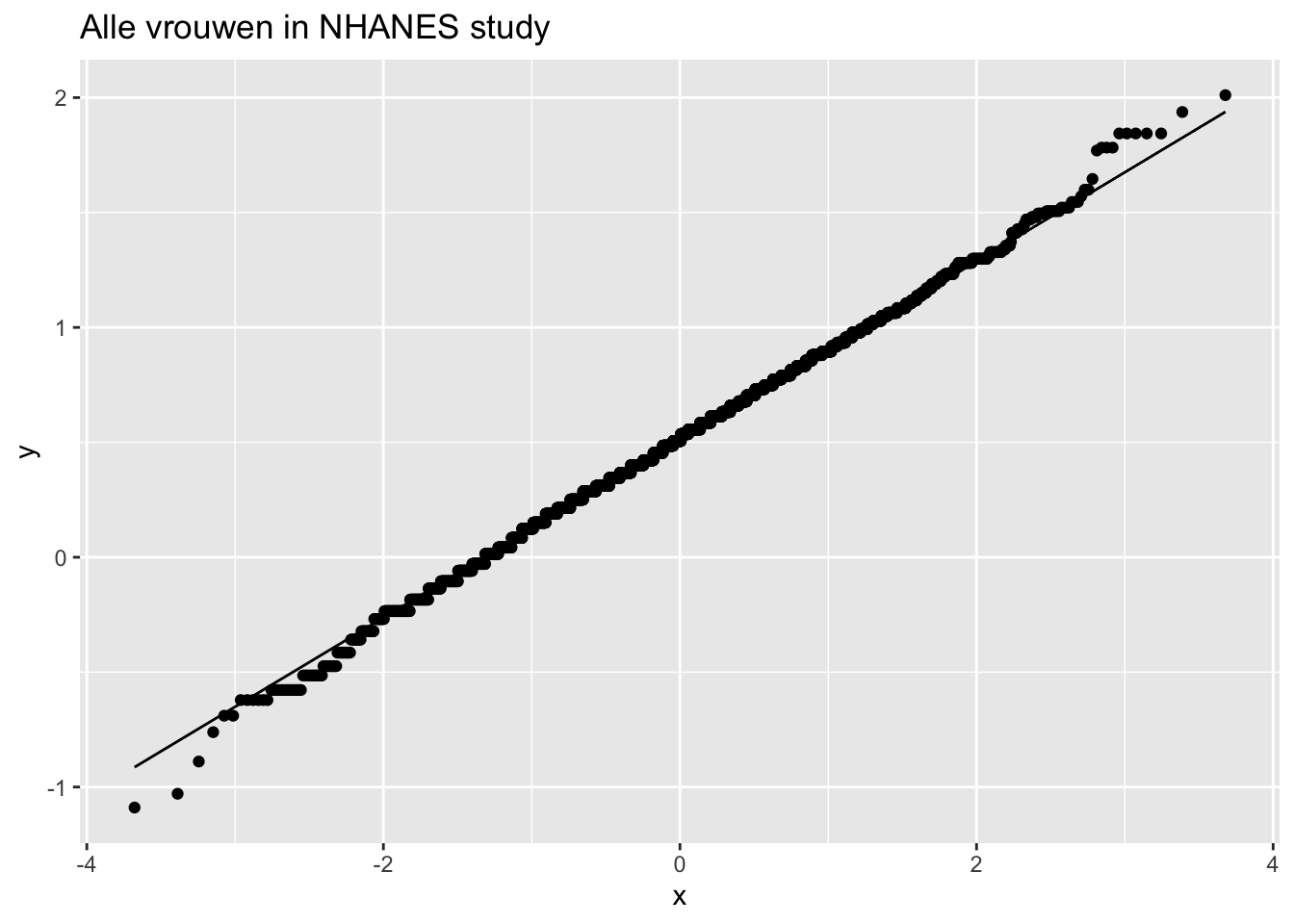

We illustreren dit nogmaals met een simulatie gebruik makende van de NHANES-studie. De log2-cholesterolwaarden zijn normaal verdeeld.

fem %>%

ggplot(aes(x = DirectChol %>% log2))+

geom_histogram(aes(y = ..density.., fill = ..count..)) +

xlab("Direct cholesterol (log2)") +

stat_function(

fun = dnorm,

color = "red",

args = list(

mean=mean(fem$DirectChol%>%log2),

sd = sd(fem$DirectChol%>%log2)

)

) +

ggtitle("Alle vrouwen in NHANES studie")

fem %>%

ggplot(aes(sample = DirectChol %>% log2)) +

stat_qq() +

stat_qq_line() +

ggtitle("Alle vrouwen in NHANES study")

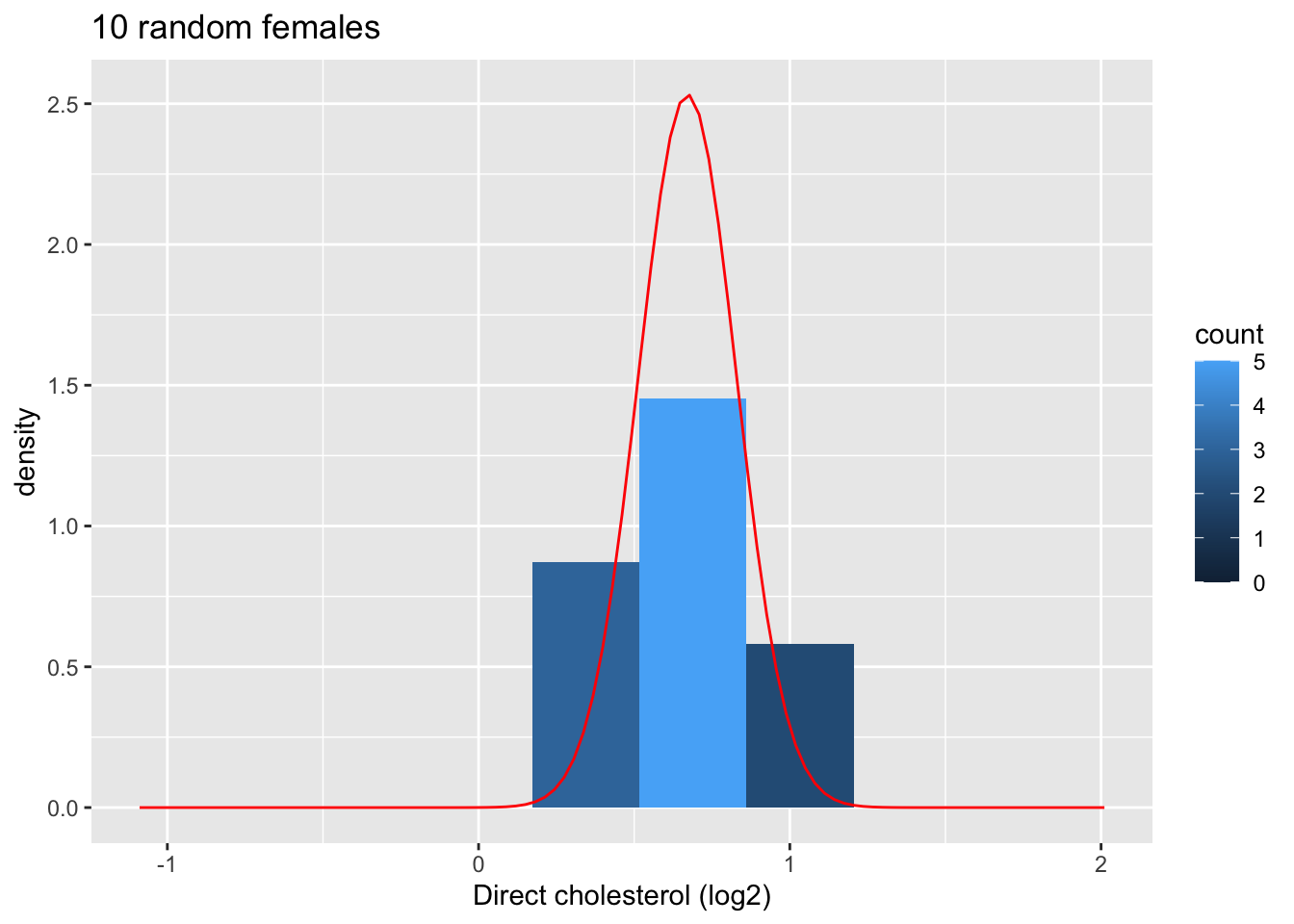

5.3.4.1.1 Evalueer de verdeling van het gemiddelde voor steekproeven van grootte 10

Nu onderzoeken we de resultaten voor de steekproefgrootte van 10.

We bekijken eerst de plot voor de eerste steekproef.

femSamp10[,1] %>%

log2 %>%

as.data.frame %>%

ggplot(aes(x=.))+

geom_histogram(aes(y=..density.., fill=..count..),bins=10) +

xlab("Direct cholesterol (log2)") +

stat_function(

fun=dnorm,

color="red",

args=list(

mean=femSamp10[,1]%>%log2%>%mean, sd=femSamp10[,1]%>%log2%>%sd)

) +

ggtitle("10 random females") +

xlim(fem$DirectChol %>% log2 %>% range)

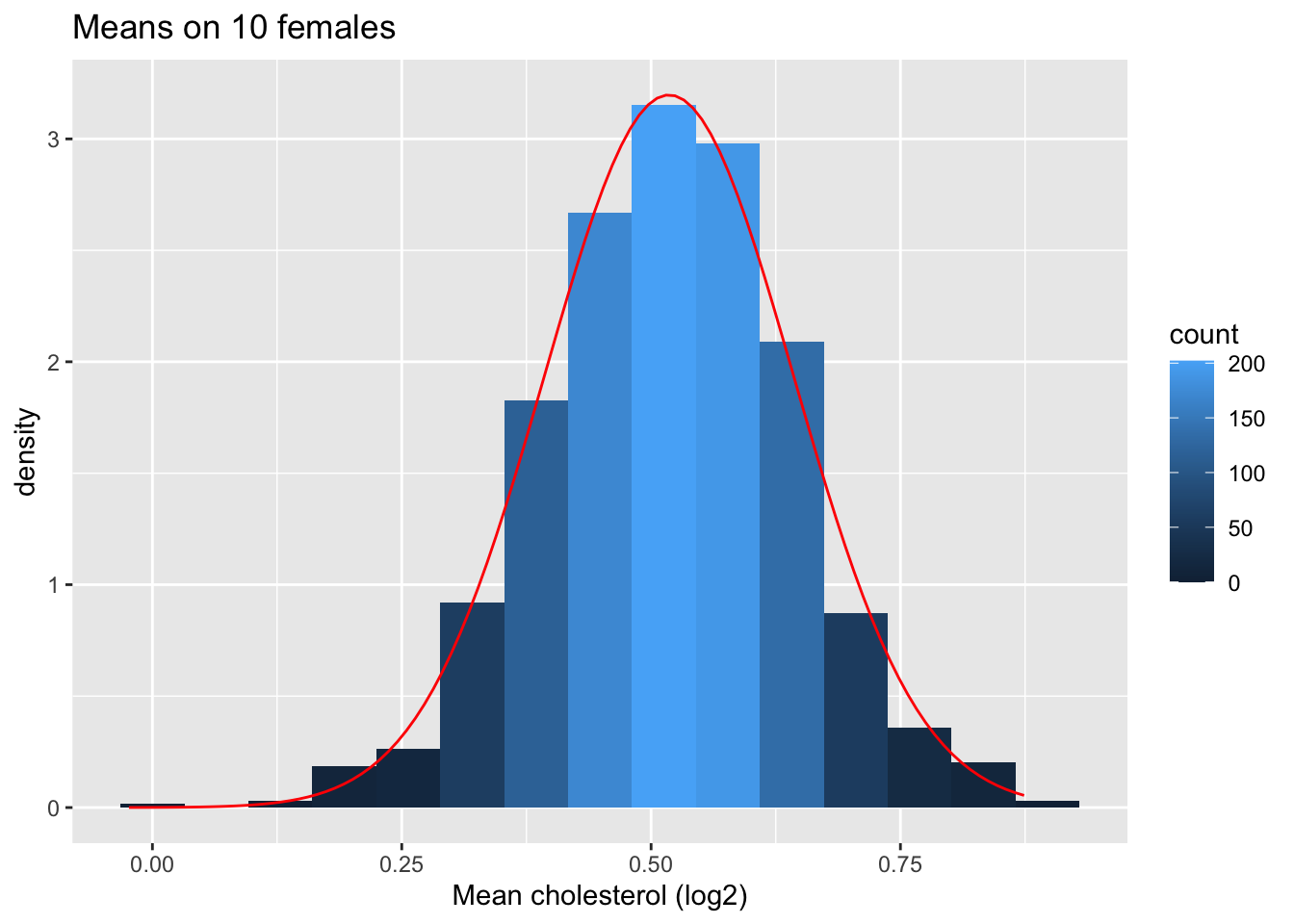

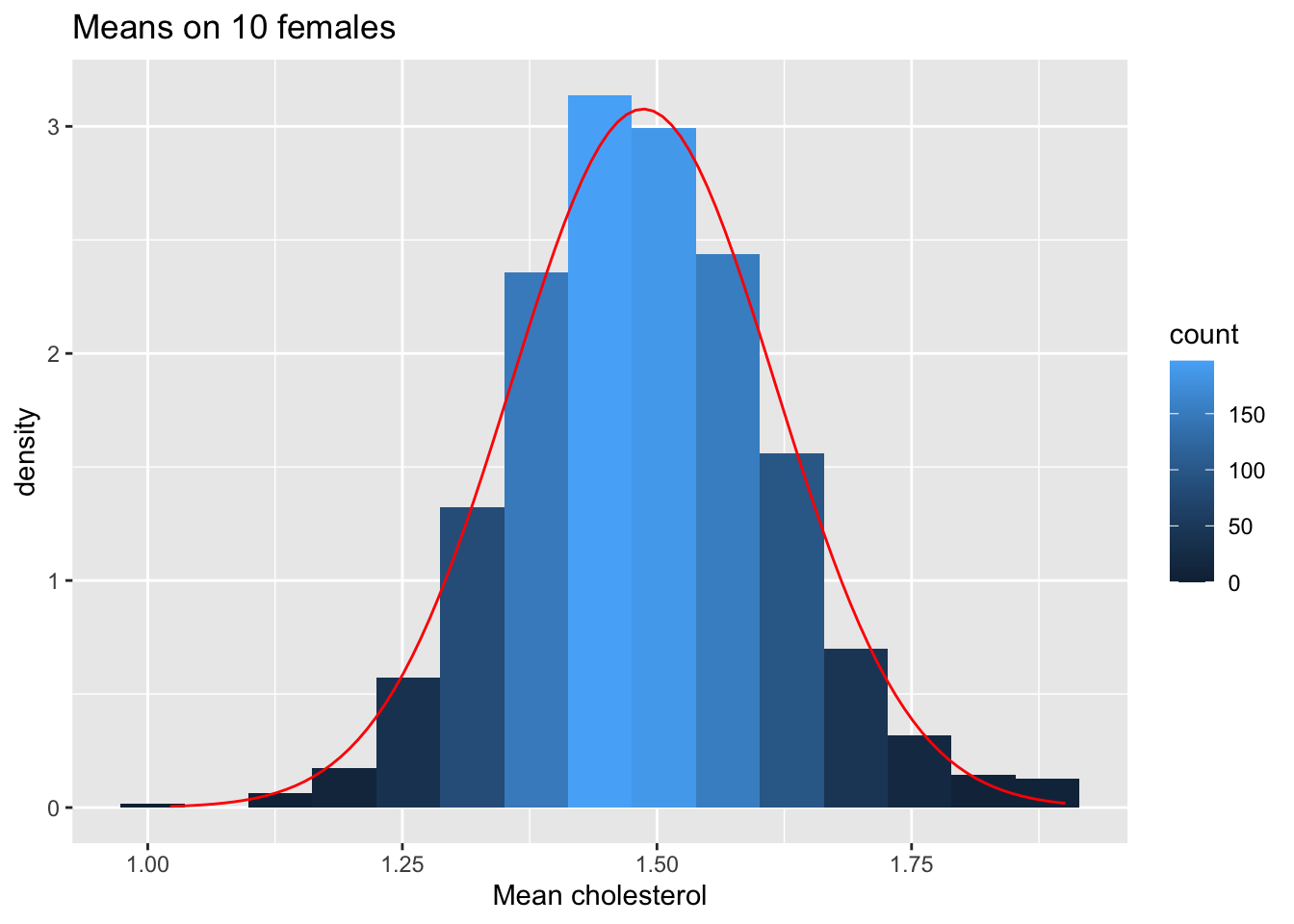

Vervolgens kijken we naar de verdeling van het steekproefgemiddelde over 1000 steekproeven van steekproefgrootte 10.

femSamp10 %>%

log2 %>%

colMeans %>%

as.data.frame %>%

ggplot(aes(x=.)) +

geom_histogram(aes(y=..density.., fill=..count..),bins=15) +

xlab("Mean cholesterol (log2)") +

stat_function(

fun=dnorm,

color="red",

args=list(

mean=femSamp10%>%log2%>% colMeans %>% mean,

sd=femSamp10%>%log2%>% colMeans %>% sd)

) +

ggtitle("Means on 10 females")

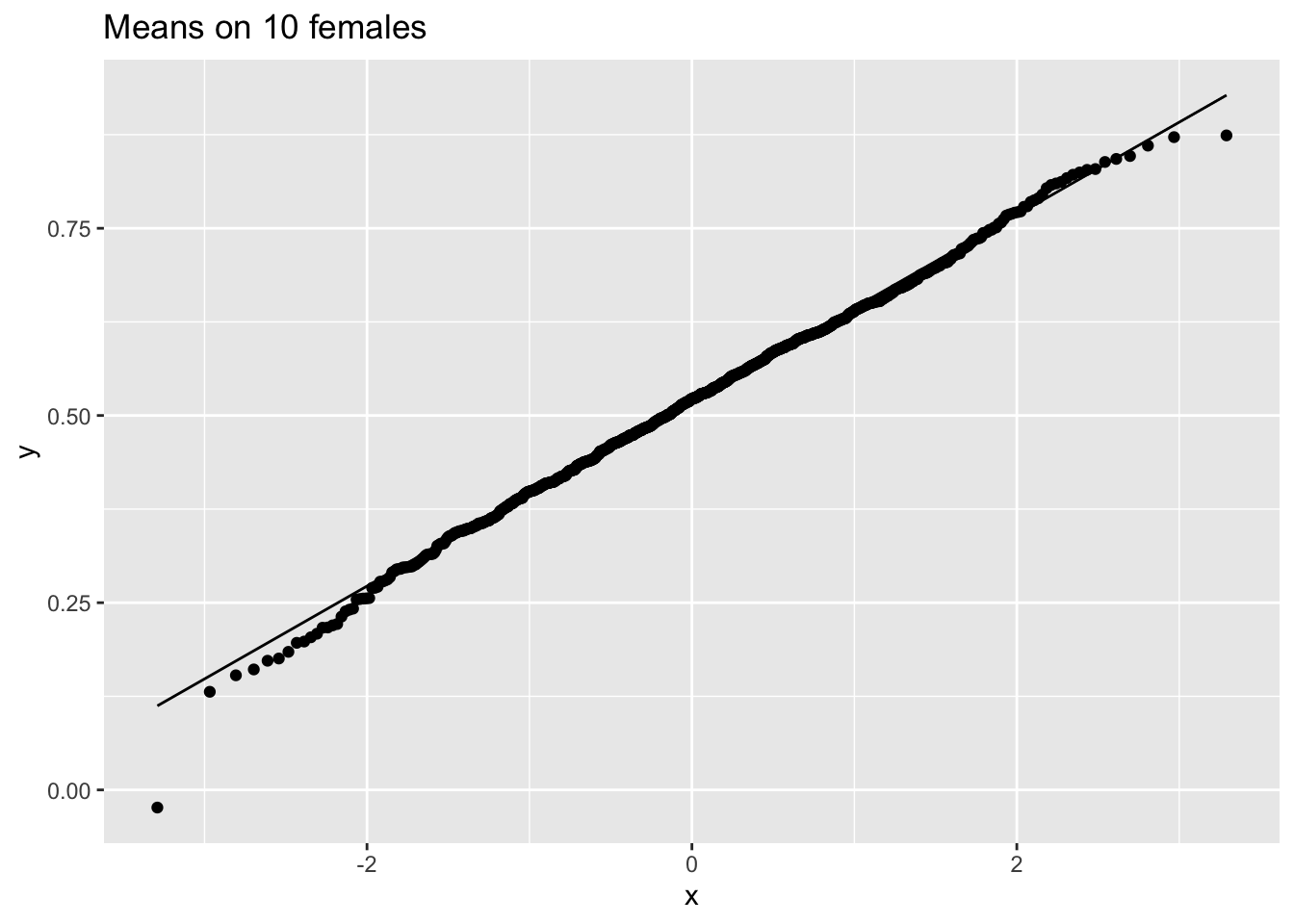

femSamp10 %>%

log2%>%

colMeans %>%

as.data.frame %>%

ggplot(aes(sample=.)) +

stat_qq() +

stat_qq_line() +

ggtitle("Means on 10 females")

We hebben dus bevestigd dat het gemiddelde ongeveer normaal verdeeld is voor studies met 10 vrouwen, terwijl de originele gegevens ongeveer normaal verdeeld zijn.

5.3.4.2 Captopril studie

In het captopril voorbeeld zagen we dat de systolische bloeddrukverandering approximatief normaal verdeeld is. De standard error op de bloeddrukverandering bedroeg 2.32 mm Hg. Dus op 100 studies met n = 15 subjecten, verwachten we dat de geschatte gemiddelde systolische bloeddrukafwijking (\(\bar X\)) op minder dan 2 × 2.32 = 4.64mm Hg van het werkelijke populatiegemiddelde (\(\mu\)) ligt in 95 studies.

5.3.4.3 Niet-normaal verdeelde data

Als individuele observaties geen normale verdeling hebben, is \(\bar X\) nog steeds normaal verdeeld wanneer het aantaal observaties groot genoeg is.

Hoe groot moet de steekproef zijn om de normale benadering te laten werken hangt af van de scheefheid van de distributie!

5.3.4.3.1 NHANES: cholesterol

- We kunnen dit evalueren in de NHanes-studie als we de gegevens niet log2 transformeren.

fem %>%

ggplot(aes(x=DirectChol))+

geom_histogram(aes(y=..density.., fill=..count..)) +

xlab("Direct cholesterol") +

stat_function(

fun=dnorm,

color="red",

args=list(

mean=mean(fem$DirectChol),

sd=sd(fem$DirectChol))

) +

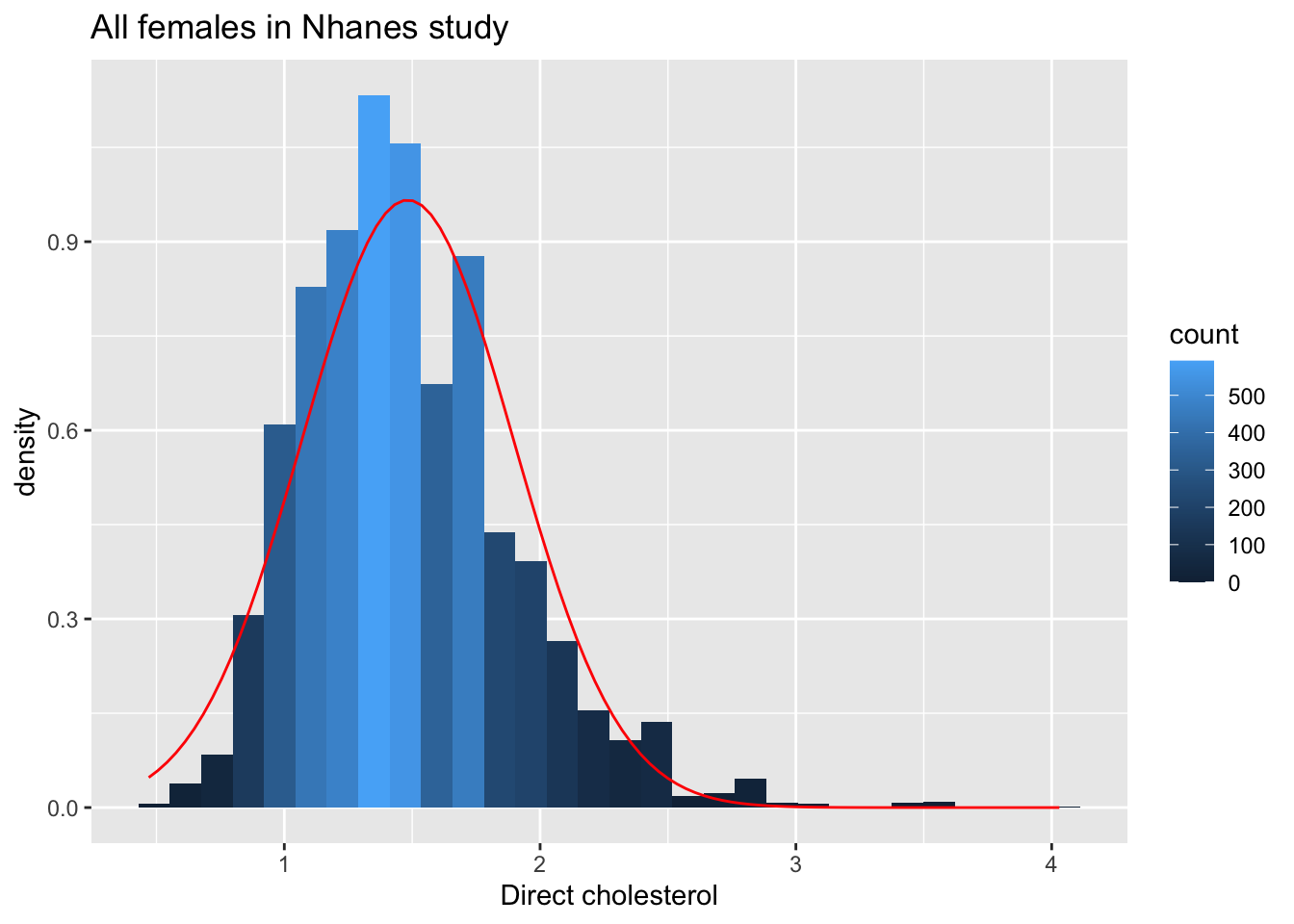

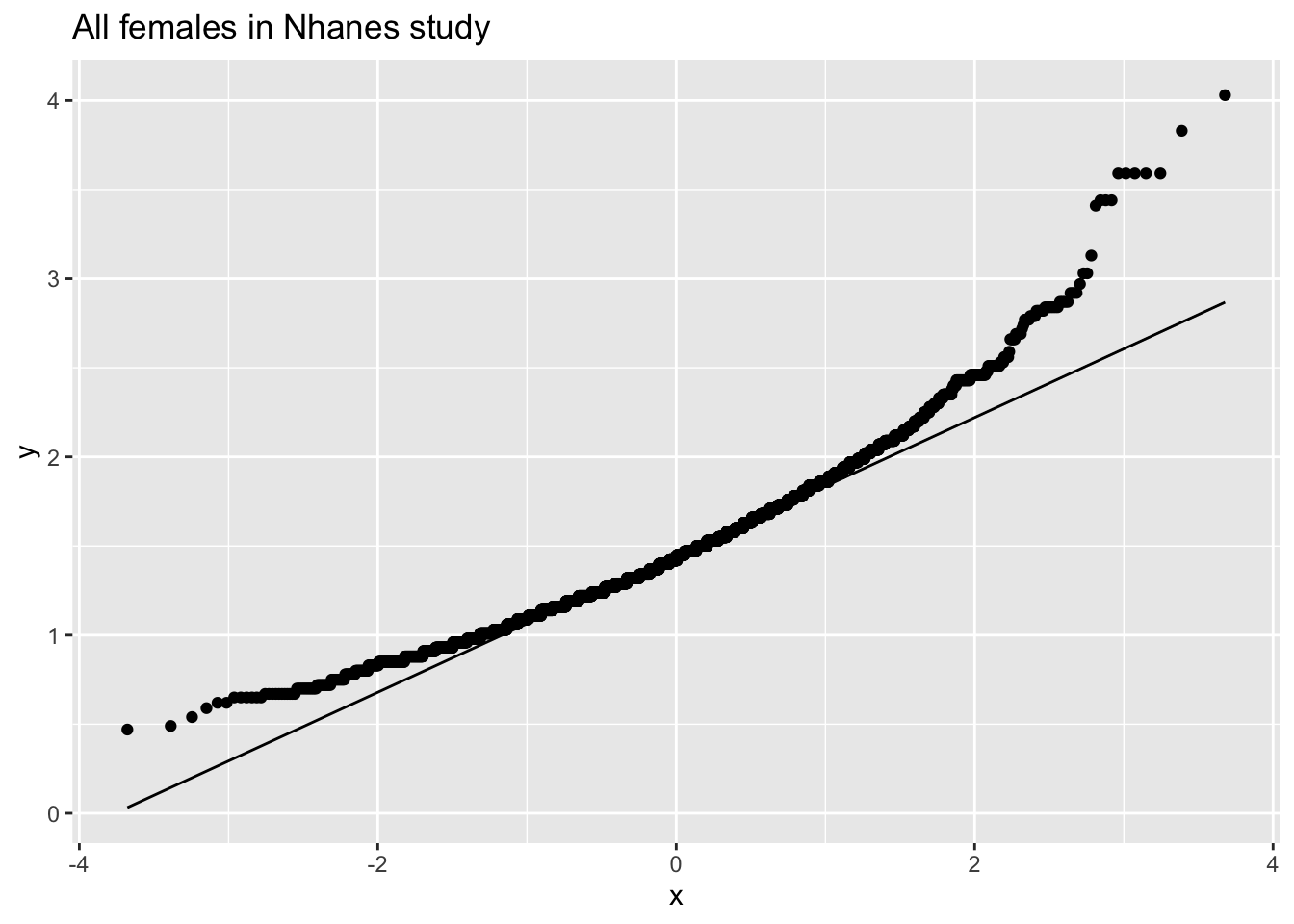

ggtitle("All females in Nhanes study")

fem %>%

ggplot(aes(sample=DirectChol)) +

stat_qq() +

stat_qq_line() +

ggtitle("All females in Nhanes study")

De cholesterol data zijn duidelijk niet-normaal verdeeld.

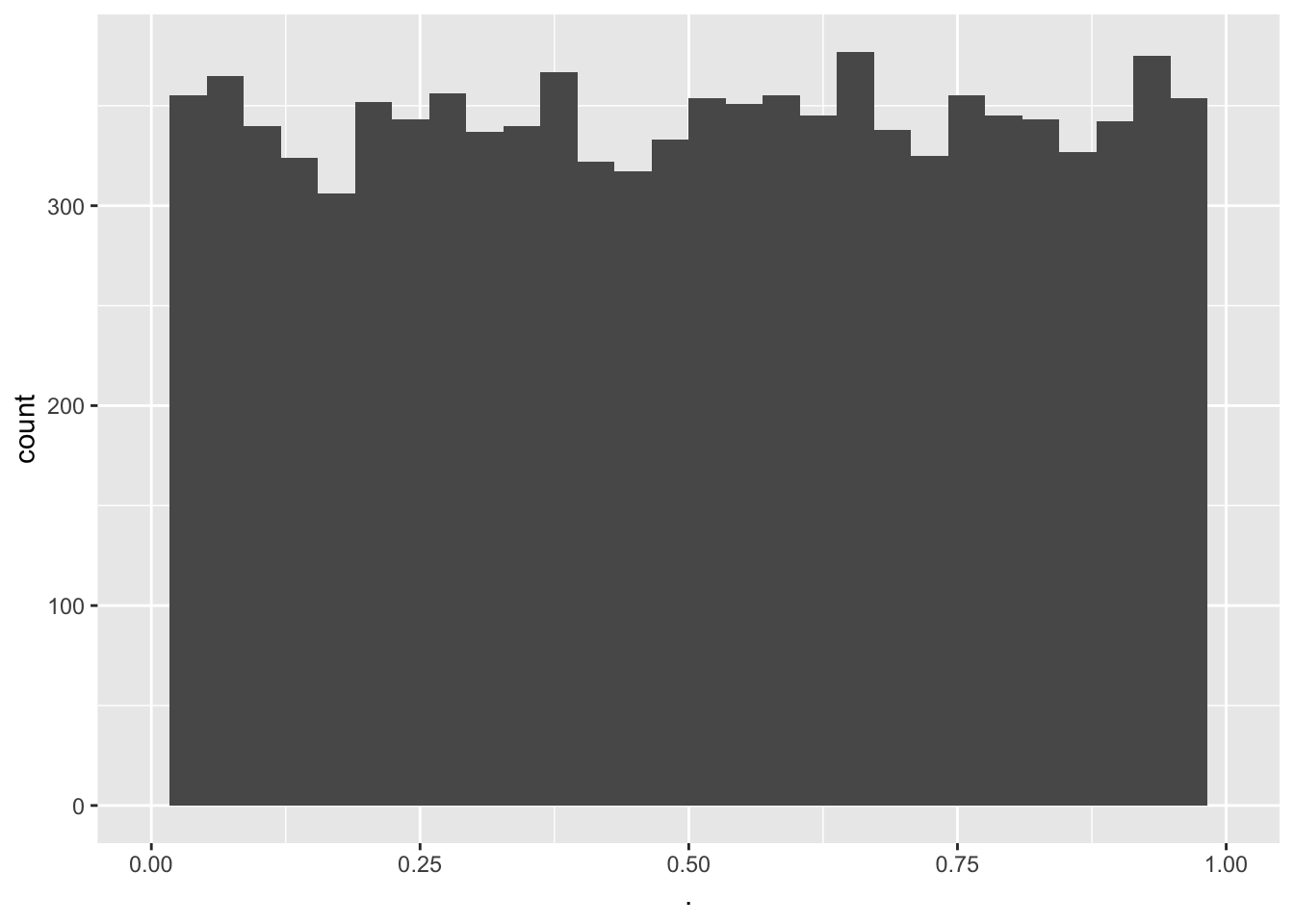

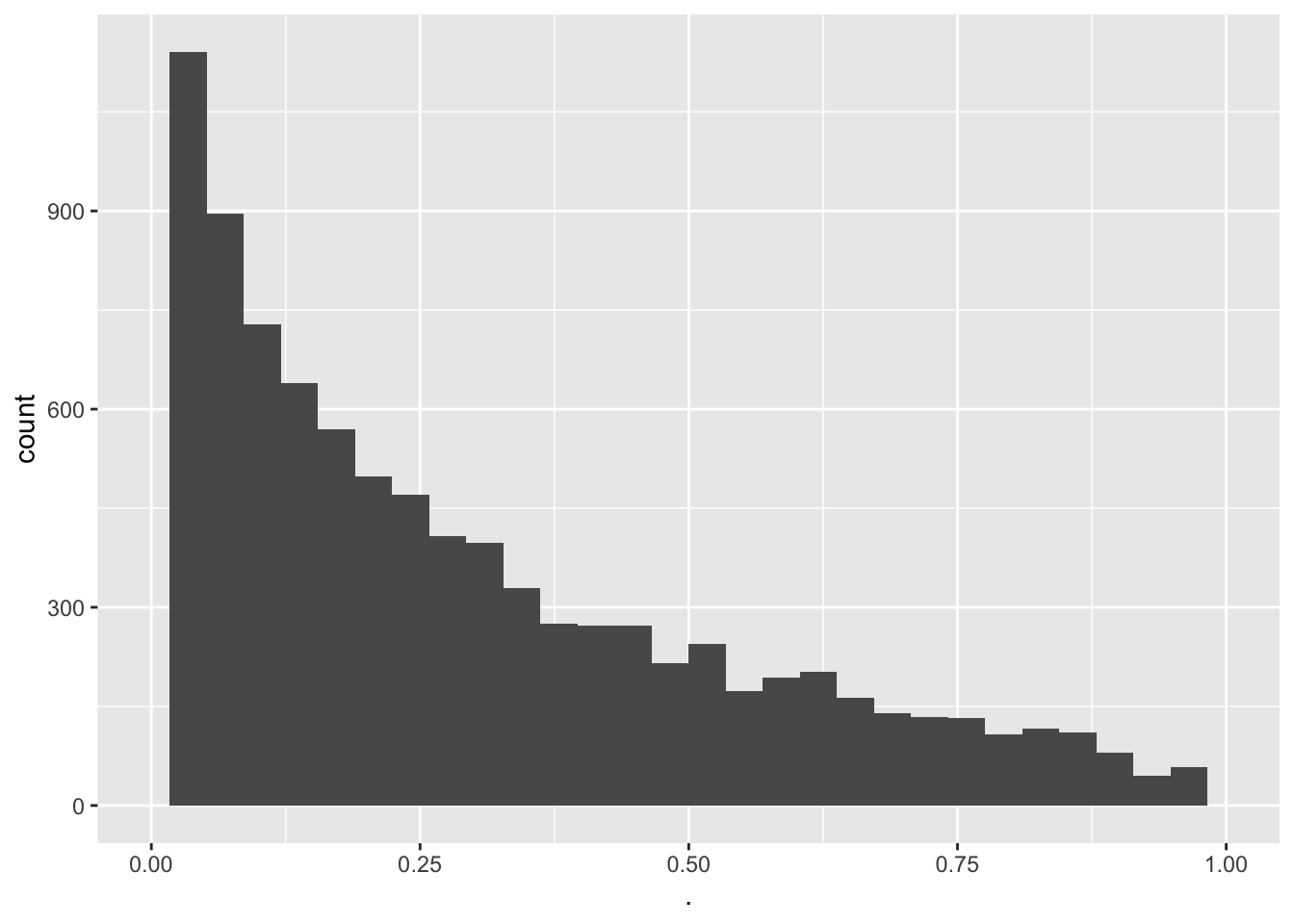

Verdeling van het steekproefgemiddelde voor verschillende steekproefgroottes

set.seed(121)

femSamp5 <- sapply(

1:1000,

function(j,x,size) sample(x,size),

size = 5,

x = fem$DirectChol)

femSamp5 %>%

colMeans %>%

as.data.frame %>% ggplot(aes(x=.)) +

geom_histogram(aes(y=..density.., fill=..count..),bins=15) +

xlab("Mean cholesterol") +

stat_function(

fun=dnorm,

color="red",

args=list(

mean=femSamp5%>% colMeans %>% mean,

sd=femSamp5%>% colMeans %>% sd)

) +

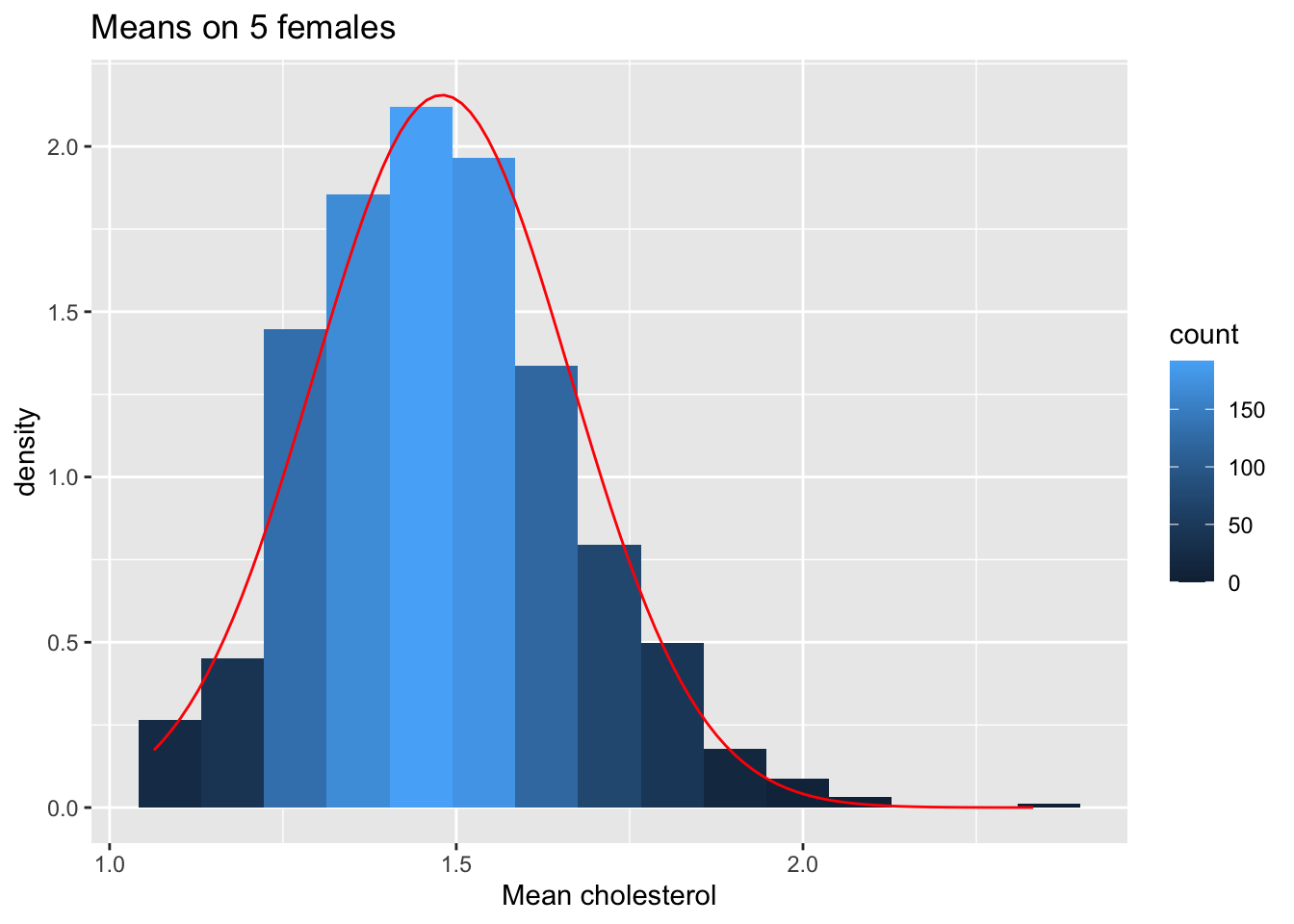

ggtitle("Means on 5 females")

femSamp5 %>%

colMeans %>%

as.data.frame %>%

ggplot(aes(sample=.)) +

stat_qq() +

stat_qq_line() +

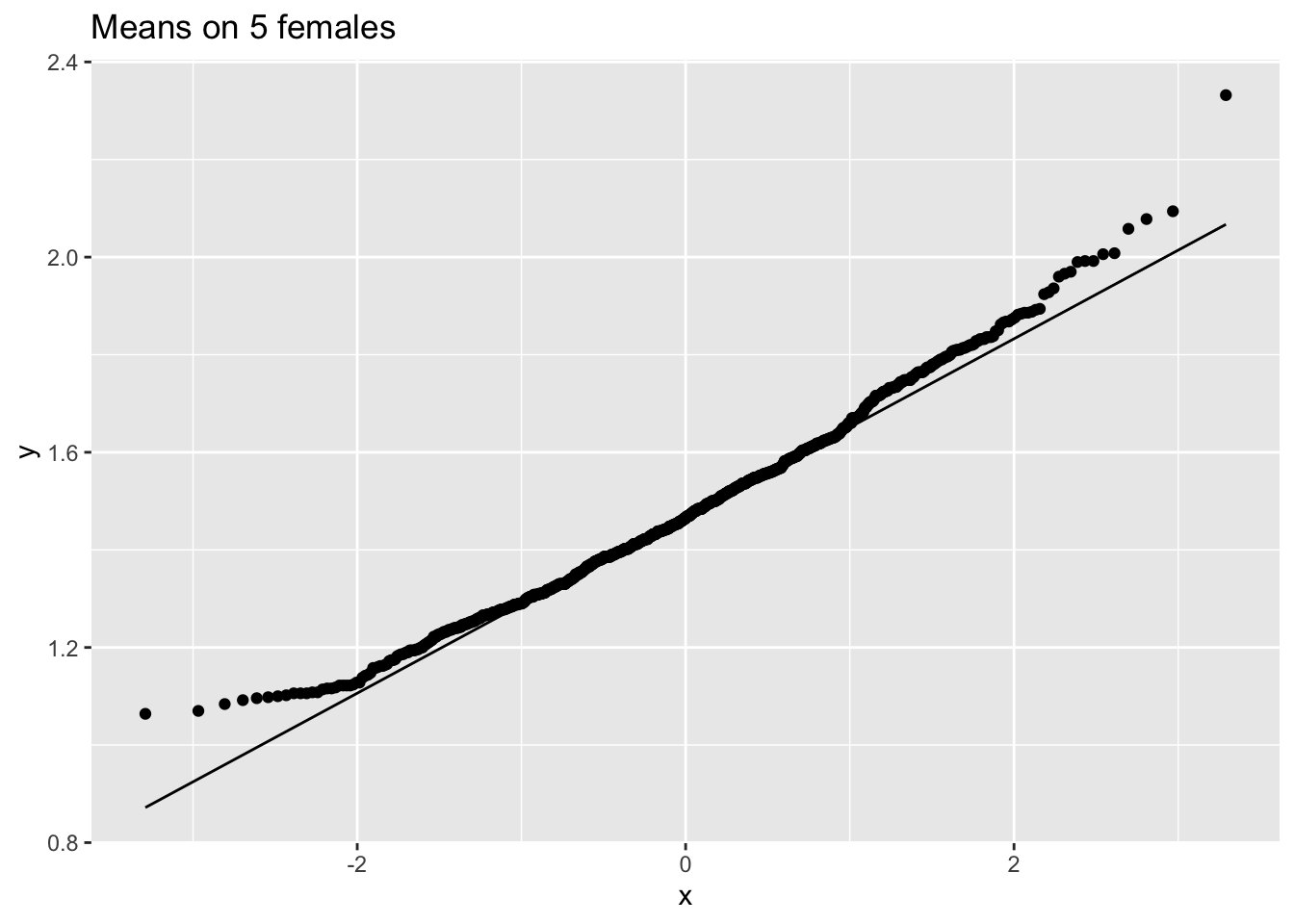

ggtitle("Means on 5 females")

femSamp10 %>%

colMeans %>%

as.data.frame %>% ggplot(aes(x=.)) +

geom_histogram(aes(y=..density.., fill=..count..),bins=15) +

xlab("Mean cholesterol") +

stat_function(

fun=dnorm,

color="red",

args=list(

mean=femSamp10%>% colMeans %>% mean,

sd=femSamp10%>% colMeans %>% sd)

) +

ggtitle("Means on 10 females")

femSamp10 %>%

colMeans %>%

as.data.frame %>%

ggplot(aes(sample=.)) +

stat_qq() +

stat_qq_line() +

ggtitle("Means on 10 females")

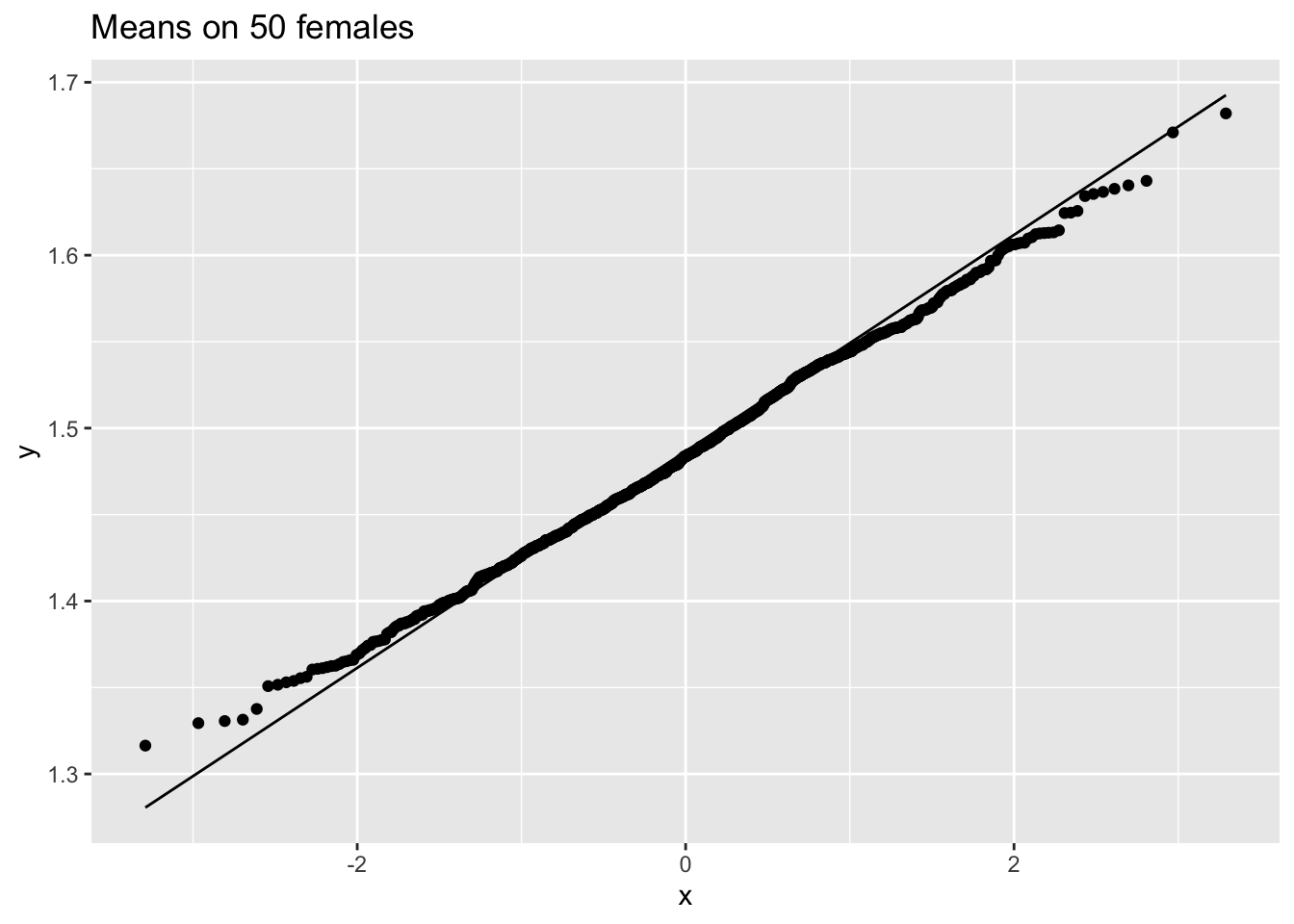

femSamp50 %>%

colMeans %>%

as.data.frame %>%

ggplot(aes(sample=.)) +

stat_qq() +

stat_qq_line() +

ggtitle("Means on 50 females")

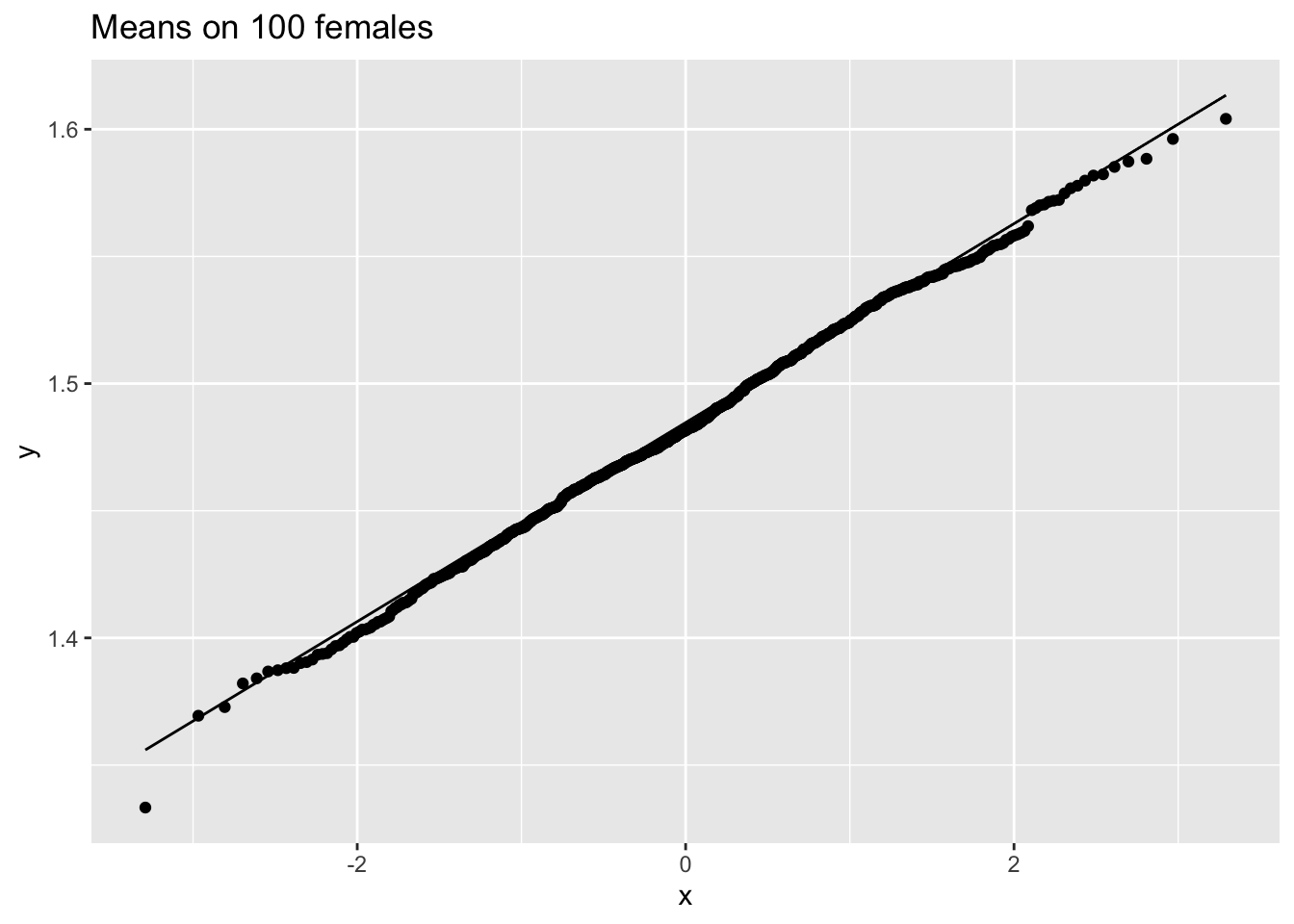

femSamp100 %>%

colMeans %>%

as.data.frame %>%

ggplot(aes(sample=.)) +

stat_qq() +

stat_qq_line() +

ggtitle("Means on 100 females")

We merken op dat wanneer de data niet normaal verdeeld zijn, de verdeling van het steekproefgemiddelde niet normaal verdeeld is over kleine steekproeven

Voor grote steekproeven is het steekproefgemiddelde van niet-normale gegevens echter nog steeds ongeveer normaal verdeeld.

5.3.4.4 Centrale Limietstelling (CLT)

Stel dat \(X_1, X_2, \dots, X_n, \; n\) onafhankelijke lukrake trekkingen van de toevalsveranderlijke \(X\) voorstellen, met allen dezelfde theoretische verdeling. Laat \(X\) gemiddelde \(\mu\) en variantie \(\sigma^2\) hebben maar verder een ongespecifieerde verdeling, dan wordt de verdeling van het steekproefgemiddelde \(\bar{X}_n = {\sum_{i=1}^{n} X_i}/{n}\) naarmate \(n\) groter wordt steeds beter benaderd door de Normale verdeling met gemiddelde \(\mu\) en variantie \(\sigma^2/n.\)

Einde Stelling

Deze belangrijke eigenschap zal ons toelaten om de meeste technieken die in deze cursus aan bod komen toe te passen op een zeer uitgebreid spectrum van experimenten.

5.4 Intervalschatters

In de vorige sectie hebben we vastgesteld dat het steekproefgemiddelde van steekproef tot steekproef varieert rond het populatiegemiddelde dat we willen schatten. Om die reden wensen we in deze sectie een interval rond het steekproefgemiddelde te bepalen waarbinnen we het populatiegemiddelde met gegeven kans (bvb. 95% kans) kunnen verwachten. In Sectie 5.4.1 zullen we dit uitwerken voor het geval waar de populatievariantie \(\sigma^2\) op de metingen gekend is. Deze onderstelling is meestal onredelijk28, maar wordt hier gemaakt om redenen van eenvoud. In Sectie 5.4.2 zullen we van deze onderstelling afstappen.

5.4.1 Gekende variantie op de metingen

Wanneer de individuele observaties \(X\) Normaal verdeeld zijn met gemiddelde \(\mu\) en gekende variantie \(\sigma^2\), noteren we dat als volgt: \(X\sim N(\mu,\sigma^2)\). Uit vorige sectie volgt dan dat het steekproefgemiddelde \(\bar{X}\) eveneens Normaal verdeeld is volgens \(N(\mu,\sigma^2/n)\). Een 95% referentie-interval voor het steekproefgemiddelde ziet er bijgevolg uit als

\[\begin{equation*} \left[\mu - 1.96 \frac{\sigma}{\sqrt{n}},\mu + 1.96 \frac{\sigma}{\sqrt{n}}% \right] \end{equation*}\]

Het bevat met 95% kans het steekproefgemiddelde van een lukrake steekproef. Dit interval kunnen we niet expliciet berekenen op basis van de geobserveerde gegevens, omdat \(\mu\) ongekend is (we gaan er hier voorlopig van uit dat \(\sigma\) wel gekend is). Het kan wel geschat worden als

\[\begin{equation*} \left[\bar X - 1.96 \frac{\sigma}{\sqrt{n}},\bar X + 1.96 \frac{\sigma}{\sqrt{n}}\right] \end{equation*}\]

Hoewel dit laatste interval nog steeds kan geïnterpreteerd worden als een referentie-interval voor het steekproefgemiddelde, kunnen we er een veel nuttigere interpretatie aan geven. Immers, de ongelijkheid \(\mu - 1.96 \ \sigma/\sqrt{n} < \bar{X}\) kan equivalent worden herschreven als \(\mu < \bar{X} + 1.96 \ \sigma/\sqrt{n}\). Hieruit volgt:

\[\begin{eqnarray*} 95\% &=& P( \mu - 1.96 \ \sigma/\sqrt{n} < \bar{X} < \mu + 1.96 \ \sigma/\sqrt{n} ) \\ &=&P( \bar{X} - 1.96 \ \sigma/\sqrt{n} < \mu < \bar{X} + 1.96 \ \sigma/\sqrt{n} ) \end{eqnarray*}\]

Dit leidt tot volgende definitie.

{.definition, name="95\\% betrouwbaarheidsinterval voor populatiegemiddelde"}

Het interval

\[\begin{equation} \left[\bar X - 1.96 \frac{\sigma}{\sqrt{n}},\bar X + 1.96 \frac{\sigma}{\sqrt{n}}\right] \tag{5.1} \end{equation}\]

bevat met 95% kans het populatiegemiddelde \(\mu\). Het wordt een 95% betrouwbaarheidsinterval (in het Engels: 95% confidence interval) voor het populatiegemiddelde \(\mu\) genoemd. De kans dat het de populatieparameter \(\mu\) bevat, d.i. 95%, wordt het betrouwbaarheidsniveau genoemd.

Einde definitie

Een 95% betrouwbaarheidsinterval bepaalt met andere woorden een reeks waarden waarbinnen de gezochte populatieparameter waarschijnlijk (namelijk met 95% kans) valt.

Stel dat we in een steekproef een bloeddrukdaling van -18.93mmHg observeren en dat we weten dat de standaarddeviatie van de bloeddrukmetingen 9mmHg bedraagt. Dan vinden we een betrouwbaarheidsinterval voor de gemiddelde bloeddrukdaling van

\[\left[-18.93-1.96\times 9/\sqrt{15},-18.9+1.95\times 9/\sqrt{15}\right]=[-23.48,-14.38]mmHg\]

De reden waarom over “95% kans” gesproken wordt, is omdat de eindpunten van het 95% betrouwbaarheidsinterval toevalsveranderlijken zijn die variëren van steekproef tot steekproef. Met andere woorden, verschillende steekproeven leveren telkens andere betrouwbaarheidsintervallen op, vermits die intervallen berekend zijn op basis van de gegevens in de steekproef. Men noemt het om die reden stochastische intervallen. Voor 95% van alle steekproeven zal het berekende 95% betrouwbaarheidsinterval de gezochte waarde van de populatieparameter bevatten, en voor de overige 5% niet. Dat wordt geïllustreerd a.d.h.v. een simulatiestudie in Sectie 5.4.3 (nadat we de intervallen hebben uitgebreid voor de meer realistische setting waarbij de variantie in de populatie ongekend is).

Uiteraard kunnen de onderzoekers o.b.v. een gegeven betrouwbaarheidsinterval niet besluiten of het de gezochte parameterwaarde bevat of niet, vermits ze precies op zoek zijn naar die onbekende waarde. Maar ze gebruiken een procedure die in 95% van de gevallen werkt; m.a.w. die in 95% van de gevallen de gezochte waarde bevat. Of nog, als men dagelijks gegevens zou verzamelen en telkens een 95% betrouwbaarheidsinterval zou berekenen voor een nieuwe parameter \(\theta\) (bvb. een odds ratio), dan zou men op lange termijn in 95% van de gevallen de gezochte waarde omvat hebben.

Tot nog toe zijn we ervan uitgegaan dat de individuele observaties Normaal verdeeld zijn en dat hun variantie gekend is (want als de variantie \(\sigma^2\) niet gekend is, kan men de grenzen van het interval niet berekenen). Wegens de Centrale Limietstelling bevat Vergelijking (5.1) het gemiddelde \(\mu\) bij benadering met 95% kans wanneer de steekproef groot is en de variantie van de individuele observaties gekend, maar hun verdeling ongekend is.

Wanneer bovendien de variantie ongekend is, kan me ze schatten door gebruik te maken van de steekproefvariantie \(S^2\) van de reeks observaties \(X_1,...,X_n\). Men kan aantonen dat het interval \([\bar{X} - 1.96 \ s/\sqrt{n} , \bar{X} + 1.96 \ s/\sqrt{n} ]\) dan het populatiegemiddelde met bij benadering 95% kans bevat, op voorwaarde dat de steekproef groot is. In de volgende sectie gaan we na hoe een betrouwbaarheidsinterval voor het populatiegemiddelde geconstrueerd kan worden wanneer de variantie ongekend is en de steekproef relatief klein.

5.4.1.1 NHANES log2 cholesterol voorbeeld

5.4.1.1.1 1 steekproef

set.seed(3146)

samp50 <- sample(fem$DirectChol,50)

ll <- mean(samp50 %>% log2) - 1.96*sd(samp50 %>% log2)/sqrt(50)

ul <- mean(samp50 %>% log2) + 1.96*sd(samp50 %>% log2)/sqrt(50)

popMean <- mean(fem$DirectChol%>%log2)

c(ll=ll,ul=ul,popMean=popMean)## ll ul popMean

## 0.4326245 0.6291622 0.5142563Bij 1 steekproef ligt het populatie gemiddelde binnen het BI of niet.

5.4.1.1.2 Herhaalde steekproeven

res$ll <- res$mean-1.96*res$se

res$ul <- res$mean+1.96*res$se

mu <- fem$DirectChol%>%

log2%>%

mean

res$inside<- res$ll <= mu & mu <= res$ul

res$n <- as.factor(res$n)

res %>%

group_by(n) %>%

summarize(coverage=mean(inside)) %>%

spread(n,coverage)## # A tibble: 1 × 3

## `10` `50` `100`

## <dbl> <dbl> <dbl>

## 1 0.92 0.942 0.954Merk op dat de omvang in de steekproeven met 10 waarnemingen te laag is omdat we geen rekening houden met de onzekerheid in de schatting van de standaarddeviatie.

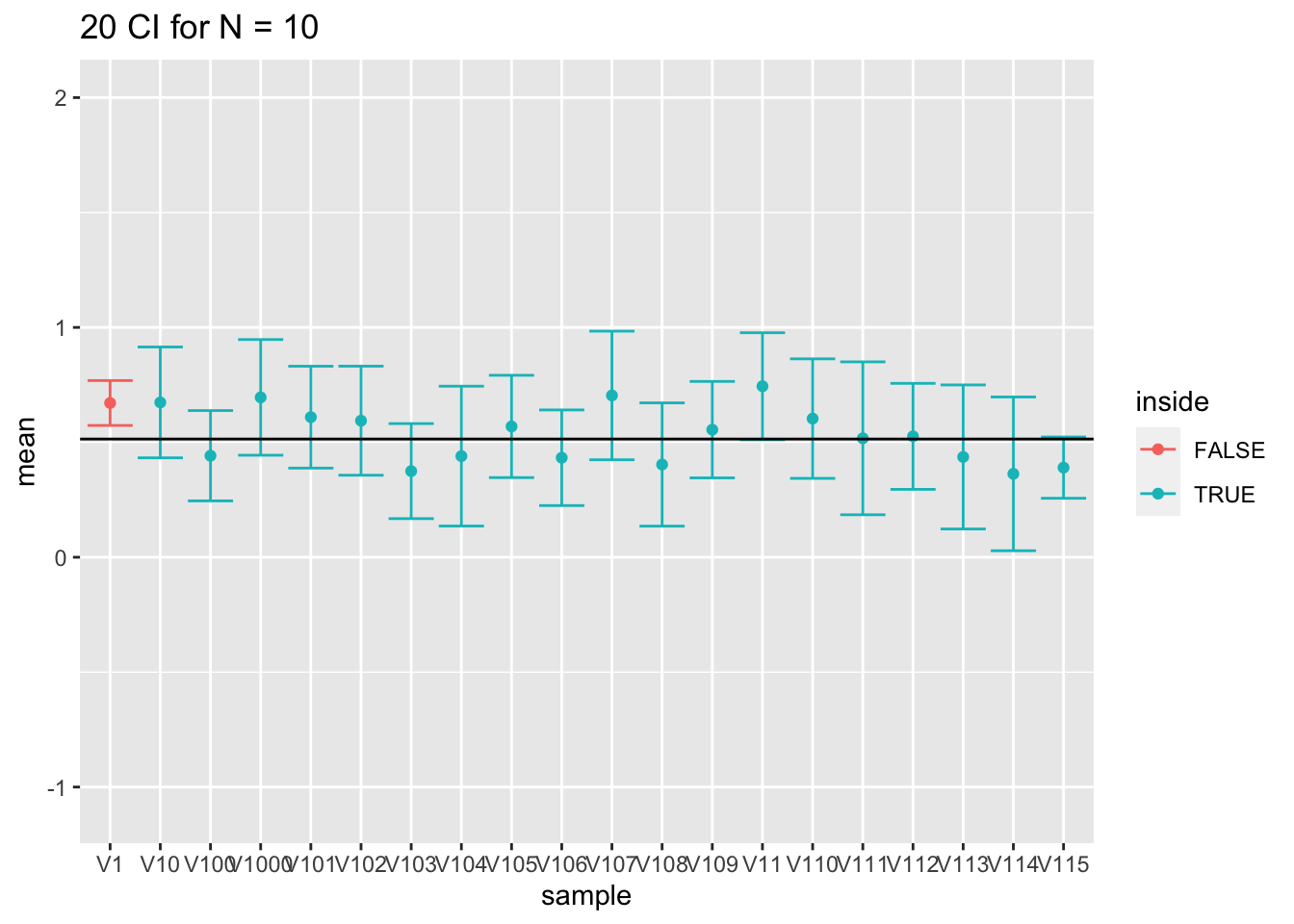

Als we kijken naar de eerste 20 intervallen, bevat 1 van de 20 niet het populatiegemiddelde.

res %>%

filter(n==10) %>%

slice(1:20) %>%

ggplot(aes(x = sample,y = mean,color = inside)) +

geom_point() +

geom_errorbar(aes(ymin = mean-1.96*se,ymax = mean+1.96*se))+

geom_hline(yintercept = fem$DirectChol %>% log2 %>% mean) +

ggtitle("20 CI for N = 10") +

ylim(range(fem$DirectChol %>% log2))

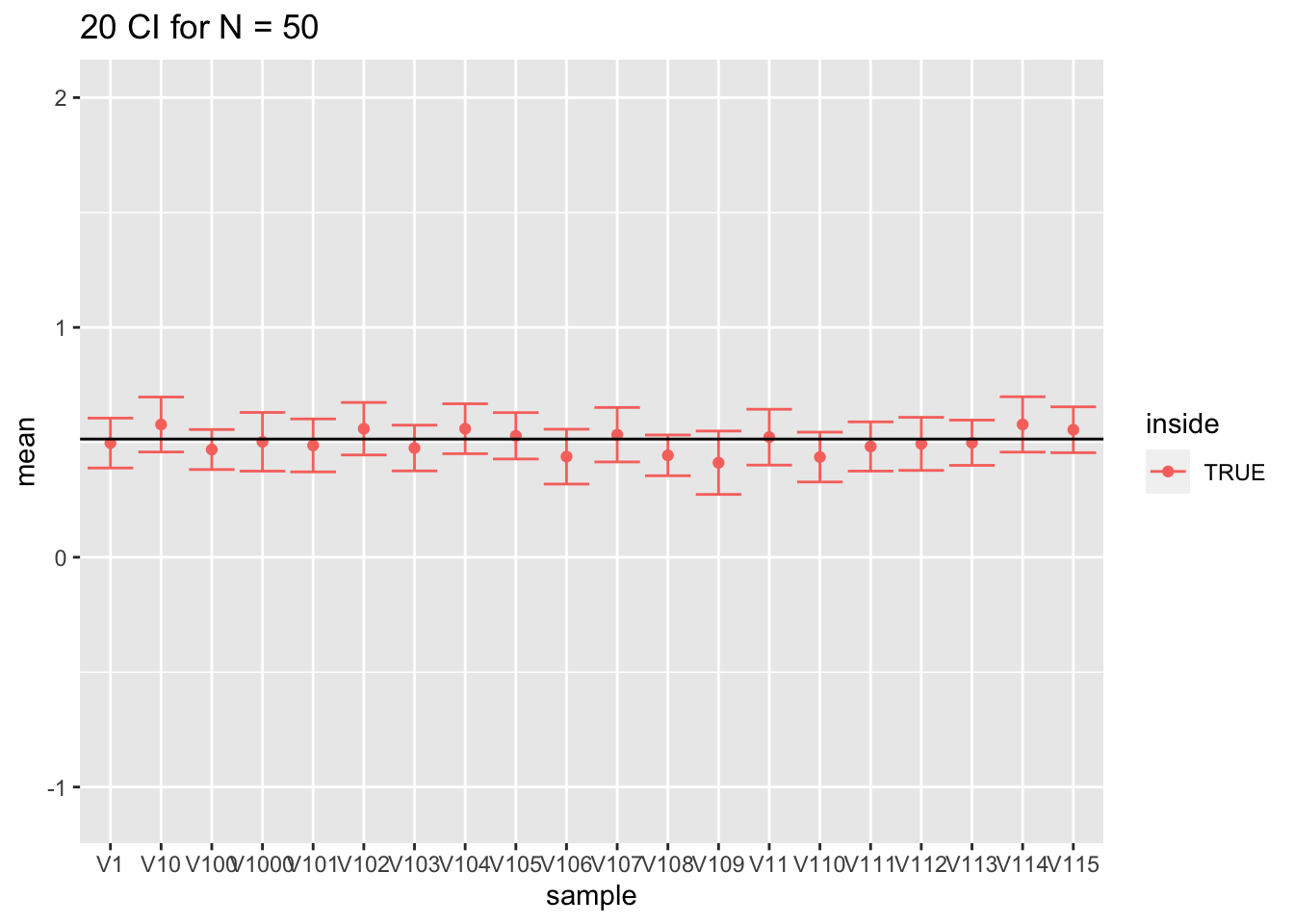

- Voor grote steekproeven (100) is de omvang prima omdat we de standaarddeviatie met een relatief hoge precisie kunnen schatten.

res %>%

filter(n == 50) %>%

slice(1:20) %>%

ggplot(aes(x = sample,y = mean,color = inside)) +

geom_point() +

geom_errorbar(aes(ymin = mean-1.96*se,ymax = mean+1.96*se))+

geom_hline(yintercept = fem$DirectChol %>% log2 %>% mean) +

ggtitle("20 CI for N = 50") +

ylim(range(fem$DirectChol %>% log2))

res %>%

filter(n == 100) %>%

slice(1:20) %>%

ggplot(aes(x = sample,y = mean,color = inside)) +

geom_point() +

geom_errorbar(aes(ymin = mean-1.96*se,ymax = mean+1.96*se))+

geom_hline(yintercept = fem$DirectChol %>% log2 %>% mean) +

ggtitle("20 CI for N = 100") +

ylim(range(fem$DirectChol %>% log2))

- Wat heb je geobserveerd voor de intervalbreedte?

5.4.1.2 Andere betrouwbaarheidsniveaus

Om een betrouwbaarheidsinterval met een ander betrouwbaarheidsniveau, \((1- \alpha)100\%\) te construeren, vervangt men 1.96 door het relevante kwantiel \(z_{\alpha/2}.\)

De breedte van een \(100\%(1-\alpha)\) betrouwbaarheidsinterval voor een populatiegemiddelde \(\mu\) is \(2 z_{\alpha/2} \ \sigma/\sqrt{n}\). Ze wordt dus bepaald door 3 factoren: de standaarddeviatie op de individuele observaties, \(\sigma\), de grootte van de steekproef, \(n\), en het betrouwbaarheidsniveau, \(1-\alpha\):

\(n\): naarmate de steekproefgrootte toeneemt, krimpt het betrouwbaarheidsinterval. In grote steekproeven beschikken we immers over veel informatie en kunnen we de gezochte populatieparameter bijgevolg relatief nauwkeurig afschatten.

\(\sigma\): naarmate de standaarddeviatie van de oorspronkelijke observaties toeneemt, neemt de lengte van het betrouwbaarheidsinterval toe. Indien er immers veel ruis op de gegevens zit, dan is het moeilijker om populatieparameters of -kenmerken te identificeren.

\(1-\alpha\): naarmate het betrouwbaarheidsniveau toeneemt, wordt het betrouwbaarheidsinterval breder. Indien we immers eisen dat het interval met 99.9% kans de populatiewaarde bevat i.p.v. met 80% kans, dan zullen we duidelijk een breder interval nodig hebben.

Betrouwbaarheidsintervallen worden niet enkel gebruikt voor het populatiegemiddelde, maar kunnen in principe voor om het even welke populatieparameter worden gedefinieerd. Zo kunnen ze bijvoorbeeld gedefinieerd worden voor een verschil tussen 2 gemiddelden, voor een odds ratio, voor een variantie, … De manier om die intervallen te berekenen is vaak complex en sterk afhankelijk van de gebruikte schatter voor de populatieparameter. Er wordt daarom niet van u verwacht dat u voor alle populatieparameters die we in deze cursus ontmoeten, een betrouwbaarheidsinterval kunt berekenen, maar wel dat u het kunt interpreteren.

{.definition, name="Betrouwbaarheidsinterval"}

Een \((1-\alpha)100\)% betrouwbaarheidsinterval voor een populatieparameter \(\theta\) is een

geschat (en bijgevolg stochastisch) interval dat met \((1-\alpha)100\)% kans

de echte waarde van die populatieparameter \(\theta\) bevat.

Einde Definitie

5.4.2 Ongekende variantie op de metingen

Tot nog toe werd verondersteld dat de populatievariantie \(\sigma^2\) gekend is bij het berekenen van een betrouwbaarheidsinterval voor \(\mu\). Betrouwbaarheidsintervallen voor \(\mu\) werden dan opgebouwd door op te merken dat de gestandaardiseerde waarde \((\bar{X} - \mu)/(\sigma/\sqrt{n})\) standaardnormaal verdeeld is en bijgevolg

\[\begin{equation*} \left[\mu - 1.96 \frac{\sigma}{\sqrt{n}},\mu + 1.96 \frac{\sigma}{\sqrt{n}}% \right] \end{equation*}\]

een 95% referentie-interval voor het steekproefgemiddelde voorstelt.

In de praktijk komt het quasi nooit voor dat men de populatievariantie \(\sigma^2\) exact kent. In de praktijk wordt deze geschat als \(S^2\) op basis van de voorhanden zijnde steekproef. Als gevolg hiervan zullen de betrouwbaarheidsintervallen uit voorgaande sectie doorgaans iets te smal zijn (omdat ze er geen rekening mee houden dat ook de variantie werd geschat) en is het noodzakelijk om bij de berekening \((\bar{X} - \mu)/(S/\sqrt{n})\) te gebruiken als gestandaardiseerde waarde i.p.v. \((\bar{X} - \mu)/(\sigma/\sqrt{n})\). Wanneer de steekproef voldoende groot is, ligt de vierkantswortel van variantie \(S^2\) voldoende dicht bij \(\sigma\) zodat \({(\bar{X} - \mu)}/{(S/\sqrt{n}) }\) bij benadering een standaardnormale verdeling volgt en, bijgevolg,

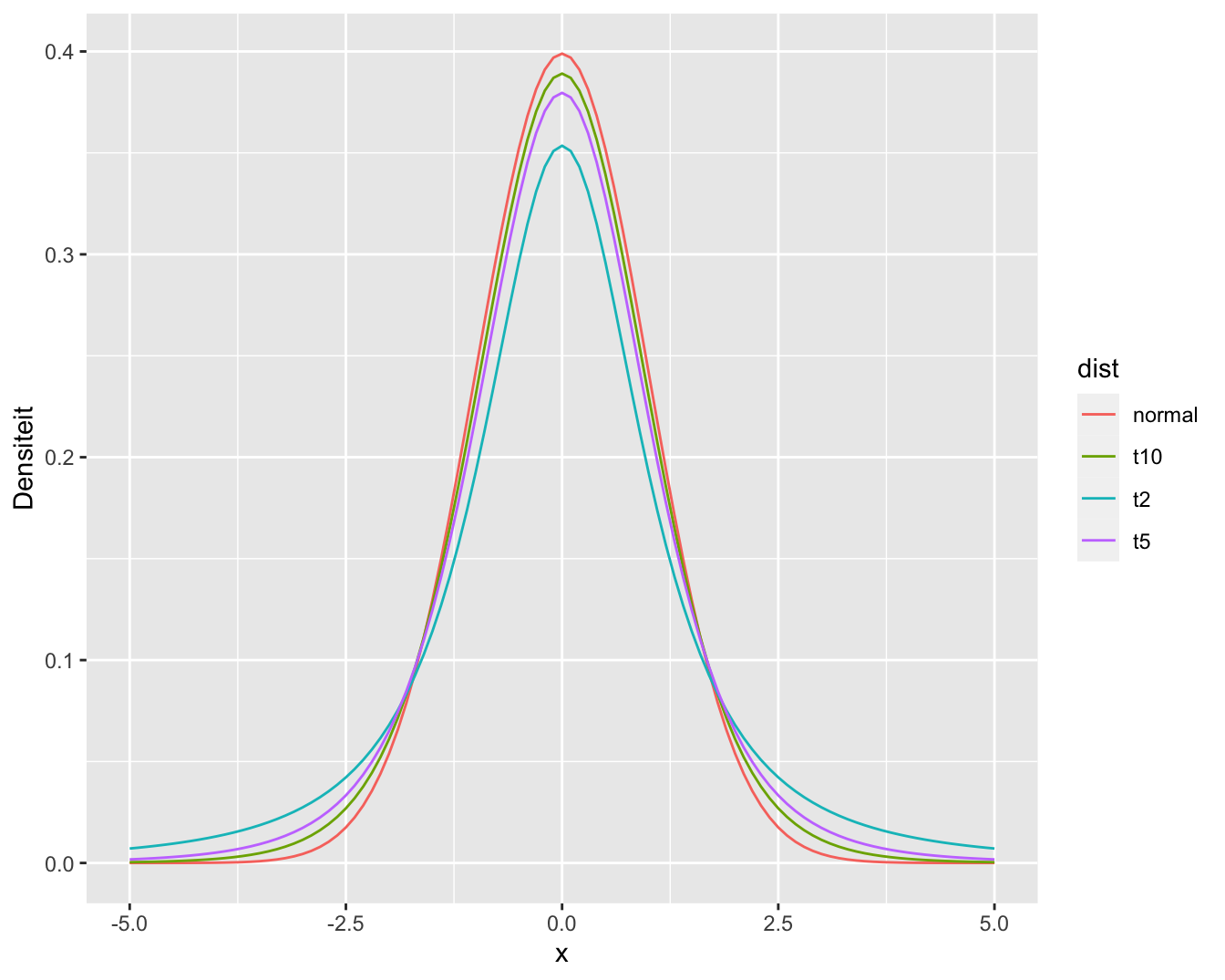

\[ \left[\bar{X} - z_{\alpha/2} \ \frac{S}{\sqrt{n}} , \bar{X} + z_{\alpha/2} \ \frac{S}{\sqrt{n}}\right] \]

een benaderd \((1- \alpha)100\%\) betrouwbaarheidsinterval is voor \(\mu\). Voor kleine steekproeven is dit niet langer het geval. Daardoor introduceert men een extra onnauwkeurigheid in de gestandaardiseerde waarde \({(\bar{X} - \mu)}/{(S/\sqrt{n})}\). Deze is nog wel gecentreerd rond nul en symmetrisch, maar niet langer Normaal verdeeld. De echte verdeling voor eindige steekproefgrootte \(n\) heeft zwaardere staarten dan de Normale. Hoeveel zwaarder de staarten zijn, hangt van de steekproefgrootte \(n\) af. Als \(n\) oneindig groot wordt, komt \(S\) zodanig dicht bij \(\sigma\) te liggen dat de extra onnauwkeurigheid in de gestandaardiseerde waarde verwaarloosbaar is en bijgevolg ook het verschil met de Normale verdeling. Maar voor relatief kleine steekproeven hangt de verdeling van \({(\bar{X} - \mu)}/({S/\sqrt{n}})\) af van de grootte \(n\) van de steekproef. Ze krijgt de naam (Student) \(t\)-verdeling met \(n-1\) vrijheidsgraden (in het Engels: degrees of freedom). Deze verdeling wordt voor een aantal verschillende vrijheidsgraden geïllustreerd in Figuur 5.7. De t-verdelingen in de figuur hebben duidelijk bredere staarten dan de normaalverdeling, waardoor ze ook een grotere percentielwaarden hebben voor een vooropgesteld betrouwbaarheidsniveau. Dat zal leiden tot bredere intervallen, wat logisch is aangezien we de extra onzekerheid inbouwen die gerelateerd is aan het schatten van de standaarddeviatie.

{.definition, name="t-verdeling"}

Als \(X_1, X_2, ..., X_n\) een steekproef vormen uit de Normale verdeling \(N(\mu, \sigma^2)\), dan is \((\bar{X} - \mu)/(S/\sqrt{n})\) verdeeld als een \(t\)-verdeling met \(n-1\) vrijheidsgraden.

**Einde Definitie

grid <- seq(-5,5,.1)

densDist <- cbind(grid,dnorm(grid), sapply(c(2,5,10),dt,x=grid))

colnames(densDist) <- c("x","normal",paste0("t",c(2,5,10)))

densDist %>%

as.data.frame %>%

gather(dist,dens,-x) %>%

ggplot(aes(x=x,y=dens,color=dist)) +

geom_line() +

xlab("x") +

ylab("Densiteit")

Figuur 5.7: Normale verdeling en t-verdeling met verschillende vrijheidsgraden.

Percentielen van de \(t\)-verdeling kunnen niet met de hand berekend worden, maar kan men voor de verschillende waarden van \(n\) aflezen in Tabellen of berekenen in R. In de onderstaande code wordt het 95%, 97.5%, 99.5% percentiel berekend voor een t-verdeling met 14 vrijheidsgraden, die gebruik kunnen worden voor de berekening van 90%, 95% en 99% betrouwbaarheidsintervallen.

qt(.975,df=14)## [1] 2.144787qt(c(.95,.975,.995),df=14)## [1] 1.761310 2.144787 2.976843We zien dat het 97.5% percentiel 2.14 voor een t-verdeling met \(n-1=14\) vrijheidsgraden inderdaad groter is dan het kwantiel uit de normaal verdeling 1.96.

Een gelijkaardige logica als voor de Normale verdeling met gekende variantie, geeft dan aan dat een \(100\% (1-\alpha)\) betrouwbaarheidsinterval voor het gemiddelde \(\mu\) van een Normaal verdeelde veranderlijke \(X\) met onbekende variantie kan berekend worden als

\[\begin{equation*} \left[\bar{X} - t_{n-1, \alpha/2} \frac{s}{\sqrt{n}} , \bar{X} + t_{n-1, \alpha/2} \frac{s}{\sqrt{n}}\right] \end{equation*}\]

Deze uitdrukking verschilt van deze in de vorige sectie doordat het \((1-\alpha/2)100\%\) percentiel van de Normale verdeling wordt vervangen door het \((1-\alpha/2)100\%\) percentiel van de t-verdeling met \(n-1\) vrijheidsgraden.

5.4.2.1 Captopril voorbeeld

Voor het captopril voorbeeld kunnen we dus een 95% betrouwbaarheidsinterval bekomen door

mean(delta) - qt(.975,df=14)*sd(delta)/sqrt(n)## [1] -23.93258mean(delta) + qt(.975,df=14)*sd(delta)/sqrt(n)## [1] -13.93409Een 99% betrouwbaarheidsinterval voor gemiddelde bloeddrukverandering wordt als volgt bekomen:

mean(delta) - qt(.995,df=14)*sd(delta)/sqrt(n)## [1] -25.87201mean(delta) + qt(.995,df=14)*sd(delta)/sqrt(n)## [1] -11.994665.4.3 Interpretatie van betrouwbaarheidsintervallen

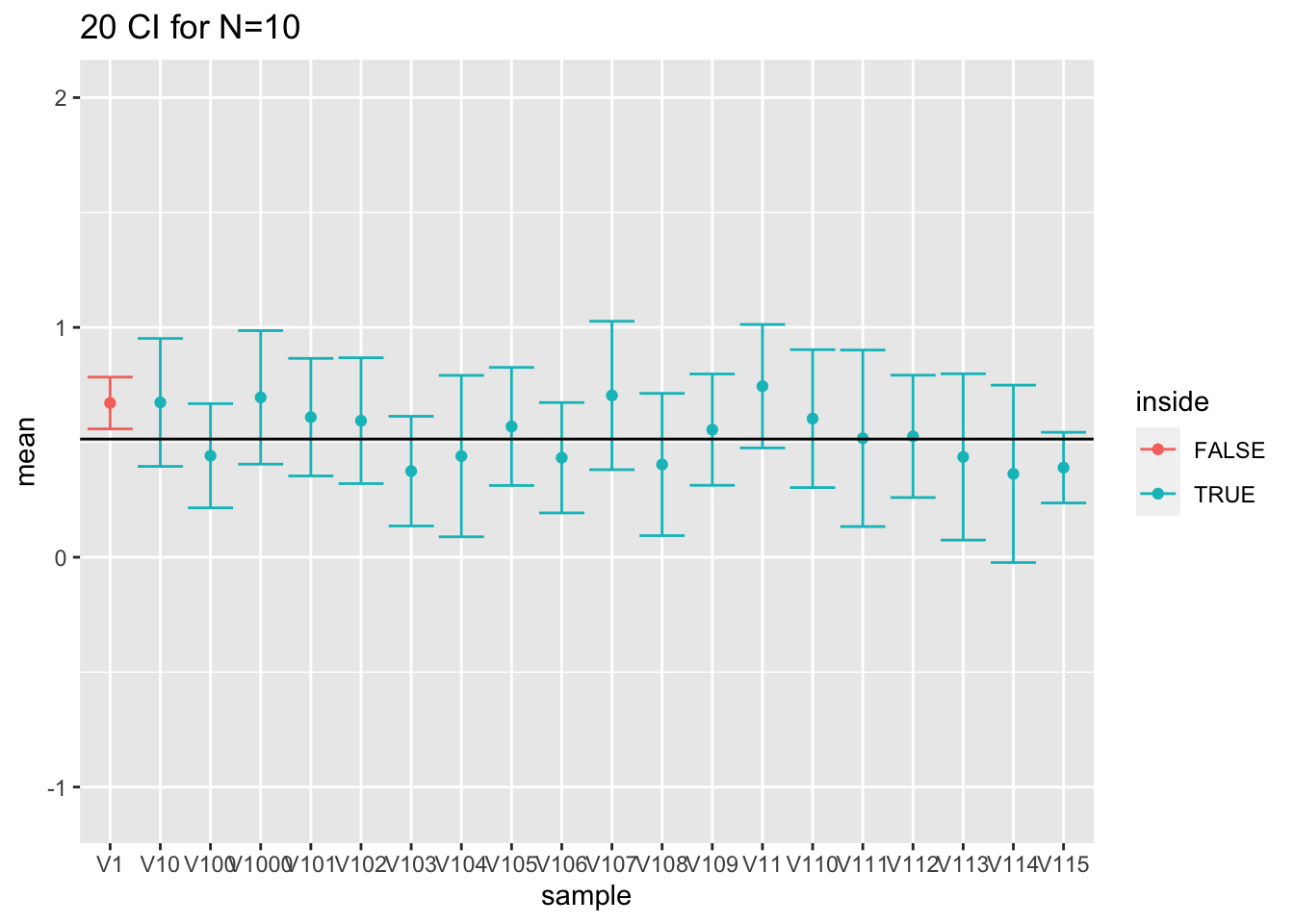

We zullen opnieuw steekproeven trekken van de grote NHANES studie en deze keer BI’s bestuderen voor log2-cholesterol steekproefwaarden. We voeren eerst herhaalde experimenten uit met steekproefgrootte 10.

res$n <- as.character(res$n) %>%

as.double(res$n)

res$ll <- res$mean-qt(0.975,df=res$n-1)*res$se

res$ul <- res$mean+qt(0.975,df=res$n-1)*res$se

mu <- fem$DirectChol%>%log2%>%mean

res$inside <- res$ll<=mu & mu<=res$ul

res$n <- as.factor(res$n)

res %>%

group_by(n) %>%

summarize(coverage=mean(inside)) %>%

spread(n,coverage)## # A tibble: 1 × 3

## `10` `50` `100`

## <dbl> <dbl> <dbl>

## 1 0.949 0.947 0.959We zien dat de omvang van de intervallen nu worden gecontroleerd op hun nominale betrouwbaarheidsniveau van 95%.

res %>%

filter(n==10) %>%

slice(1:20) %>%

ggplot(aes(x=sample,y=mean,color=inside)) +

geom_point() +

geom_errorbar(

aes(ymin=mean-qt(0.975,df=9)*se,

ymax=mean+qt(0.975,df=9)*se))+

geom_hline(yintercept = fem$DirectChol %>% log2 %>% mean) +

ggtitle("20 CI for N=10") +

ylim(range(fem$DirectChol %>% log2))

Figuur 5.8: Interpretatie van 95\(\%\) betrouwbaarheidintervallen. Resultaten op basis van 20 gesimuleerde steekproeven. We zien in de figuur duidelijk dat het populatiegemiddelde vast is maar ongekend (volle zwarte lijn) en dat de bovengrens en ondergrens van betrouwbaarheidsintervallen voor het populatiegemiddelde varieert van steekproef tot steekproef.

De simulatiestudie toont dus op een empirische wijze aan dat de constructie correct is. Het demonstreert bovendien de interpretatie van probabiliteit via herhaalde steekproefname. In Figuur 5.8 wordt de interpretatie ook grafisch weergegeven voor de eerste 20 gesimuleerde steekproeven. De figuur toont duidelijk aan dat het werkelijke populatiegemiddelde vast is maar ongekend. Het wordt geschat aan de hand van het steekproefgemiddelde dat at random varieert van steekproef tot steekproef rond het werkelijk gemiddelde. We zien ook dat de grenzen van de betrouwbaarheidsintervallen variëren van steekproef tot steekproef. Daarnaast varieert de breedte van de betrouwbaarheidsintervallen eveneens omdat de steekproefstandaarddeviatie eveneens varieert van steekproef tot steekproef29.

In de praktijk zullen we op basis van 1 steekproef besluiten dat het betrouwbaarheidsinterval het populatiegemiddelde bevat en we weten dat dergelijke uitspraken met een kans van \(1-\alpha\) (hier 95%) correct zijn.

Opdracht

Voer de bovenstaande simulatie studie opnieuw uit maar verdubbel de steekproefgrootte. Welke impact heeft dit op de BIs?

5.4.4 Wat rapporteren?

Rapporteer dus zeker steeds de onzekerheid op de resultaten! Conclusies trekken op basis van 1 schatting kan zeer misleidend zijn! In statistische analyses rapporteert men daarom systematisch betrouwbaarheidsintervallen. Betrouwbaarheidsintervallen vormen een goed compromis: ze zijn smal genoeg om informatief te zijn, maar haast nooit zeer misleidend. We besluiten dat de parameter die ons interesseert in het 95% betrouwbaarheidsinterval zit, en weten dat die uitspraak met 95% kans correct is. In de statistiek trekt men dus nooit absolute conclusies.

Op basis van de data-analyse voor het captopril voorbeeld kunnen we dus besluiten dat de gemiddelde bloeddrukdaling 18.9mmHg bedraagt na het toedienen van captopril. Met een 95% betrouwbaarheidsinterval op het gemiddelde van [-23.9,-13.9]mmHg. Op basis van het betrouwbaarheidsinterval is het duidelijk dat het toedienen van captopril resulteert in een sterke bloeddrukdaling bij patiënten met hypertensie.

5.5 Principe van Hypothesetoetsen (via one sample t-test)

We wensen een uitspraak te kunnen doen of er al dan niet een effect is van het toedienen van Captopril op de systolische bloeddruk? Beslissen op basis van gegevens is niet evident. Er is immers onzekerheid of de bevindingen uit de steekproef generaliseerbaar zijn naar de populatie. We stellen ons dus de vraag of het schijnbaar gunstig effect systematisch of toevallig is? Een natuurlijke beslissingsbasis is het gemiddeld verschil \(X\) in de systolische bloeddruk:

\[\bar x=-18.93mmHg (s = 9.03, SE = 2.33)\]

Dat \(\bar{x}< 0\) volstaat niet om te beslissen dat de gemiddelde systolische bloeddruk lager is na het toedienen van captopril op het niveau van de volledige populatie. Om het effect die we in de steekproef observeren te kunnen veralgemenen naar de populatie moet de bloeddrukverlaging voldoende groot zijn. Maar hoe groot moet dit effect nu zijn?

Hiervoor hebben statistici zogenaamde toetsen ontwikkeld om met dit soort vragen om te gaan. Deze leveren een ja/nee antwoord op de vraag of een geobserveerde associatie systematisch is (d.w.z. opgaat voor de studiepopulatie) of als er integendeel onvoldoende informatie in de steekproef voorhanden is om te besluiten dat de geobserveerde associatie ook aanwezig is in de volledige studiepopulatie. Tegenwoordig is het haast onmogelijk om een wetenschappelijk onderzoeksartikel te lezen zonder de resultaten van dergelijke toetsen te ontmoeten. Om die reden wensen we in dit hoofdstuk in te gaan op de betekenis van statistische toetsen en hun nomenclatuur.

We weten dat we volgens het falcificatieprincipe van Popper nooit een hypothese kunnen bewijzen op basis van data (zie Sectie 1.1). Daarom zullen we twee hypotheses introduceren: een nulhypothese en een alternatieve hypothese. We zullen dan later a.d.h.v. de toets de nulhypothese trachten te ontkrachten.

5.5.1 Introductie d.m.v. captopril voorbeeld

We introduceren hypothese testen eerst intuïtief a.d.h.v. het captopril voorbeeld.

Op basis van de steekproef kunnen we niet bewijzen dat er een effect is van het toedienen van captopril (\(H_1\), alternatieve hypothese).

We veronderstellen daarom dat er geen effect is van captopril

We noemen dit de nulhypothese \(H_0\).

Falsify (“probeer te ontkrachten”) de \(H_0\).

Hoe waarschijnlijk is het om een effect waar te nemen dat minstens zo groot is als wat we in de steekproef in een willekeurige steekproef hebben gezien als \(H_0\) waar is?

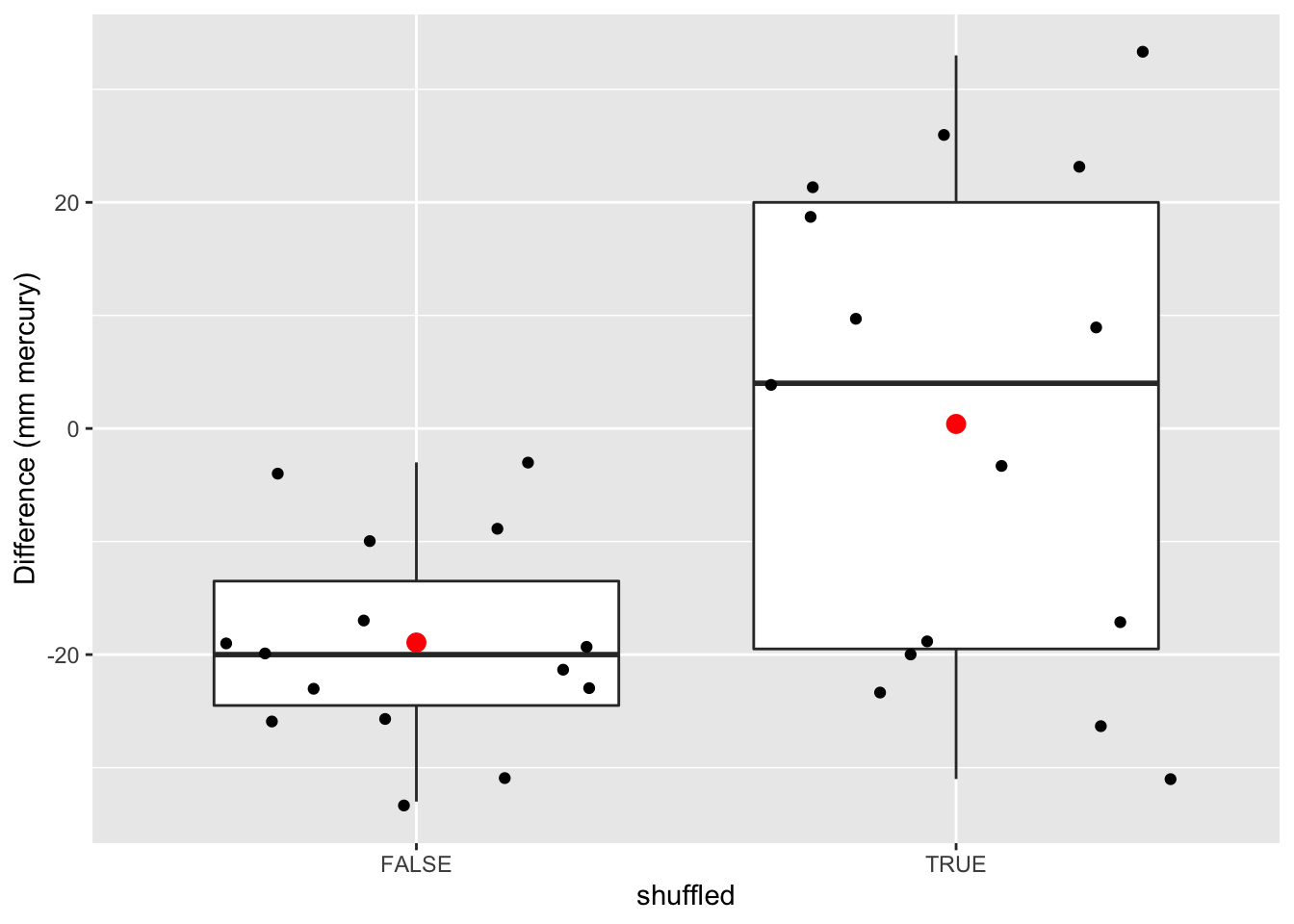

5.5.1.1 Permutatie test

Onder \(H_0\) zijn de bloeddrukmetingen voor en na toediening van captopril twee “base line” bloeddrukmetingen voor een patiënt

Onder \(H_0\) kunnen we de bloeddrukmetingen voor iedere patiënt in willekeurige volgorde plaatsen (permuteren).

set.seed(35)

captoprilSamp <- captopril

perm <- sample(c(FALSE, TRUE), 15, replace = TRUE)

captoprilSamp$SBPa[perm] <- captopril$SBPb[perm]

captoprilSamp$SBPb[perm] <- captopril$SBPa[perm]

captoprilSamp$deltaSBP <- captoprilSamp$SBPa-captoprilSamp$SBPb

captoprilSamp %>%

gather(type, bp, -id) %>%

filter(type %in% c("SBPa","SBPb")) %>%

mutate(type = factor(type, levels = c("SBPb", "SBPa")))%>%

ggplot(aes(x = type,y = bp)) +

geom_line(aes(group = id)) +

geom_point()

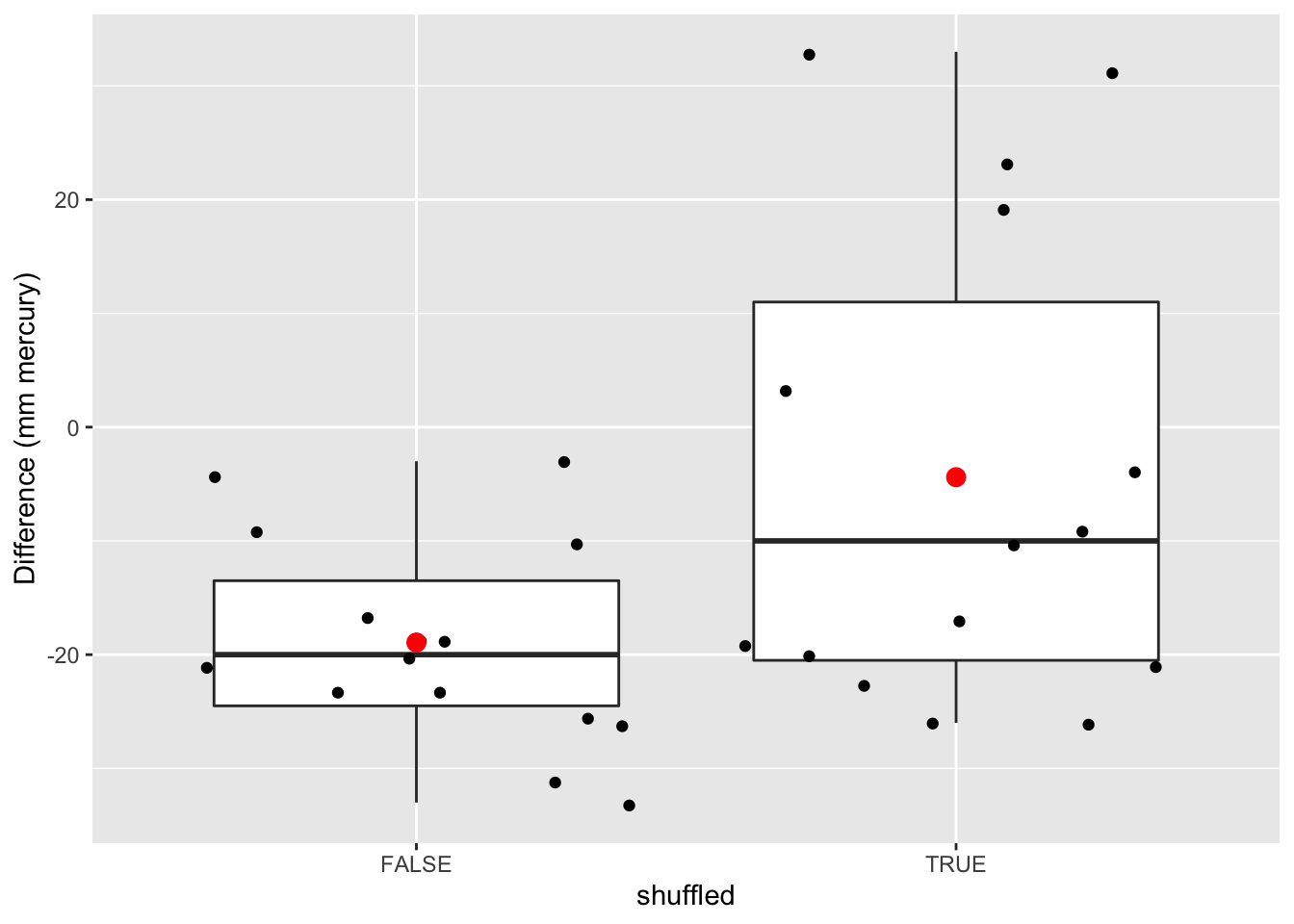

data.frame(

deltaSBP = c(captopril$deltaSBP,captoprilSamp$deltaSBP),

shuffled=rep(c(FALSE,TRUE),each=15)

) %>%

ggplot(aes(x = shuffled, y = deltaSBP)) +

geom_boxplot(outlier.shape = NA) +

geom_point(position = "jitter")+

stat_summary(

fun.y = mean,

geom = "point",

shape = 19,

size = 3,

color = "red",

fill = "red") +

ylab("Difference (mm mercury)")

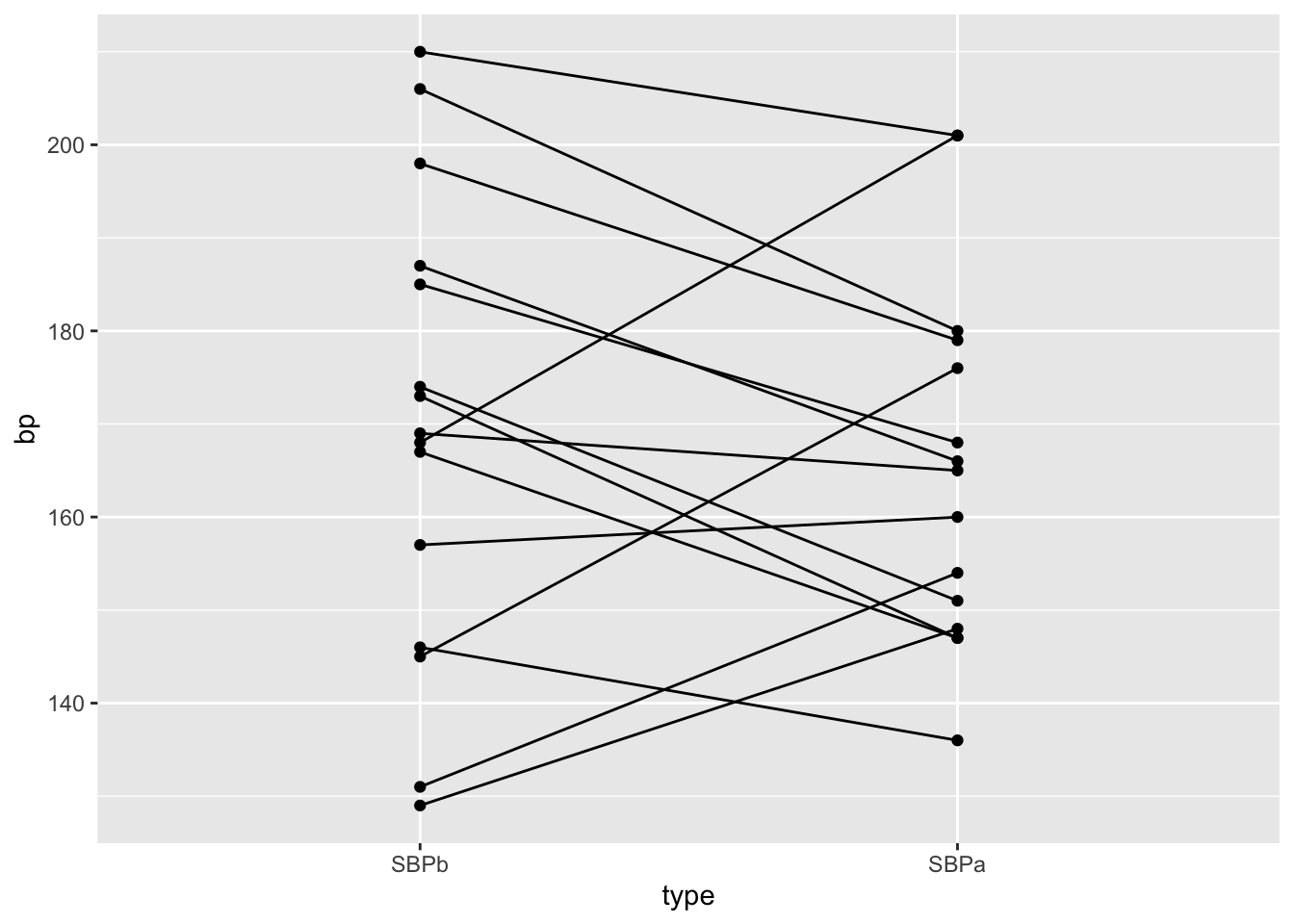

We permuteren opnieuw

captoprilSamp <- captopril

perm <- sample(c(FALSE,TRUE), 15, replace = TRUE)

captoprilSamp$SBPa[perm] <- captopril$SBPb[perm]

captoprilSamp$SBPb[perm] <- captopril$SBPa[perm]

captoprilSamp$deltaSBP <- captoprilSamp$SBPa-captoprilSamp$SBPb

captoprilSamp %>%

gather(type, bp, -id) %>%

filter(type %in% c("SBPa","SBPb")) %>%

mutate(type = factor(type, levels = c("SBPb", "SBPa")))%>%

ggplot(aes(x = type,y = bp)) +

geom_line(aes(group = id)) +

geom_point()

data.frame(

deltaSBP = c(captopril$deltaSBP,captoprilSamp$deltaSBP),

shuffled=rep(c(FALSE,TRUE),each=15)

) %>%

ggplot(aes(x = shuffled, y = deltaSBP)) +

geom_boxplot(outlier.shape = NA) +

geom_point(position = "jitter")+

stat_summary(

fun.y = mean,

geom = "point",

shape = 19,

size = 3,

color = "red",

fill = "red") +

ylab("Difference (mm mercury)")

- Er zijn \(2^{15}\) = 32768 mogelijke permutaties!

- We hoeven in principe alleen de tekens van de waargenomen bloeddrukverschillen \(x\) te wisselen als we permuteren.

permH <- expand.grid(

replicate(

15,

c(-1,1),

simplify=FALSE)

) %>%

t

permH[,1:5]## [,1] [,2] [,3] [,4] [,5]

## Var1 -1 1 -1 1 -1

## Var2 -1 -1 1 1 -1

## Var3 -1 -1 -1 -1 1

## Var4 -1 -1 -1 -1 -1

## Var5 -1 -1 -1 -1 -1

## Var6 -1 -1 -1 -1 -1

## Var7 -1 -1 -1 -1 -1

## Var8 -1 -1 -1 -1 -1

## Var9 -1 -1 -1 -1 -1

## Var10 -1 -1 -1 -1 -1

## Var11 -1 -1 -1 -1 -1

## Var12 -1 -1 -1 -1 -1

## Var13 -1 -1 -1 -1 -1

## Var14 -1 -1 -1 -1 -1

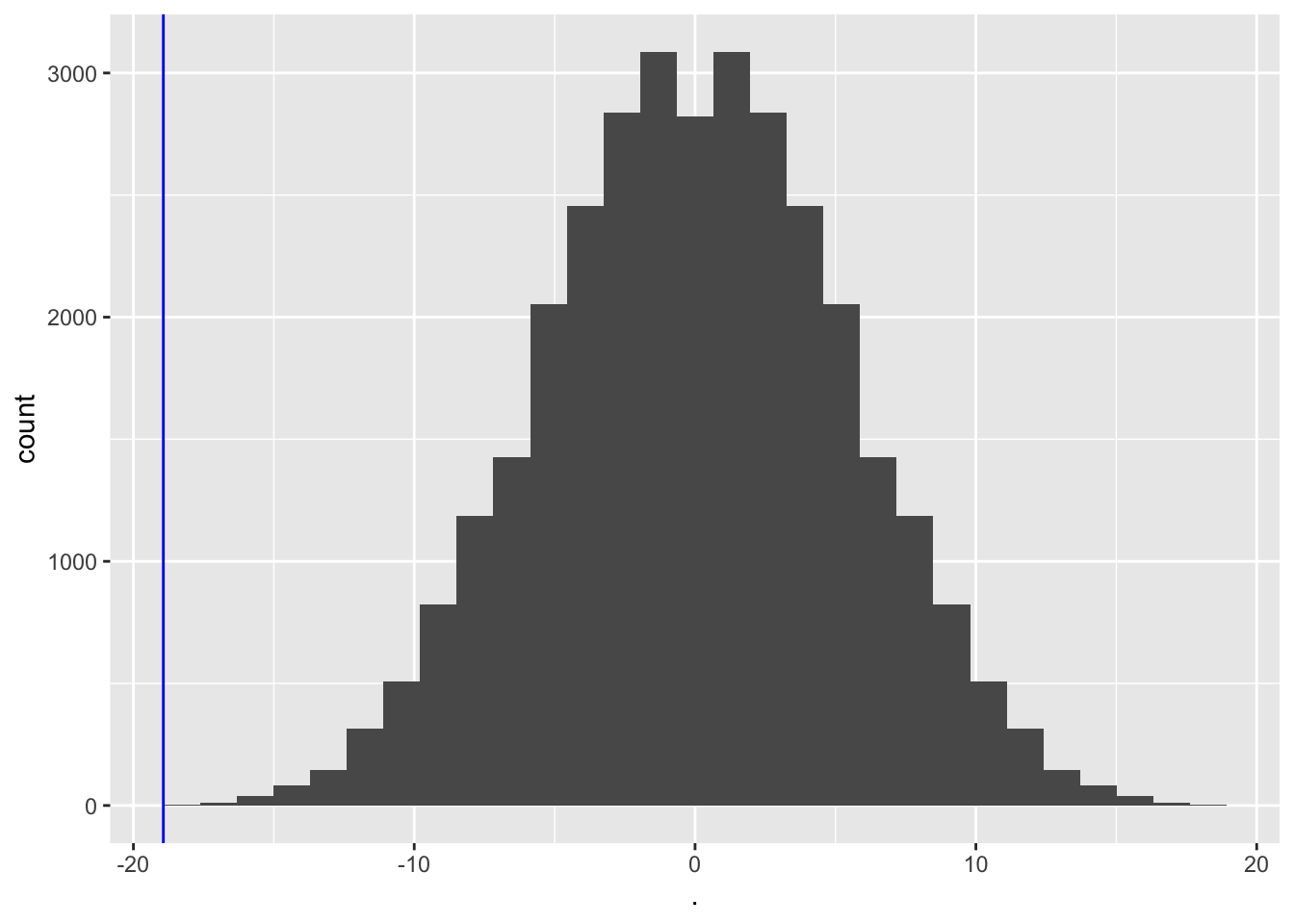

## Var15 -1 -1 -1 -1 -1- We zullen dit voor alle mogelijke permutaties doen en we zullen het gemiddelde bijhouden.

#calculate the means for the permuted data

muPerm <- colMeans(permH*captopril$deltaSBP)

muPerm %>%

as.data.frame %>%

ggplot(aes(x=.)) +

geom_histogram() +

geom_vline(

xintercept = mean(captopril$deltaSBP),

col = "blue")

sum(muPerm <= mean(captopril$deltaSBP))## [1] 1mean(muPerm <= mean(captopril$deltaSBP))## [1] 3.051758e-05We zien dat maar 1 van de gemiddelden die werden verkregen onder \(H_0\) (door permutatie) zo extreem was als het steekproefgemiddelde dat we in de captopril-studie hebben waargenomen.

Dus de kans om een bloeddrukdaling waar te nemen die groter of gelijk is dan die in de captopril-studie in een willekeurige steekproef onder de nulhypothese, is 1 op de 32768.

We hebben dus sterk bewijs dat \(H_0\) onjuist is en daarom verwerpen we \(H_0\) en concluderen \(H_1\): het toedienen van captopril heeft een effect op de bloeddruk van patiënten met hypertensie.

5.5.1.2 Pivot

In de praktijk gebruiken we altijd statistieken die de effectgrootte (gemiddeld verschil) afwegen tegen ruis (standaard error)

Als we de nulhypothese ontkrachten, standaardiseren we het gemiddelde rond \(\mu_0 = 0\) het gemiddelde onder \(H_0\)

\[t=\frac{\bar X-\mu_0}{se_{\bar X}}\]

- Voor het Captopril voorbeeld wordt dit: \[\frac{-18.93-0}{2.33}=-8.12\]

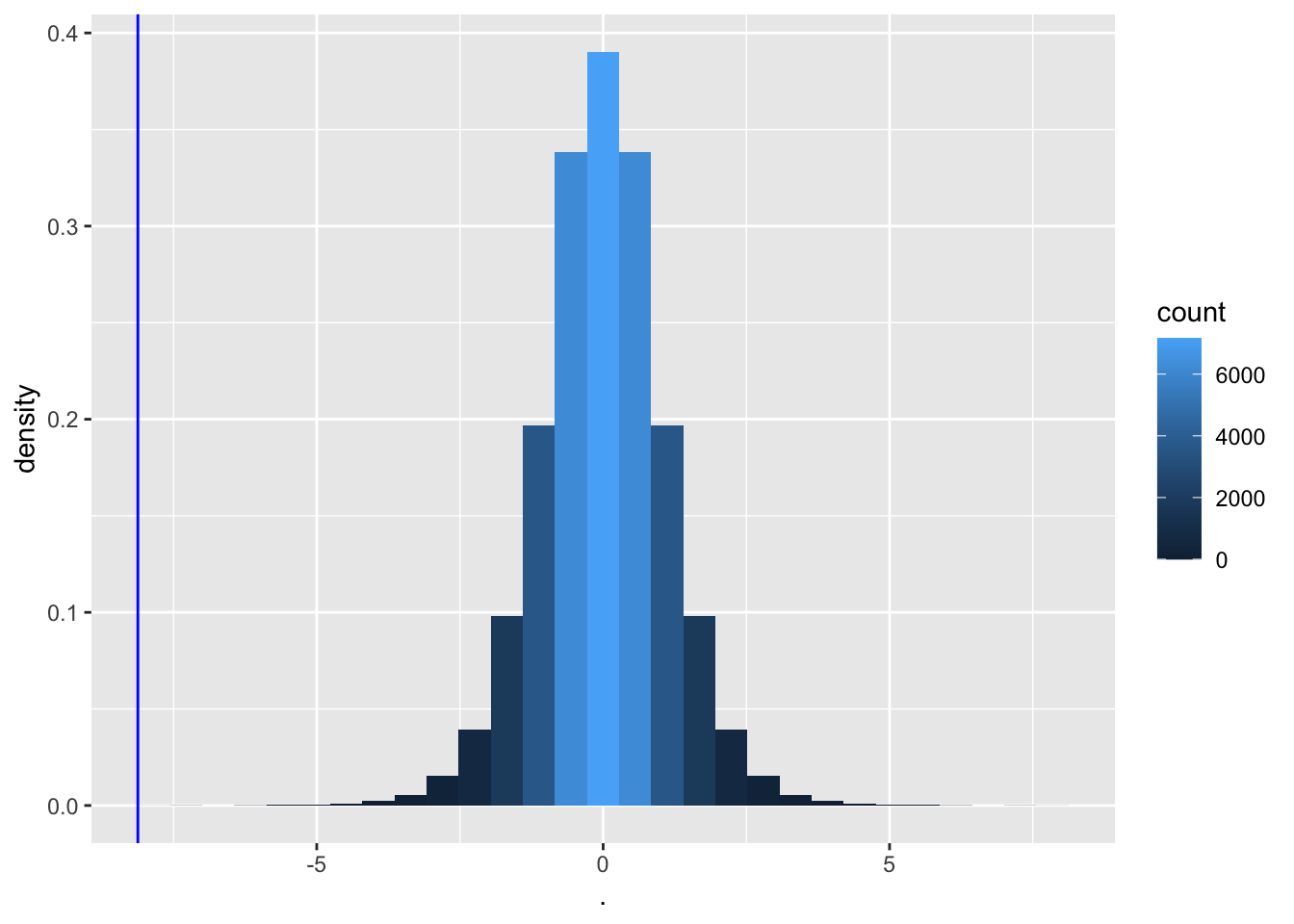

We bepalen nu de nulverdeling van teststatistiek t met permutatie.

deltaPerms <- permH*captopril$deltaSBP

tPerm <- colMeans(deltaPerms)/(apply(deltaPerms,2,sd)/sqrt(15))

tOrig <- mean(captopril$deltaSBP)/sd(captopril$deltaSBP)*sqrt(15)

tPermPlot <- tPerm %>%

as.data.frame %>%

ggplot(aes(x = .)) +

geom_histogram(aes(y = ..density.., fill = ..count..)) +

geom_vline(xintercept = tOrig,col = "blue")

tPermPlot

- Opnieuw heeft slechts 1 van de permutaties een t-statistiek die zo extreem is als de statistiek die wordt waargenomen in de captopril-studie.

Wanneer er geen effect is van captopril, is het bijna onmogelijk om een teststatistiek te verkrijgen die zo extreem is als degene die werd waargenomen in de steekproef (t=-8.12).

De kans om een grotere bloeddrukdaling waar te nemen dan degene die we in onze steekproef hebben waargenomen in een willekeurige steekproef onder \(H_0\) is 1/32768.

We noemen deze kans de p-waarde.

Het meet de sterkte van het bewijs tegen de nulwaarde: hoe kleiner de p-waarde, hoe meer bewijs we hebben dat de nulwaarde niet waar is.

De verdeling heeft een mooie klokvorm.

5.5.1.3 Hoe beslissen we?

Wanneer is de p-waarde klein genoeg om te concluderen dat er sterk bewijs is tegen de nulhypothese?

We werken doorgaans met een significantieniveau van \(\alpha = 0,05\)

We stellen dat we de test hebben uitgevoerd op het significantieniveau van 5%

5.5.1.4 Permutatietests zijn computationeel veeleisend

Kunnen we beoordelen hoe extreem de bloeddrukdaling was zonder permutatie?

We weten dat de bloeddrukverschillen ongeveer normaal verdeeld zijn, dus

\[t=\frac{\bar X - \mu}{se_{\bar X}}\]

volgt een t-verdeling (met 14 vrijheidsgraden voor het Captopril voorbeeld).

Onder \(H_0\) \(\mu=0\) en

\[t=\frac{\bar X-0}{se_{\bar X}}\sim f_{T,14}\]

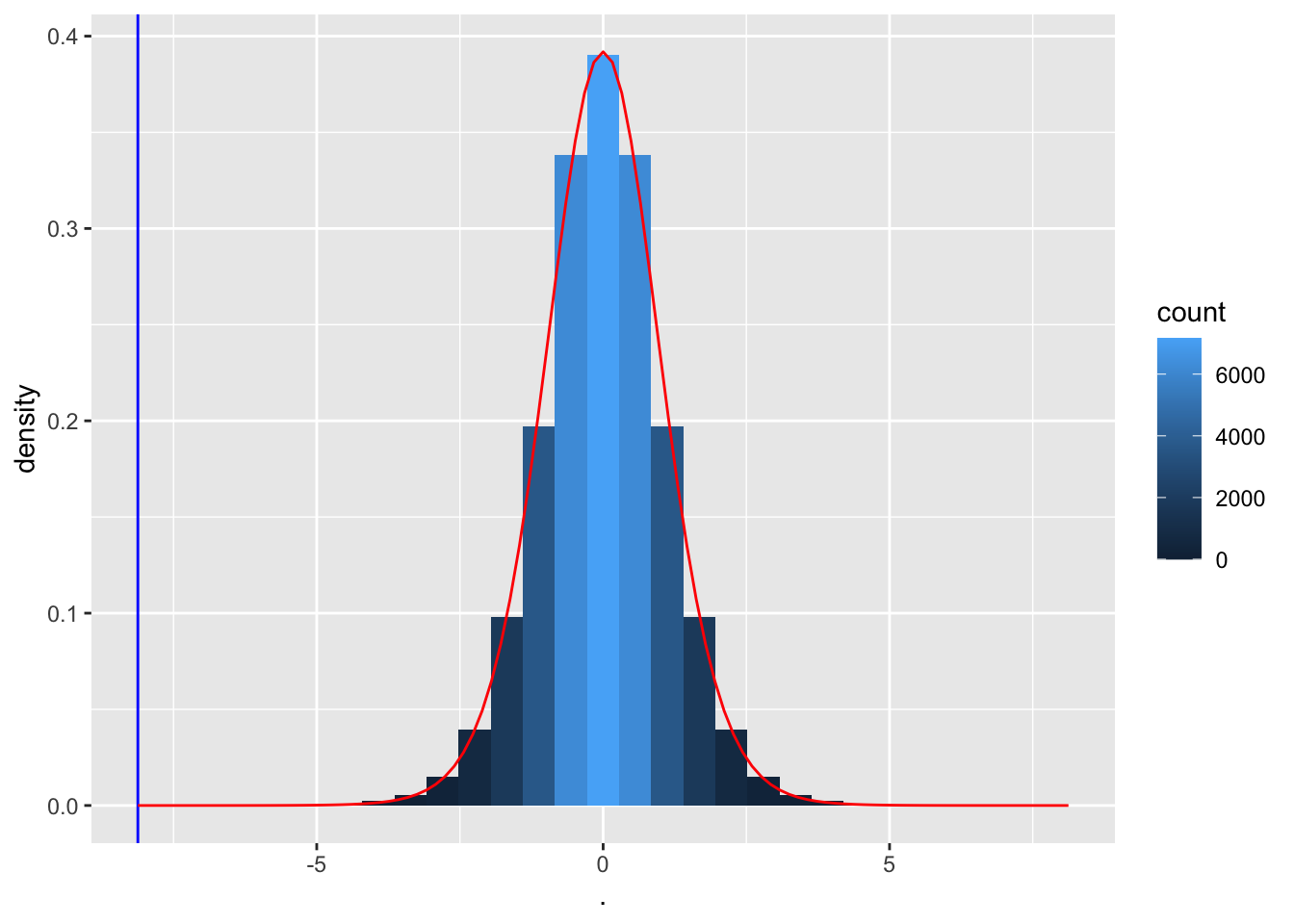

tPermPlot +

stat_function(

fun = dt,

color = "red",

args = list(df=14))

Merk op dat de permutatie-nulverdeling inderdaad overeenkomt met een t-verdeling met 14 vrijheidsgraden.

Zodat we de statistische test kunnen uitvoeren met behulp van statistische modellen van de gegevens.

Hiervoor moeten we assumpties maken, die we verifiëren in de data exploratie.

We overlopen nu alle componenten van een hypothese test waarbij we gebruik maken van veronderstellingen over de distributie van de gegevens.

5.5.2 Hypotheses

Algemeen starten we met het vertalen van de wetenschappelijke vraagstelling naar een nulhypothese (\(H_0\)) en een alternatieve hypothese (\(H_1\)). Dit kan pas nadat de probleemstelling vertaald is naar een geparametriseerd statistisch model. Uit de beschrijving van de proefopzet volgt dat \(X_1,...,X_n\) i.i.d.30 \(f(X)\) met \(f(X)\) de dichtheidsfunctie van de bloeddrukverschillen.

Vereenvoudiging: veronderstel dat \(f(X)\) gekend is op een eindig-dimensionale set van parameters \(\mathbf{\theta}\) na (parametrisch statistisch model). Voor het captopril voorbeeld veronderstellen we dat \(f(X)\) een normale distributie \(N(\mu,\sigma^2)\) volgt met parameters \(\mathbf{\theta}=(\mu,\sigma^2)\), het gemiddelde \(\mu\) en variantie \(\sigma^2\).

De vraagstelling is geformuleerd in termen van de gemiddelde bloeddrukdaling: \(\mu=E_f[X]\).

De alternatieve hypothese wordt geformuleerd in termen van een parameter van \(f(X)\) en dient uit te drukken wat de onderzoekers wensen te bewijzen aan de hand van de studie. Hier:

\[H_1: \mu<0.\]

Gemiddeld gezien daalt de bloeddruk bij patiënten met hypertensie na toediening van captopril.

De nulhypothese is meestal een uitdrukking van de nultoestand, i.e. de omstandigheden waarin niets bijzonders aan de hand is. De onderzoekers wensen meestal te bewijzen via empirisch onderzoek dat de nulhypothese niet waar is: Falsificatie principe. De nulhypothese wordt veelal uitgedrukt door gebruik te maken van dezelfde parameter als deze die in \(H_1\) gebruikt is. Hier:

\[H_0 : \mu=0\]

m.a.w. gemiddeld gezien blijft de systolische bloeddruk na toediening van captopril onveranderd.

5.5.3 Test-statistiek

Eens de populatie, de parameters en de nulhypothese en alternatieve hypothese bepaald zijn, kan de basisgedachte van een hypothesetest als volgt bondig beschreven worden.

Construeer een teststatistiek zodanig dat deze

- de evidentie meet die aanwezig is in de steekproef,

- tegen de gestelde nulhypothese,

- ten voordele van de alternatieve hypothese.

Een teststatistiek is dus noodzakelijk een functie van de steekproefobservaties.

Voor het captopril voorbeeld drukt de statistiek

\[T=\bar X - \mu_0\]

uit hoever het steekproefgemiddelde van de bloeddrukdaling ligt van het gemiddelde \(\mu_0=0\) in de populatie onder de nulhypothese31.

- Als \(H_0\) waar is en er dus geen effect is van captopril in de populatie, dan verwachten we dat de teststatistiek T dicht ligt bij \(T=0\)

- Als \(H_1\) waar is, dan verwachten we dat \(T<0\).

In de praktijk gebruiken we echter meestal teststatistieken die niet alleen de grootte van het effect in rekening brengen maar ook de onzekerheid op het effect. We doen dit door de effectgrootte te balanceren t.o.v. de standard error.

\[T=\frac{\bar{X}-0}{\text{SE}_{\bar X}}\]

Waarbij \(\mu_0=0\) voor het captopril voorbeeld.

Opnieuw geldt dat

- Als \(H_0\) waar is en er dus geen effect is van captopril in de populatie, dan verwachten we dat de teststatistiek T dicht ligt bij \(T=0\)

- Als \(H_1\) waar is, dan verwachten we dat \(T<0\).

- Voor het captopril voorbeeld vinden we \(t=(-18.93-0)/2.33=-8.12\).

- Is \(t = -8.12\) groot genoeg in absolute waarde om te kunnen besluiten dat \(\mu < 0\) en met welke zekerheid kunnen we dit besluiten?

Om daar een uitspraak over te doen zullen we de teststatistiek T verder bestuderen. T is een toevalsveranderlijke en de verdeling van T hangt af van de verdeling van de steekproefobservaties, maar die verdeling is ongekend! We hebben normaliteit verondersteld, maar dit laat nog steeds het gemiddelde en de variantie onbepaald. Bovendien wordt de hypothesetest net geconstrueerd om een uitspraak te kunnen doen over het gemiddelde \(\mu\)! De oplossing zit in de nulhypothese die we kunnen veronderstellen als er geen effect is van captopril. De \(H_0\) stelt dat \(\mu=0\). Als we aannemen dat \(H_0\) waar is, dan is het gemiddelde van de normale distributie gekend! Als de bloeddrukverschillen \(X_1, \ldots X_{15}\) onafhankelijk en identiek normaal verdeeld (i.i.d.) zijn, dan weten we dat

\[\bar X \stackrel{H_0}{\sim} N(0, \sigma^2/n)\]

Gezien we \(\sigma^2\) niet kennen kunnen we deze vervangen door de steekproef variantie. Dan weten we dat

\[T=\frac{\bar{X}-0}{\text{SE}_{\bar X}}\stackrel{H_0}{\sim} t(n-1) \]

een t-verdeling volgt met n-1 vrijheidsgraden onder de nulhypothese. We weten dat indien de alternatieve hypothese waar zou zijn, we mogen verwachten dat er meer kans is op het observeren van een kleine waarde voor de teststatistiek dan wat verwacht wordt onder de nulhypothese. We zullen de verdeling van de teststatistiek onder de nulhypothese gebruiken om na te gaan of de geobserveerde test-statistiek \(t = -8.12\) klein genoeg is om te kunnen besluiten dat \(\mu < 0\).

- Is de geobserveerde teststatistiekwaarde (\(t=-8.12\)) een waarde die we verwachten als \(H_0\) waar is, of is het een waarde die onwaarschijnlijk klein is als \(H_0\) waar is?

- In het laatste geval deduceren we dat we niet langer kunnen aannemen dat \(H_0\) waar is, en dienen we dus \(H_1\) te concluderen.

- De vraag blijft: (a) hoe groot moet de geobserveerde teststatistiek \(t\) zijn opdat we \(H_0\) verwerpen zodat (b) we bereid zijn om \(H_1\) te besluiten en (c) hoe zeker zijn we van deze beslissing?

- Het antwoord hangt samen met de interpretatie van de kansen die berekend kunnen worden op basis van de nuldistributie32 en de geobserveerde teststatistiek \(t\).

5.5.4 De p-waarde

De kans waarop de keuze tussen \(H_0\) en \(H_1\) gebaseerd wordt, wordt de \(p\)-waarde genoemd. De berekeningswijze is context-afhankelijk, maar voor het huidige voorbeeld wordt de \(p\)-waarde gegeven door

\[ p = P\left[T \leq t \mid H_0\right] = \text{P}_0\left[T\leq t\right], \]

waar de index “0” in \(\text{P}_0\left[.\right]\) aangeeft dat de kans onder de nulhypothese berekend wordt. Het is met andere woorden de kans om in een willekeurige steekproef onder de nulhypothese een waarde voor de teststatistiek T te bekomen die lager of gelijk is aan33 de waarde die in de huidige steekproef werd geobserveerd.

De \(p\)-waarde voor het captopril voorbeeld wordt berekend als

\[p= \text{P}_0\left[T\leq -8.12\right]=F_t(-8.12;14) = 0.6\ 10^{-6}.\]

waarbij \(F_t(;14)\) de cumulatieve distributie functie is van een t-verdeling met 14 vrijheidsgraden,

\[F_t(x;14)=\int\limits_{-\infty}^{x} f_t(x;14).\]

Waarbij \(f_t(.;14)\) de densiteitsfunctie is van de t-verdeling.

De oppervlakte onder de densiteitsfunctie is opnieuw een kans.

Deze kans kan berekend worden in R m.b.v. de functie pt(x,df) die twee argumenten heeft, de waarde van de test-statistiek x en het aantal vrijheidsgraden van de t-verdeling df.

pt(x,df) berekent de kans om een waarde te observeren die kleiner of gelijk is aan x wanneer men een willekeurige observatie trekt uit een t-verdeling met df vrijheidsgraden.

n <- length(delta)

stat<-(mean(delta)-0)/(sd(delta)/sqrt(n))

stat## [1] -8.122816pt(stat,n-1)## [1] 5.731936e-07{.definition, name="$p$-waarde"}

De p-waarde (ook wel geobserveerd significantieniveau genoemd) is de

kans om onder de nulhypothese een even of meer “extreme” toetsinggrootheid

waar te nemen (in de richting van het alternatief) dan de waarde \(t\) die

geobserveerd werd o.b.v. de steekproef. Hoe kleiner die kans is, hoe sterker het bewijs tegen de

nulhypothese.

Merk op dat de p-waarde de kans niet uitdrukt dat de nulhypothese waar is!34.

Einde Definitie

Het woord “extreem” duidt op de richting waarvoor de teststatistiek onder de alternatieve hypothese meer waarschijnlijk is. In het voorbeeld is \(H_1: \mu < 0\) en verwachten we dus kleinere waarden van \(t\) onder \(H_1\). Vandaar de kans op \(T\leq t\). Uit de definitie van de \(p\)-waarde volgt dat een kleine \(p\)-waarde betekent dat de geobserveerde teststatistiek eerder onwaarschijnlijk is als aangenomen wordt dat \(H_0\) correct is. Dus een voldoende kleine \(p\)-waarde noopt ons tot het verwerpen van \(H_0\) ten voordele van \(H_1\). De drempelwaarde waarmee de \(p\)-waarde vergeleken wordt, wordt het significanctieniveau genoemd en wordt voorgesteld door \(\alpha\).

{.definition, name="significantieniveau"}

De drempelwaarde \(\alpha\) staat gekend als het significantieniveau van de statistische test. Een statistische test uitgevoerd op het \(\alpha\) significantieniveau wordt een niveau-\(\alpha\) test genoemd (Engels: level-\(\alpha\) test).

Einde definitie

Een toetsingsresultaat wordt statistisch significant genoemd wanneer de bijhorende p-waarde kleiner is dan \(\alpha\), waarbij \(\alpha\) meestal gelijk aan 5% wordt genomen. Hoe kleiner de p-waarde hoe meer `significant’ het testresultaat afwijkt van de verwachting onder de nulhypothese. Het aangeven van een p-waarde voor een toets geeft bijgevolg meer informatie over het resultaat dan een eenvoudig ja/nee antwoord of de nulhypothese wordt verworpen op een vast gekozen \(\alpha\)-niveau. Het geeft immers niet alleen aan of de nulhypothese verworpen wordt op een gegeven significantieniveau, maar ook op welke significantieniveaus de nulhypothese verworpen wordt.

Ze vat dus de bewijskracht tegen de nulhypothese samen

\[\begin{array}{cl}>0.10 & \text{ niet significant (zwak bewijs)}\\0.05-0.10 & \text{ marginaal significant, suggestief}\\0.01-0.05 & \text{ significant}\\0.001-0.01 & \text{ sterk significant}\\<0.001 & \text{ extreem significant}\end{array}\]

5.5.5 Kritieke waarde

Een alternatieve wijze voor de formulering van de beslissingsregel kan worden bekomen door gebruik te maken van een kritieke waarde. In plaats van \(p\)-waarden, kan de beslissingsregel geschreven worden in termen van de teststatistiek. Bij gebruik van \(p\)-waarden bepaalt \(p=\alpha\) de grens. Een \(p\)-waarde van \(\alpha\) schrijven we als

\[p=\text{P}_0 \left[ T \leq t \right]=\alpha.\]

Dat is exact de definitie van het het \(\alpha\)-percentiel van de distributie van \(T\). In het voorbeeld is de nuldistributie \(t_{n-1}\). Dus,

\[\text{P}_0\left[T\leq -t_{n-1;\alpha}\right]=\alpha.\]

De beslissingsregel mag dus ook geschreven worden als

\[\begin{eqnarray*} \text{als } & t< -t_{n-1;\alpha} & \text{ dan verwerp }H_0\text{ en besluit }H_1 \\ \text{als } & t\geq -t_{n-1;\alpha} & \text{ dan aanvaard }H_0. \end{eqnarray*}\]

Het percentiel \(t_{n-1;\alpha}\) dat de drempelwaarde vormt in de beslissingsregel wordt in deze context de kritieke waarde op het \(5\%\) significantieniveau genoemd. De beslissingsregel waarbij de geobserveerde \(t\) vergeleken wordt met een kritieke waarde is minder algemeen geformuleerd dan deze gebruik makend van de \(p\)-waarde omdat het expliciet gebruik maakt van de nuldistributie die van teststatistiek tot teststatistiek, of zelfs van dataset tot dataset kan variëren.

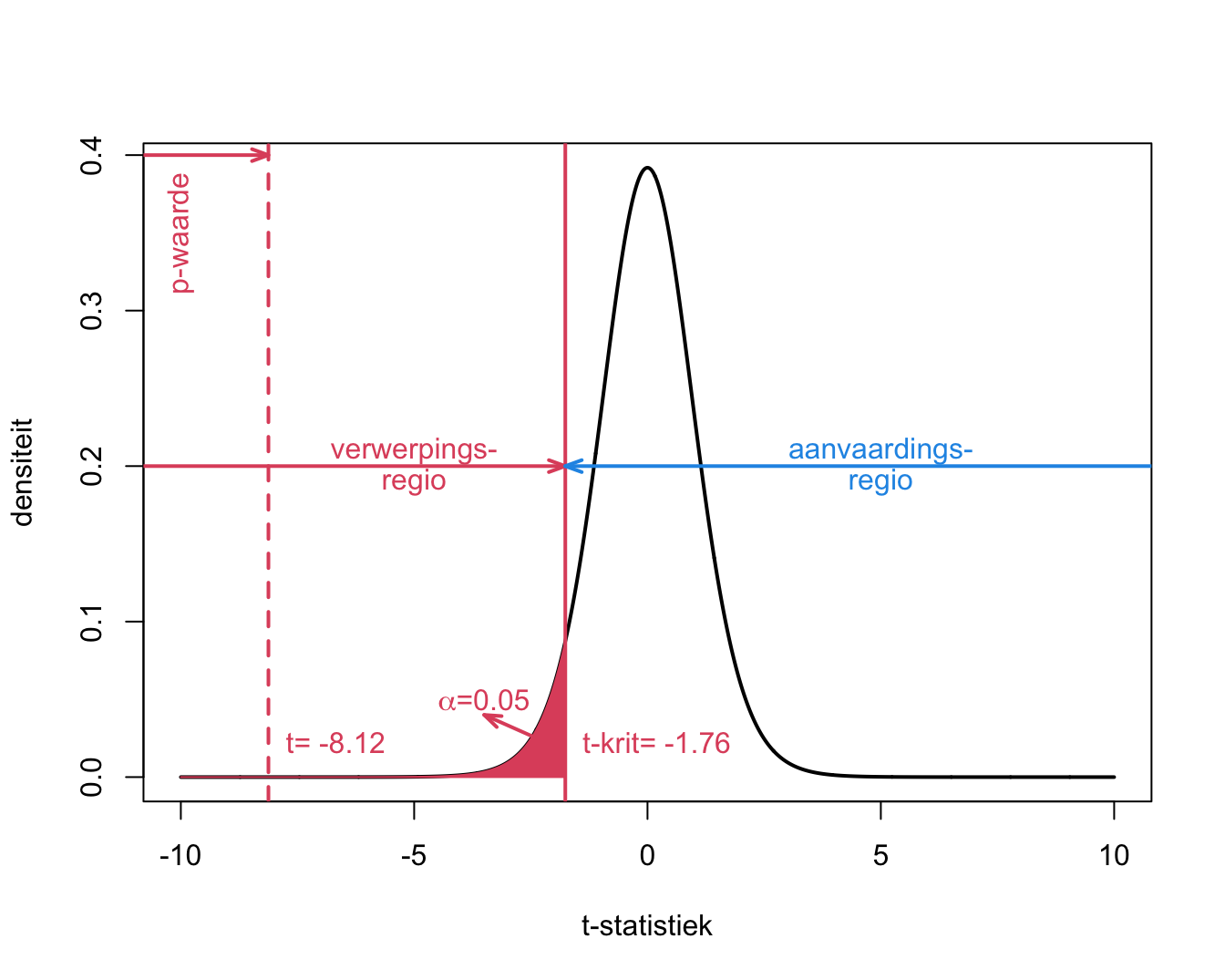

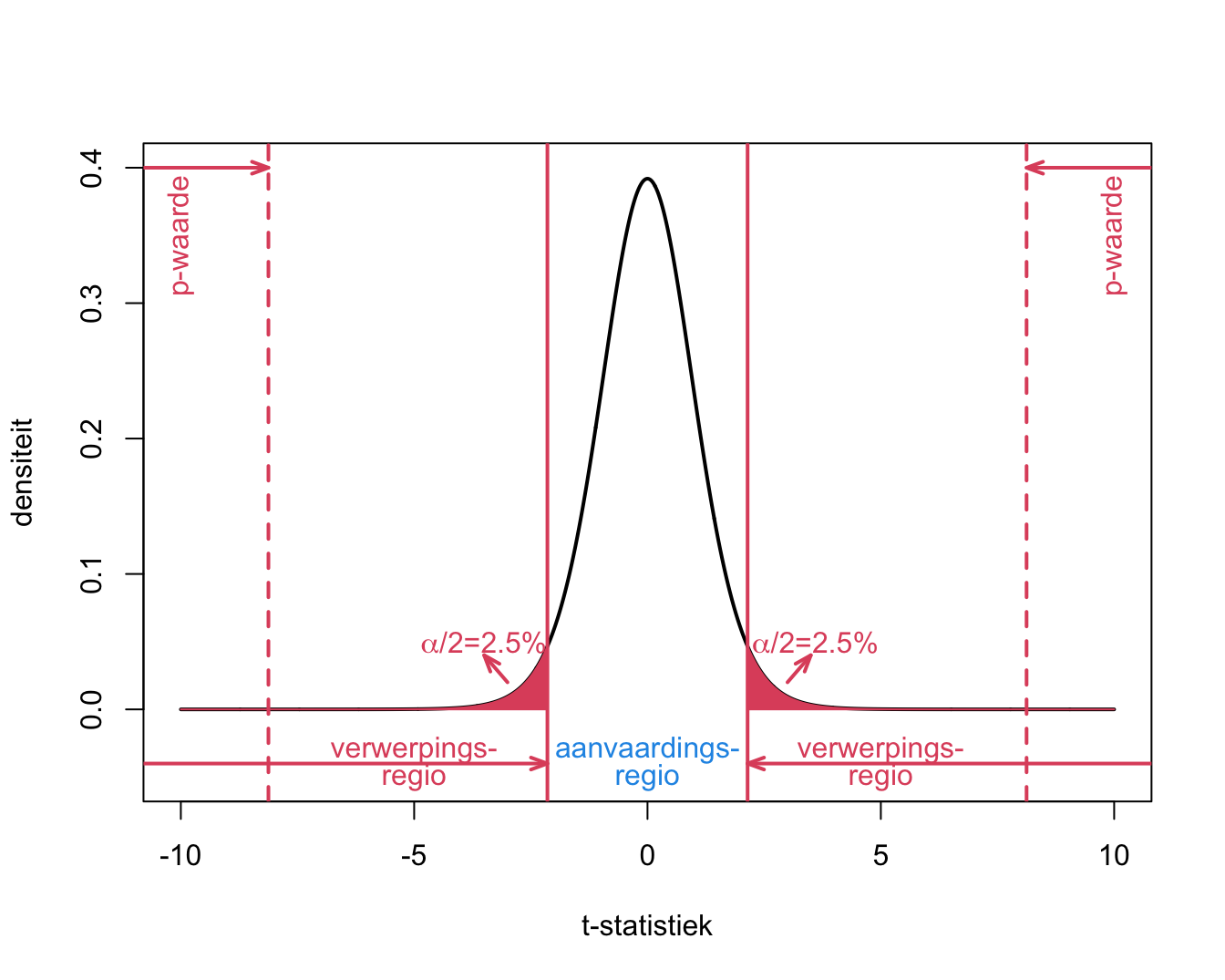

De begrippen p-waarde, kritieke waarde, significantie-niveau, verwerpings- en aanvaardingsregio worden weergegeven in Figuur 5.9.

Figuur 5.9: Interpretatie van p-waarde, kritieke waarde, verwerpingsgebied, aanvaardingsgebied voor het captopril voorbeeld.

5.5.6 Beslissingsfouten

Aangezien de beslissing over het al dan niet verwerpen van de nulhypothese bepaald wordt door slechts een steekproef te observeren, kunnen volgende beslissing genomen worden:

| Besluit | H0 | H1 |

|---|---|---|

| Aanvaard H0 | OK | Type II (β) |

| Verwerp H0 | Type I (α) | OK |

Het schema geeft de vier mogelijke situaties:

\(H_0\) is in werkelijkheid waar, en dit wordt ook besloten aan de hand van de statistische test (dus geen beslissingsfout)

\(H_1\) is in werkelijkheid waar, en dit wordt ook besloten aan de hand van de statistische test (dus geen beslissingsfout)

\(H_0\) is in werkelijkheid waar, maar aan de hand van de statistische test wordt besloten om \(H_0\) te verwerpen en \(H_1\) te concluderen. Dus \(H_1\) wordt foutief besloten. Dit is een zogenaamde type I fout.

\(H_1\) is in werkelijkheid waar, maar aan de hand van de statistische test wordt besloten om \(H_0\) te aanvaarden. Dit is een zogenaamde type II fout. Dus \(H_0\) wordt foutief aanvaard.